در سالهای اخیر با رشد سریع مدلهای زبانی بزرگ، یکی از پرسشهای اساسی برای تیمهای فنی این است که آیا باید سراغ ساخت مدل هوش مصنوعی از صفر بروند یا از مدلهای آماده و موجود استفاده کنند. ساخت مدل اختصاصی گرچه جذاب به نظر میرسد، اما فرایندی بسیار پرهزینه و زمانبر است که به دادههای عظیم، زیرساخت سختافزاری قدرتمند و تیمی چندتخصصی نیاز دارد. در مقابل، مدلهای آماده یا قابل استفاده از طریق API این امکان را فراهم میکنند که بدون صرف منابع سنگین، خیلی سریع قابلیتهای پیشرفته هوش مصنوعی را به محصولات اضافه کنید.

نکته جالب اینجاست که این مدلها میتوانند طیف گستردهای از وظایف هوش مصنوعی و یادگیری ماشین را تنها با مقدار کمی داده آموزشی انجام دهند. از جمله این وظایف میتوان به دستهبندی (Classification)، استخراج موجودیتها (Entity Extraction) و مدلسازی موضوعی (Topic Modeling) اشاره کرد که هرکدام کاربردهای زیادی دارند. در بسیاری از موارد هم هرچه مدل بزرگتر باشد، عملکرد آن بهتر خواهد بود.

بنابراین وقتی قصد دارید هوش مصنوعی را وارد محصولات خود کنید، یک پرسش اساسی مطرح میشود: آیا باید مدل اختصاصی خودتان را بسازید و آموزش دهید، یا از یک مدل ازپیشآموزشدیده استفاده کنید؟ در این مقاله قصد داریم به این سوال مهم جواب دهیم. با ما همراه باشید.

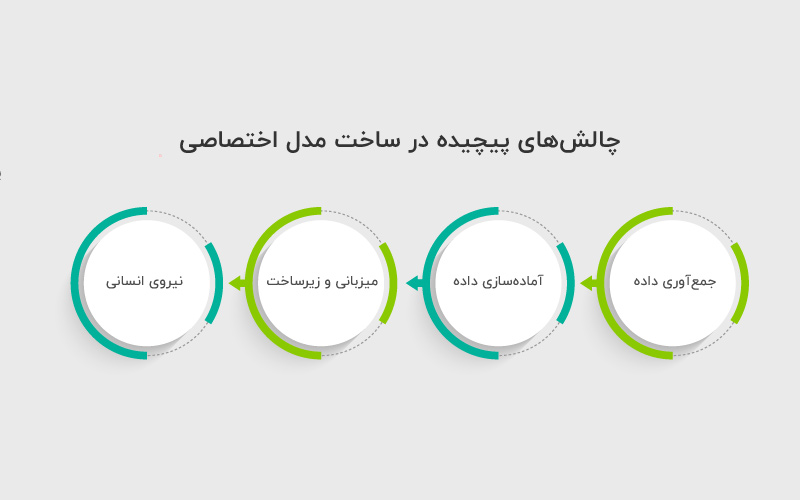

چالشهای پیچیده در ساخت مدل هوش مصنوعی از صفر

چه در حال ساخت یک مدل ساده دستهبندی باشید و چه یک اپلیکیشن پیچیدهی تولید محتوا، فرایند توسعه و آموزش مدل شامل مراحل متعددی است. این مراحل علاوهبر زمانبر بودن، هزینههای پنهانی نیز به همراه دارند.

۱- جمعآوری داده

اولین گام در آموزش یک مدل، گردآوری داده است. هرچه مسئلهای که میخواهید با هوش مصنوعی حل کنید پیچیدهتر باشد، به دادهی بیشتری نیاز دارید. مدلهای زبانی بزرگی که توانایی تولید محتوای منسجم دارند، به گیگابایتها داده آموزشی احتیاج دارند. حتی وظایف سادهتری مثل دستهبندی نیز برای رسیدن به عملکرد مطلوب، به هزاران نمونه آموزشی نیاز دارند. حتما میدانید که در بیشتر مواقع، این دادهها را بهسادگی در قالب یک فایل آماده روی Kaggle نمیتوانید پیدا کنید.

۲- آمادهسازی داده

بر اساس تحقیقات، دانشمندان داده تقریبا نیمی از زمان خود را صرف پاکسازی دادهها میکنند. این فرایند شامل حذف دادههای نامعتبر، اصلاح دادههای اشتباه و حتی در صورت کار با متن، فیلتر و تعدیل دادهها برای جلوگیری از محتوای مضر است.

کار با متن برای ساخت مدلهای زبانی بزرگ بهمراتب پیچیدهتر است، چون زبان ذاتا آشفته و چندلایه است. چالشهایی مثل طعنه، ابهام و کنایه، فرایند آموزش را سختتر میکنند. به همین دلیل، جمعآوری و آمادهسازی داده برای مدلهای زبانی اهمیتی حیاتی دارد؛ چراکه باید تمام ظرافتها و پیچیدگیهای زبان انگلیسی (یا هر زبان هدف) را در نظر بگیرید.

۳- میزبانی و زیرساخت

هرچه دادهها و مدل شما بزرگتر باشند، به قدرت پردازشی بیشتری برای آموزش و میزبانی آن نیاز خواهید داشت. بسیاری از مدلهای زبانی بزرگ به صدها کارت گرافیک (GPU) نیاز دارند و وقتی هزینه سایر تجهیزات، زیرساختهای میزبانی و موارد جانبی را هم حساب کنید، صورتحسابی در مقیاس میلیونها و حتی دهها میلیون دلار پیش روی شما خواهد بود.

علاوهبر این، مدل به نگهداری مداوم نیاز دارد؛ از جمله بازآموزیهای دورهای، بهروزرسانی ویژگیها، افزودن دادههای جدید و هزینههای جاری میزبانی. این موارد در طول زمان بهشدت روی هم انباشته میشوند.

۴- نیروی انسانی

مواردی که تا اینجا گفتیم تنها بخشی از فرایند ساخت یک مدل از صفر بودند. توسعه مدل اختصاصی شامل جمعآوری دادههای آموزشی مرتبط، استخراج ویژگیها، طراحی چارچوب، ایجاد رابطها و موارد دیگر است. برای ساختن مدلی مناسب، ممکن است به تخصصهای متنوعی مانند مهندس داده، دانشمند داده، مهندس پلتفرم و حتی کارشناسان حوزهی کسبوکار نیاز داشته باشید.

ایجاد یک مدل سفارشی از پایه میتواند به فرایندی طولانی و زمانبر تبدیل شود که تمرکز تیم را از کارهای مهمتر منحرف میکند. بنابراین واضح است که توسعه و آموزش مدلها میتواند هزینههای هنگفتی از نظر زمان و پول به همراه داشته باشد.

قدرت مدلهای ازپیشآموزشدیده

مدلهای ازپیشآموزشدیده میتوانند به شکل چشمگیری هزینه و تلاش موردنیاز برای یادگیری عمیق را کاهش دهند. چرا که دیگر نیازی نیست زمان و پول زیادی صرف جمعآوری و پاکسازی دادهها کنید، چه برسد به زیرساخت و دانش تخصصی لازم برای آموزش صحیح مدلها.

مدلهای ازپیشآموزشدیده چیستند؟

مدل ازپیشآموزشدیده، در واقع یک مدل یادگیری ماشین است که توسط توسعهدهندگان یا پژوهشگران دیگر طراحی، آموزش داده شده و در دسترس قرار گرفته است. دانشمندان داده برای آموزش این مدلها از مجموعهدادههای بسیار عظیم استفاده میکنند و شرکتها معمولا آنها را برای حل مسائلی به کار میگیرند که نیازمند حجم انبوهی از داده هستند.

در دنیای هوش مصنوعی (AI)، چیزی به نام «مدل کامل» وجود ندارد. هیچ مدلی نیست که همیشه صد درصد دقیق عمل کند. بنابراین، ساخت هر مدل نوعی معامله میان تلاش و دقت است. نکته اینجاست که مدلهای ازپیشآموزشدیده اغلب به همان اندازه دقیق، یا حتی دقیقتر از مدلهایی هستند که شما خودتان میسازید؛ چرا که متخصصانی حرفهای و متمرکز روی توسعه مدلها، آنها را طراحی و آموزش دادهاند.

چرا استفاده از مدلهای زبانی ازپیشآموزشدیده منطقی است؟

مطالعات نشان میدهد که مدلهای زبانی بزرگِ ازپیشآموزشدیده در بسیاری از موارد عملکردی برابر با مدلهایی دارند که بهطور خاص برای یک وظیفهی سفارشی آموزش داده شدهاند. این یعنی تمام تلاشهایی که پیشتر درباره ساخت مدل اختصاصی گفتیم عملا بیفایده میشوند؛ چون با انتخاب یک مدل آماده میتوانید به همان اندازه، یا حتی بهتر، نتیجه بگیرید.

علاوهبر این، بسیاری از مدلهای ازپیشآموزشدیده مثل Cohere یک API ساده و کاربرپسند ارائه میدهند. تنها با چند خط کد، میتوانید به تمام قابلیتهای یک مدل بزرگ ازپیشآموزشدیده دسترسی داشته باشید، بدون آنکه هزینههای پنهان ساخت و نگهداری مدل را متحمل شوید. کیتهای توسعه نرمافزار (SDK) برای Python، Node.js و Go این امکان را فراهم میکنند که هوش مصنوعی زبانی را بهراحتی وارد هر استکی کنید، در حالی که مسئولیت میزبانی، بهروزرسانی و حتی تضمین ایمنی مدل بر عهده تیم دیگری است.

مدلهایی مانند GPT یا مدلهایی که توسط شرکتهایی مثل Cohere آموزش داده شداند، بهطور منظم با استفاده از پارامترهای دقیق و بهخوبی تنظیمشده آموزش میبینند و در نتیجه، دقت بسیار بالایی را ارائه میدهند؛ همانطور که از متریکهایی که منتشر میکنند، مشخص است.

با وجود اینکه این مدلها ازپیشآموزشدیده هستند، همچنان کنترل زیادی روی خروجیها خواهید داشت. همچنین با مهندسی پرامپتها (Prompt Engineering) و تنظیم پارامترهای مختلف میتوانید تاثیر قابلتوجهی روی نتایج بگذارید. اگر هم دادههای اختصاصی خودتان را دارید و میخواهید آنها را وارد مدل کنید، بهسادگی میتوانید یک مدل ازپیشآموزشدیده را فاینتیون (Fine-tune) کنید. اغلب مدلها این امکان را فراهم میکند که دادههای آموزشی خود را بارگذاری کنید و وقتی این دادهها با قدرت یک مدل زبانی بزرگ ترکیب میشوند، نتایج شگفتانگیزی به دست میآید.

نمونههای واقعی NLP با استفاده از مدلهای ازپیشآموزشدیده

فقط استارتاپهای کوچک نیستند که از مدلهای ازپیشآموزشدیده بهره میبرند. بسیاری از شرکتهای بزرگ نیز ترجیح میدهند به جای اختصاص منابع عظیم برای ساخت مدلهای درونسازمانی، از مدلهای زبانی بزرگ (LLM) استفاده کنند. در ادامه چند نمونه NLP را با هم میبینیم:

۱- تشخیص موجودیتهای نامگذاریشده (NER)

تشخیص موجودیتهای نامگذاریشده یا NER به مدل دستور میدهد نوع کلمات یا عبارات موجود در متن ورودی را مشخص کند. برای مثال، اگر جملهای بگوید: «جان در تاریخ ۲۴ دسامبر ۱۹۹۰ به دنیا آمد»، مدل تشخیص میدهد که «جان» یک نام است، «۲۴ دسامبر» یک تاریخ و «۱۹۹۰» یک سال.

شرکتهای بزرگی مثل Netflix، Hulu و Disney+ از این رویکرد برای بهبود پیشنهادهای محتوایی خود استفاده میکنند.

۲- دستهبندی متن (Text Classification)

دستهبندی خودکار متن برای شرکتهایی که با ارتباطات گسترده مشتریان سروکار دارند بسیار حیاتی است. برای نمونه، شرکتهای فعال در شبکههای اجتماعی یا حوزهی بازی نیاز دارند محتوای تولیدشده توسط کاربران را در مقیاس بالا و با سرعت زیاد تعدیل کنند. با دستهبندی محتوا به «مسموم» یا «مضر»، کل این فرایند میتواند بهصورت خودکار انجام شود.

بهجای آنکه هزاران نمونه محتوای مسموم جمعآوری کرده و مدلی اختصاصی برای این کار آموزش دهید، میتوانید بهسادگی از مدل toxicity فاینتیونشده شرکتهایی مثل Cohere استفاده کنید و ظرف چند دقیقه این کار را انجام دهید.

۳- خلاصهسازی (Summarization)

تولید خلاصه ممکن است در نگاه اول کار سادهای به نظر برسد، اما انجام آن در مقیاس وسیع بسیار دشوار است. بسیاری از شرکتهای مالی و موسسات حقوقی، خلاصهی گزارشهای طولانی را بسیار ارزشمند میدانند. در حالیکه این سازمانها تیمهای داخلی یادگیری ماشین ندارند، استفاده از مدلهای ازپیشآموزشدیده بهترین انتخاب است.

سخن پایانی

وقتی پای استفاده از هوش مصنوعی در میان باشد، همیشه انتخاب میان «ساخت از صفر» یا «استفاده از مدل آماده» مطرح است. اما همانطور که دیدیم، هزینهها، زمان و پیچیدگیهای ساخت مدل اختصاصی بهقدری بالاست که در بسیاری از پروژهها توجیه چندانی ندارد. در مقابل، مدلهای ازپیشآموزشدیده فرصتی فراهم میکنند تا بدون دغدغههای فنی و زیرساختی، خیلی سریع از قدرت مدلهای زبانی بزرگ بهرهمند شوید.

از تشخیص موجودیتها گرفته تا دستهبندی محتوا و خلاصهسازی متون، مدلهای آماده نهتنها کارآمد و دقیق هستند، بلکه انعطاف لازم برای شخصیسازی و فاینتیون را هم در اختیار شما قرار میدهند. بنابراین اگر میخواهید تمرکز خود را روی توسعه محصول و خلق ارزش برای کاربر بگذارید، مدلهای ازپیشآموزشدیده بهترین انتخاب خواهند بود.

منابع

سوالات متداول

مدلی است که روی دادههای عظیم آموزش دیده و بهصورت API/SDK در دسترس است. وقتی محدودیت زمان/هزینه دارید یا نیاز به نتیجه قابلقبول سریع دارید، انتخاب اول است.

وقتی به مزیت رقابتیِ غیرقابل کپی نیاز دارید، داده انحصاری در مقیاس بزرگ دارید یا با قیود سختگیرانه حریم خصوصی/Latency on-prem دستوپنجه نرم میکنید.

بله، ولی کیفیت بین مدلها متفاوت است. با ارزیابی بومی (دیتاست فارسی) و در صورت نیاز فاینتیون سبک/راهنمایی زبانی (Style/Instruction) کیفیت را بالا ببرید.

دیدگاهتان را بنویسید