هوش مصنوعی و مدلهای زبانی بزرگ (LLMs) بهسرعت در حال تغییر نحوه تعامل ما با فناوری هستند. با این حال، بیشتر این مدلها تنها از طریق سرویسهای ابری ارائه میشوند که نگرانیهای امنیتی و حریم خصوصی و هزینههای بالایی به همراه دارند. علاوهبر این، نیاز به اینترنت پایدار و وابستگی به زیرساختهای بیرونی باعث میشود بسیاری از افراد و سازمانها نتوانند بهراحتی از این فناوری استفاده کنند. در چنین شرایطی، Ollama بهعنوان ابزاری متنباز وارد میدان شده است که امکان اجرای مدلهای زبانی را بهصورت محلی و روی سیستمهای شخصی فراهم میکند.

در این مقاله از بلاگ آسا، بهصورت گامبهگام با Ollama آشنا میشویم. سپس روش نصب و راهاندازی را بررسی میکنیم. در ادامه، به کاربردهای عملی Ollama و مدلهای پشتیبانیشده توسط آن میپردازیم.

معرفی Ollama

Ollama یک ابزار متنباز است که با هدف سادهسازی اجرای مدلهای زبانی بزرگ بهصورت محلی معرفی شد. فلسفه اصلی آن کاهش وابستگی به سرویسهای ابری و فراهمکردن کنترل بیشتر برای کاربران روی دادهها و مدلهاست. این پروژه تحت مجوز MIT منتشر شده و در گیتهاب در دسترس است، بنابراین توسعهدهندگان میتوانند آزادانه در بهبود آن مشارکت کنند یا آن را مطابق نیازهای خود تغییر دهند.

تمرکز Ollama بر این است که کاربران بتوانند تنها با چند دستور ساده، مدلهای پیشرفته هوش مصنوعی را روی سیستمهای شخصی خود اجرا کنند؛ بدون آنکه به سختافزارهای پیچیده یا فرایندهای نصب دشوار نیاز داشته باشند. همین سادگی و شفافیت باعث شده در مدت کوتاهی توجه بسیاری از توسعهدهندگان و علاقهمندان به هوش مصنوعی را جلب کند.

معماری و اجزای کلیدی

معماری Ollama بهگونهای طراحی شده که هم سبک باشد و هم انعطافپذیر. هسته اصلی آن شامل یک محیط ایزوله (sandbox) برای اجرای مدلهاست که امنیت و پایداری را تضمین میکند. مدیریت مدلها نیز از طریق یک سیستم فایل اختصاصی انجام میشود؛ جایی که میتوان فایلهای مدل را دانلود، حذف، کپی یا نسخهبندی کرد.

یکی از نقاط قوت این ابزار، پشتیبانی از adapter-based fine-tuning مانند LoRA است. این روش بهجای تغییر کل وزنهای مدل، تنها بخشی از آن را تنظیم میکند و در نتیجه منابع کمتری مصرف میشود. علاوهبر این، Ollama از تکنیکهایی مانند کوانتیزاسیون (Quantization) برای کاهش حجم مدل و افزایش سرعت پردازش بهره میبرد.

پیکربندی مدلها نیز بهصورت فایلهای متنی ساده (Model File) انجام میشود که امکان شخصیسازی تنظیمات و اشتراکگذاری آنها را فراهم میکند.

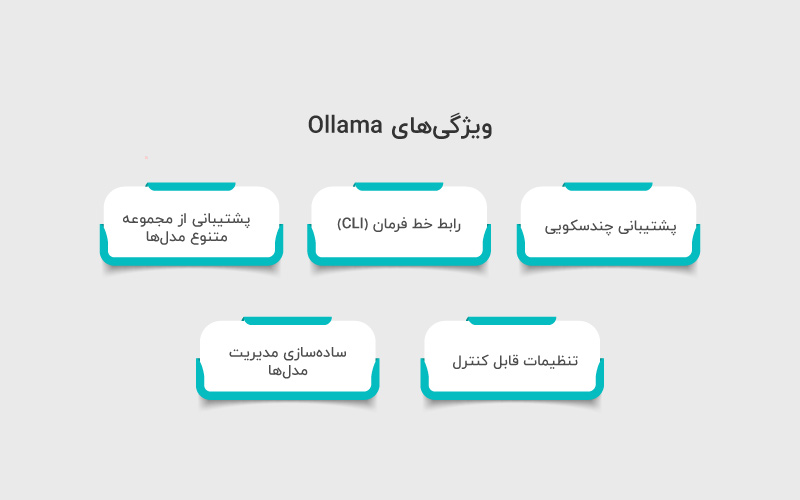

ویژگیهای Ollama

- پشتیبانی چندسکویی (Cross-platform): الاما روی macOS و لینوکس بهطور کامل پشتیبانی میشود و نسخه ویندوز نیز در حالت پیشنمایش قرار دارد.

- رابط خط فرمان (CLI): کاربران میتوانند تنها با چند دستور ساده، مدلها را نصب و اجرا کنند. همچنین ابزارهایی از سوی جامعه توسعه داده شدهاند که رابط گرافیکی (GUI) را نیز برای Ollama فراهم میکنند.

- پشتیبانی از مجموعه متنوع مدلها: از LLaMA 2 و 3 گرفته تا Mistral، Code Llama، LLaVA و Phi-3، همگی با Ollama سازگار هستند.

- تنظیمات قابل کنترل: امکان تغییر پارامترهایی مانند temperature، Top-P، Top-K و تعداد توکن خروجی، تجربه انعطافپذیری را برای کاربر فراهم میکند.

- سادهسازی مدیریت مدلها: با دستوراتی مثل pull برای دانلود، run برای اجرا و rm یا cp برای مدیریت نسخهها، کار با مدلها بسیار آسان است.

نصب Ollama و شروع کار

برای کار با Ollama نیاز است که سیستم خود را از لحاظ سختافزاری تجهیز و مدلهای لازم را دانلود و نصب کنید. فرایند انجام آن به شکل زیر است:

۱. پیشنیازها (سختافزار، GPU، OS)

Ollama بهگونهای طراحی شده که روی سختافزارهای شخصی هم قابل استفاده باشد اما بسته به مدل انتخابی نیاز به منابع متفاوتی دارد. برای اجرای روان مدلهای بزرگتر، داشتن کارت گرافیک (GPU) با حافظه مناسب توصیه میشود. در سیستمهایی بدون GPU، همچنان میتوان از Ollama استفاده کرد اما سرعت پاسخگویی کاهش پیدا خواهد کرد.

از نظر سیستمعامل، Ollama در حال حاضر روی macOS و لینوکس پشتیبانی کامل دارد. نسخه ویندوز نیز در مرحله پیشنمایش (Preview) قرار دارد و احتمالا در آینده بهطور رسمی منتشر خواهد شد.

۲. مراحل نصب بر روی سیستمهای مختلف

macOS: نصب بهسادگی از طریق دستور Homebrew انجام میشود:

|

1 |

brew install ollama |

Linux: بسته به توزیع لینوکس، میتوان از اسکریپت نصب ارائهشده یا دستورات خط فرمان استفاده کرد. بهعنوان مثال:

|

1 |

curl –fsSL https://ollama.com/install.sh | sh |

Windows: نسخه Preview فعلا بهصورت فایل نصبی (Installer) ارائه شده و مراحل نصب مشابه نرمافزارهای رایج ویندوز است.

۳. دانلود مدل و اجرای اولین مدل

پس از نصب، اولین گام دانلود یک مدل است. Ollama این فرایند را بسیار ساده کرده است:

برای دریافت مدل:

|

1 |

ollama pull llama2 |

برای اجرای مدل:

|

1 |

ollama run llama2 |

پس از اجرای دستور بالا، کاربر میتواند مستقیما با مدل وارد تعامل شود و پرسشهای خود را مطرح کند.

۴. مدیریت مدلها با دستورهای CLI

Ollama مجموعهای از دستورات خط فرمان را برای مدیریت مدلها فراهم میکند، از جمله:

- ollama list ← نمایش مدلهای موجود روی سیستم

- ollama rm <model> ← حذف یک مدل

- ollama cp <source> <target> ← کپیکردن و تغییر نام مدل

- ollama create <name> ← ساخت مدل جدید بر اساس یک Model File سفارشی

این دستورات باعث میشوند کاربر بدون نیاز به ابزارهای جانبی بتواند کل چرخه نصب، اجرا و مدیریت مدلها را تنها از طریق ترمینال کنترل کند.

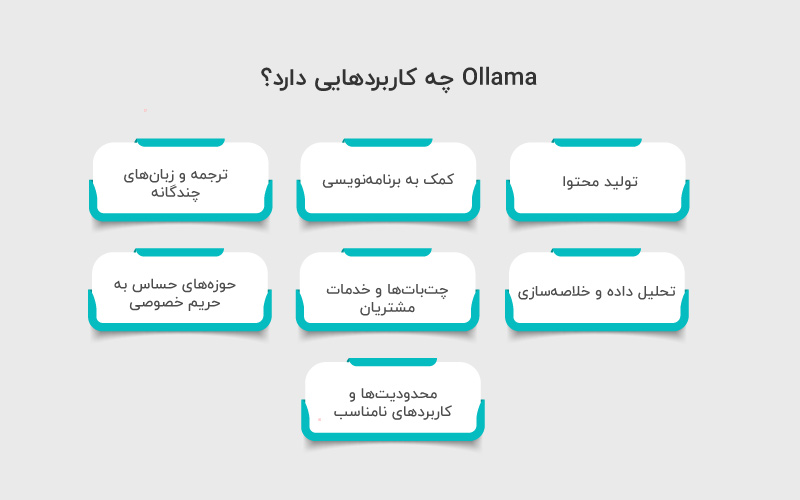

Ollama چه کاربردهایی دارد؟

در این بخش به معرفی کاربردهای عملی Ollama در دنیای واقعی میپردازیم و نشان میدهیم چگونه اجرای محلی مدلهای زبانی میتواند در زمینههای مختلف از تولید محتوا تا تحلیل داده و پشتیبانی مشتری بهکار گرفته شود.

۱. کمک به برنامهنویسی

مدلهای سازگار با Ollama مانند Code Llama یا Mistral توانایی تولید کد، رفع اشکال و مستندسازی را دارند. توسعهدهندگان میتوانند از این قابلیت برای شتابدادن به فرایند برنامهنویسی و آزمایش نمونههای اولیه استفاده کنند. علاوهبر این، امکان سفارشیسازی مدلها متناسب با نیاز هر پروژه وجود دارد.

۲. تولید محتوا

Ollama میتواند بهعنوان دستیار نوشتاری برای تولید مقالات، وبلاگها، پستهای شبکههای اجتماعی و حتی داستانسرایی خلاقانه استفاده شود. اجرای محلی این ابزار باعث میشود نویسندگان بدون نگرانی از افشای اطلاعات محرمانه یا ایدههای شخصی، از کمک مدلهای زبانی بهره ببرند.

۳. ترجمه و زبانهای چندگانه

یکی از مزایای کلیدی Ollama پشتیبانی از مدلهایی است که توانایی پردازش چندین زبان را دارند. این ویژگی امکان ترجمه متون، بومیسازی محتوا و تعامل با کاربران بینالمللی را بدون نیاز به سرویسهای ابری فراهم میکند.

۴. تحلیل داده و خلاصهسازی

Ollama میتواند اسناد متنی طولانی را خلاصه کند یا دادهها را تحلیل و نکات کلیدی را استخراج کند. این قابلیت در زمینههایی مانند پژوهش علمی، مدیریت اسناد سازمانی یا حتی مرور سریع اخبار و گزارشها بسیار کاربردی است.

۵. چتباتها و خدمات مشتریان

با اجرای مدلها روی سیستمهای محلی یا سرورهای اختصاصی، سازمانها میتوانند چتباتهای هوشمندی بسازند که بدون ارسال دادهها به سرورهای خارجی، خدمات مشتریان را ارائه دهند. این رویکرد علاوهبر افزایش امنیت دادهها، هزینههای سرویسهای ابری را نیز کاهش میدهد.

۶. حوزههای حساس به حریم خصوصی

در حوزههایی مانند پزشکی، حقوقی یا مالی، محرمانگی دادهها اهمیت بالایی دارد. Ollama با اجرای محلی مدلها این امکان را فراهم میکند که دادهها هرگز از محیط امن سازمان خارج نشوند. همین ویژگی باعث شده بسیاری از نهادهای حساس به سمت این ابزار جذب شوند.

۷. محدودیتها و کاربردهای نامناسب

با وجود مزایا، Ollama برای همه سناریوها مناسب نیست. به دلیل نیاز به منابع سختافزاری، اجرای مدلهای بسیار بزرگ روی سیستمهای ضعیف میتواند کند یا حتی غیرممکن باشد. همچنین برای پروژههایی که نیازمند مقیاسپذیری بالا و همزمانی هزاران درخواست هستند، راهکارهای ابری همچنان انتخاب بهتری محسوب میشوند.

مدلهای پشتیبانیشده در Ollama

Ollama از مجموعهای متنوع از مدلهای زبانی و مولتیمودال پشتیبانی میکند که امکان اجرای محلی آنها روی سیستمهای شخصی را فراهم میکند. این مدلها شامل نسخههای مختلف LLaMA، مدلهای تخصصی کدنویسی، مدلهای مولتیمودال و گزینههای سبکتر برای سختافزارهای محدود هستند. کاربران میتوانند مدلها را دانلود، اجرا و حتی سفارشیسازی کنند تا متناسب با نیاز خود باشند.

- خانواده LLaMA (LLaMA 2 و LLaMA 3): مدلهای عمومی و چندمنظوره با عملکرد بالا در پردازش زبان طبیعی.

- Mistral و Mixtral: مدلهای سبک و سریع، مناسب برای سیستمهایی با منابع محدود.

- Code Llama: مدل تخصصی برای توسعهدهندگان برای تولید کد، رفع اشکال و مستندسازی پروژهها.

- LLaVA: مدل مولتیمودال که قابلیت پردازش تصویر و متن را بهطور همزمان دارد.

- Phi-3 و مدلهای سبکتر: گزینههای کمحجم و بهینه برای کاربردهای سبک و تست سریع.

Ollama امکان استفاده از Model File برای اضافه کردن مدلهای جدید یا اعمال تنظیمات سفارشی را فراهم میکند.

مزایا، چالشها و ملاحظات Ollama

این بخش نگاهی عملی و واقعبینانه به استفاده از Ollama ارائه میدهد. در آن مزایای اجرای مدلهای هوش مصنوعی بهصورت محلی، از جمله حفظ حریم خصوصی، کاهش هزینه و امکان شخصیسازی بررسی میشود. همزمان، محدودیتها و چالشهای احتمالی مانند نیاز به سختافزار مناسب، مقیاسپذیری محدود و پشتیبانی ناقص سیستمعاملها مطرح میشوند. علاوهبر این، ملاحظات اخلاقی و قانونی برای استفاده مسئولانه از مدلها نیز توضیح داده میشود.

مزایا

- حریم خصوصی و کنترل دادهها: اجرای مدلها بهصورت محلی به کاربران و سازمانها امکان میدهد دادهها هرگز از سیستم خود خارج نشود و نگرانیهای امنیتی و حریم خصوصی کاهش یابد.

- کاهش هزینهها: با حذف نیاز به سرویسهای ابری و پرداخت هزینههای مداوم، پروژههای بلندمدت میتوانند با بودجه کمتری اجرا شوند.

- عملکرد سریعتر و پاسخدهی لحظهای: اجرای مدل روی سیستم شخصی، تاخیر شبکه را حذف میکند و سرعت پاسخدهی به کاربر افزایش مییابد.

- امکان شخصیسازی: کاربران میتوانند تنظیمات مدل و حتی وزنهای آن را مطابق نیاز خود تغییر دهند و تجربهای اختصاصی از هوش مصنوعی داشته باشند.

چالشها

- نیاز به منابع سختافزاری: مدلهای بزرگتر به GPU و حافظه کافی نیاز دارند و روی سیستمهای ضعیف ممکن است کند عمل کنند.

- محدودیت مقیاسپذیری: اجرای همزمان هزاران درخواست یا پروژههای بزرگ همچنان بهتر است روی سرویسهای ابری انجام شود.

- پشتیبانی محدود سیستمعاملها: Ollama در حال حاضر بیشترین پشتیبانی را روی macOS و لینوکس دارد و نسخه ویندوز هنوز در مرحله پیشنمایش است.

- نگهداری و بهروزرسانی: کاربران مسئول بهروزرسانی مدلها و خود Ollama هستند که میتواند در پروژههای بزرگ چالشبرانگیز باشد.

- ریسکهای استفاده نادرست: مانند هر مدل هوش مصنوعی، خطر تعصب، سوگیری یا تولید محتوا نامناسب وجود دارد.

ملاحظات اخلاقی

- کنترل تعصب و انصاف (Bias): کاربران باید مدلها را بررسی کرده و در صورت لزوم، تنظیمات یا فیلترهای مناسب اعمال کنند.

- شفافیت و قابلیت ردیابی تصمیمات مدل: در کاربردهای حساس، باید مطمئن شد که تصمیمات مدل قابل توضیح و بررسی هستند.

- نظارت انسانی: حتی در اجرای محلی، توصیه میشود همیشه یک ناظر انسانی برای بازبینی خروجیها وجود داشته باشد.

- رعایت الزامات قانونی و دادهای: کاربران باید قوانین حفاظت از دادهها مانند GDPR را رعایت کنند و از اشتراکگذاری اطلاعات حساس بدون مجوز خودداری نمایند.

مقایسه Ollama با دیگر راهکارها

در این بخش، Ollama را با سایر راهکارهای رایج مدلهای زبانی مقایسه میکنیم. هدف، روشن کردن مزایا و محدودیتهای استفاده محلی در برابر سرویسهای ابری و ابزارهای مشابه است.

| معیار / ابزار | Ollama (اجرای محلی) | سرویسهای ابری (OpenAI, Anthropic, Azure) | ابزارهای محلی مشابه (LocalAI, TextGenerationWebUI) |

| دسترسی و مقیاسپذیری | محدود به منابع سیستم کاربر | بسیار بالا و مناسب پروژههای بزرگ و همزمان | محدود به منابع سیستم کاربر |

| بهروزرسانی مدلها | نیاز به بهروزرسانی دستی | همیشه آخرین نسخهها در دسترس | بهروزرسانی دستی یا وابسته به جامعه توسعهدهنده |

| هزینه | بدون هزینه سرویس ابری، تنها هزینه سختافزار | نیاز به اشتراک یا پرداخت بر اساس مصرف | هزینه کم یا رایگان، وابسته به سختافزار |

| کنترل روی دادهها | کامل، دادهها روی سیستم محلی باقی میمانند | محدود، دادهها روی سرورهای ابری پردازش میشوند | کامل، دادهها روی سیستم محلی باقی میمانند |

| سادگی استفاده و مدیریت مدلها | رابط CLI ساده، مدیریت مدلها راحت | بسیار ساده، از طریق API و پنل مدیریت | پیچیدهتر، نیاز به تنظیمات دستی و اسکریپتها |

| پشتیبانی سیستمعامل | macOS و لینوکس کامل، ویندوز پیشنمایش | کراسپلتفرم و بدون محدودیت | معمولا لینوکس و macOS، ویندوز بسته به پروژه |

| عملکرد / تاخیر | سریع در پاسخدهی محلی | ممکن است با تاخیر شبکه همراه باشد | مشابه Ollama، وابسته به سختافزار |

نتیجهگیری

Ollama نشان میدهد که استفاده از هوش مصنوعی پیشرفته دیگر محدود به سرویسهای ابری یا سازمانهای بزرگ نیست. با امکان اجرای محلی مدلها، افراد و شرکتها میتوانند بدون نگرانی از افشای دادهها، پروژههای هوش مصنوعی خود را با هزینه کمتر و انعطافپذیری بالاتر توسعه دهند.

منابع

geeksforgeeks.org | medium.com | hostinger.com | deepchecks.com | itsfoss.com

سوالات متداول

Ollama یک ابزار متنباز برای اجرای مدلهای زبانی بزرگ بهصورت محلی است که کنترل کامل روی دادهها و امکان شخصیسازی را فراهم میکند، در حالی که سرویسهای ابری نیاز به اتصال دائمی اینترنت و پرداخت هزینه دارند.

پشتیبانی کامل برای macOS و لینوکس وجود دارد. نسخه ویندوز در حالت پیشنمایش است و هنوز پشتیبانی رسمی ندارد.

مدلهای بزرگ نیازمند GPU و حافظه کافی هستند. برای مدلهای سبکتر و تستهای سریع، سختافزار معمولی هم کفایت میکند.

دیدگاهتان را بنویسید