در حوزه پردازش زبان طبیعی، مدل Sentence Transformer بهعنوان یکی از پیشرفتهای مهم مطرح شده است. این مدل جملهها و متنهای طولانی را به بردارهای عددی تبدیل میکند که ماشینها میتوانند آنها را درک و پردازش کنند. تفاوت اصلی آن با روشهای قدیمی این است که تنها به کلمات جداگانه توجه نمیکند، بلکه معنای کلی جمله و ارتباط بین کلمات را نیز در نظر میگیرد.

اهمیت این فناوری در آن است که امکان ساخت سیستمهایی هوشمندتر، مانند موتورهای جستجو، چتباتها و ابزارهای تحلیل متن را فراهم میکند. در ادامه مقاله به تعریف Sentence Transformer، معماری و مدلهای از پیش آموزشدیده، روشهای فاینتیونینگ و کاربردهای عملی آن خواهیم پرداخت.

Sentence Transformer چیست؟

Sentence Transformer مدلی بر پایه معماری ترنسفورمر است که برای تولید نمایش برداری جملات (Sentence Embeddings) طراحی شده است. این مدل به جای اینکه فقط روی سطح کلمات یا توکنها تمرکز کند، کل جمله یا حتی پاراگراف را به یک بردار عددی متراکم تبدیل میکند.

تفاوت اصلی آن با مدلهایی مثل BERT این است که خروجی Sentence Transformer بهگونهای آموزش دیده که بتواند معنای جملات را در فضای برداری بهتر بازنمایی کند. به این ترتیب، جملاتی که از نظر معنایی مشابه هستند، بردارهای نزدیکتری خواهند داشت.

این ویژگی باعث شده Sentence Transformer در کارهایی مثل:

- Semantic Search (جستجوی معنایی)

- Text Clustering (خوشهبندی متون)

- Text Similarity (محاسبه شباهت متون)

- Classification (طبقهبندی جملات و اسناد)

به یکی از پرکاربردترین ابزارها در پردازش زبان طبیعی (NLP) تبدیل شود.

دلیل وجود Sentence Transformer

یکی از محدودیتهای مدلهایی مثل BERT این است که برای مقایسه یا جستجوی شباهت بین جملات، باید هر بار زوججملهها دوباره پردازش شوند. این کار هزینه محاسباتی بسیار بالایی دارد و در مقیاس بزرگ (مثل جستجو بین میلیونها سند) عملا کارآمد نیست.

برای حل این مشکل، معماری سیامی (Siamese Network) یا همان شبکههای دوقلو در Sentence Transformer معرفی شد. در این معماری، هر جمله جداگانه به یک بردار متراکم (Dense Vector) تبدیل میشود. به این ترتیب، مقایسه جملات فقط با یک محاسبه فاصله (مانند کسینوس سیمیلاریتی) انجام میشود، بدون نیاز به اجرای دوباره کل مدل برای هر جفت جمله.

مرحله مهم بعدی، Pooling است که نمایه کلمات (Token Embeddings) را به یک نمایه جملهای واحد تبدیل میکند. روشهای مختلفی برای این کار وجود دارد، از جمله:

- میانگینگیری (Mean Pooling): گرفتن میانگین بردارهای همه کلمات.

- ماکزیمم (Max Pooling): انتخاب بیشترین مقدار هر بعد از بین کلمات.

- CLS Token: استفاده از بردار ویژه [CLS] که در ابتدای جمله قرار میگیرد.

این ترکیب از معماری سیامی و روشهای pooling باعث میشود Sentence Transformer هم دقیقتر و هم بسیار سریعتر از مدلهای قدیمی در وظایفی مثل جستجو، خوشهبندی یا طبقهبندی جملات عمل کند.

Sentence Transformer چطور کار میکند؟

Sentence Transformer با استفاده از معماری ترنسفورمر، جملات را به بردارهای عددی متراکم (Embeddings) تبدیل میکند که معنای هر جمله را بهطور دقیق بازتاب میدهند. فرایند عملکرد این مدل معمولا شامل مراحل زیر است:

۱. ورود جمله و محاسبه Embedding

هر جمله ورودی ابتدا به توکنها شکسته میشود و از طریق لایههای ترنسفورمر عبور میکند. خروجی نهایی به صورت یک بردار عددی (معمولا ۳۸۴ تا ۱۰۲۴ بُعدی) ذخیره میشود که بازنمایی معنایی جمله را در خود دارد.

۲. استفاده معمولی در مقابل فاینتیونینگ

در حالت استفاده معمولی (Pretrained)، مدل از وزنهایی استفاده میکند که قبلا روی دیتاستهای بزرگ آموزش دیده و آماده استفاده در وظایفی مثل جستجوی معنایی یا محاسبه شباهت است.

در حالت فاینتیونینگ، میتوان مدل را با دادههای خاص یک حوزه (مثلا پزشکی یا حقوقی) دوباره آموزش داد تا دقت و کارایی آن در همان حوزه افزایش پیدا کند.

۳. رنکینگ مجدد (Reranking) با Cross-Encoder

گاهی Sentence Transformer برای تولید Embedding کافی نیست. در این حالت، از Cross-Encoder استفاده میشود.

- Sentence Transformer ابتدا هزاران جمله یا سند را سریع رتبهبندی میکند.

- سپس Cross-Encoder (که دو جمله را همزمان بررسی میکند) برای بازرتبهبندی دقیقتر نتایج برتر به کار گرفته میشود. این ترکیب سرعت و دقت را همزمان فراهم میکند.

۴. نکات بهینهسازی

برای کارایی بهتر، معمولا از تکنیکهای زیر استفاده میشود:

- Batching: پردازش همزمان چندین جمله برای افزایش سرعت.

- کاهش مصرف حافظه با استفاده از مدلهای کوچکتر (مانند all-MiniLM-L6-v2).

- کاهش زمان inference با تکنیکهایی مثل کوانتیزیشن یا استفاده از GPU.

مدلهای آماده Sentence Transformer

یکی از مزیتهای مهم Sentence Transformer وجود طیف گستردهای از مدلهای از پیش آموزشدیده (Pretrained Models) است که بهصورت عمومی در دسترس قرار دارند. این مدلها روی دادههای بزرگ و متنوع آموزش دیدهاند و میتوانند بدون نیاز به آموزش مجدد، در پروژههای مختلف استفاده میشوند. برخی از مهمترین دستهها عبارتند از:

| مدل | ابعاد بردار | کاربرد اصلی | توضیح مختصر |

| all-MiniLM-L6-v2 | 384 | جستجوی معنایی، خوشهبندی | سبک و سریع، مناسب برای پردازش حجم بالای داده |

| all-mpnet-base-v2 | 768 | Semantic Search، پاسخگویی به پرسشها | دقت بالاتر نسبت به MiniLM، مناسب برای پروژههای حساس |

| multi-qa-MiniLM-L6-cos-v1 | 384 | بازیابی اطلاعات، Q&A | مدل چندزبانه بهینه برای پرسش و پاسخ سریع |

| distiluse-base-multilingual-cased-v2 | 512 | متون چندزبانه | پوشش بیش از ۱۵ زبان، سرعت مناسب و دقت متوسط |

| maux-gte-persian | 768 | جستجوی معنایی فارسی، طبقهبندی متون | مدل بهینه شده برای زبان فارسی، کاربرد در سیستمهای محلی |

منابع مدلها

تمامی مدلهای فوق و صدها مدل دیگر در مخزن Sentence Transformers روی Hugging Face در دسترس هستند. کاربران میتوانند با توجه به زبان، حوزه تخصصی و محدودیتهای سختافزاری مدل مناسب خود را انتخاب کرده و حتی در صورت نیاز آن را فاینتیون کنند.

مثال عملی Sentence Transformer

در این مثال نحوه بارگذاری یک مدل آماده Sentence Transformer، تولید امبدینگ برای چند جمله و مقایسه شباهت آنها نشان داده میشود. علاوهبر نمونه انگلیسی، نمونهای برای زبان فارسی نیز ارائه شده است.

نمونه انگلیسی

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 |

from sentence_transformers import SentenceTransformer, util # بارگذاری مدل آماده model = SentenceTransformer(‘all-MiniLM-L6-v2’) # نمونه جملات sentences = [ “Artificial intelligence is transforming the world.”, “Machine learning is a subset of AI.”, “The weather is sunny today.” ] # تولید Embedding embeddings = model.encode(sentences, convert_to_tensor=True) # مقایسه شباهت با کسینوس cos_sim = util.pytorch_cos_sim(embeddings, embeddings) print(“Cosine Similarity Matrix:”) print(cos_sim) |

نمونه فارسی

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 |

from sentence_transformers import SentenceTransformer, util # بارگذاری مدل فارسی model_fa = SentenceTransformer(‘xmanii/maux-gte-persian’) # نمونه جملات فارسی sentences_fa = [ “هوش مصنوعی جهان را متحول میکند.”, “یادگیری ماشین زیرمجموعهای از هوش مصنوعی است.”, “امروز هوا آفتابی است.” ] # تولید Embedding embeddings_fa = model_fa.encode(sentences_fa, convert_to_tensor=True) # مقایسه شباهت با کسینوس cos_sim_fa = util.pytorch_cos_sim(embeddings_fa, embeddings_fa) print(“Cosine Similarity Matrix (Persian):”) print(cos_sim_fa) |

تحلیل نتایج

- مقادیر ماتریس کسینوس شباهت نزدیک به ۱ نشاندهنده جملات با معنای مشابه است.

- در نمونه انگلیسی، دو جمله اول بهدلیل مفهومی نزدیکتر بودن شباهت بالاتری دارند.

- در نمونه فارسی نیز، دو جمله اول به همان ترتیب بالاترین شباهت را نشان میدهند.

- جمله سوم در هر دو زبان از نظر معنایی با دو جمله دیگر متفاوت است و مقدار کسینوس پایینتری دارد.

فاینتیونینگ Sentence Transformer با داده اختصاصی

یکی از قابلیتهای کلیدی Sentence Transformer، امکان فاینتیونینگ مدلهای آماده با دادههای اختصاصی است. این روش به توسعهدهندگان اجازه میدهد تا دقت مدل را در حوزههای خاص، مانند پزشکی، حقوق، یا تجارت، افزایش دهند.

روش پیشنهادی AWS

AWS در یک مقاله عملی، فاینتیونینگ Sentence Transformer را با مثال محصولات آمازون توضیح داده است. روند کلی به این صورت است:

۱. انتخاب مدل پایه: از مدلهای عمومی مانند all-MiniLM-L6-v2 یا all-mpnet-base-v2 به عنوان مدل پایه استفاده میشود.

۲. آمادهسازی دادهها: جملات مرتبط با دستهبندی یا وظیفه مشخص جمعآوری و پیشپردازش میشوند.

۳. استفاده از GPU: برای افزایش سرعت و کاهش زمان آموزش، از GPU یا محیطهای محاسباتی موازی استفاده میشود.

۴. تست و ارزیابی: پس از فاینتیونینگ، مدل روی دادههای جداگانه ارزیابی میشود تا دقت آن سنجیده شود.

نکات عملی

- انتخاب مدل پایه: بسته به حجم داده و دقت مورد انتظار، میتوان مدل سبکتر یا دقیقتر انتخاب کرد.

- پردازش داده: پاکسازی متن، توکنسازی و نگهداری تعادل بین کلاسها از اهمیت بالایی برخوردار است.

- استفاده از GPU: فاینتیونینگ مدلهای بزرگ بدون GPU بسیار زمانبر و پرهزینه است؛ استفاده از GPU توصیه میشود.

- Batch Size و Learning Rate: تنظیم مناسب این پارامترها برای جلوگیری از Overfitting و افزایش کارایی ضروری است.

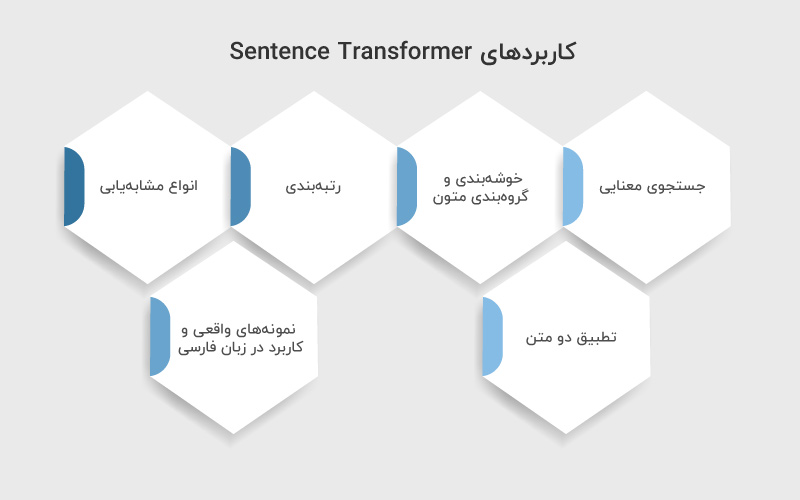

کاربردهای Sentence Transformer

Sentence Transformer بهدلیل توانایی تولید بردارهای متراکم و نمایانگر معنای جملات، در بسیاری از کاربردهای پردازش زبان طبیعی استفاده میشود. مهمترین این کاربردها عبارتند از:

جستجوی معنایی (Semantic Search)

با استفاده از Embeddingهای تولیدشده، سیستم قادر است مستندات یا جملاتی که بیشترین ارتباط معنایی با پرسش کاربر دارند را سریع پیدا کند. این کاربرد در موتورهای جستجوی داخلی، پایگاههای داده و سیستمهای پرسش و پاسخ گسترده اهمیت دارد.

خوشهبندی و گروهبندی متون

جملات یا اسناد با Embedding مشابه، در یک خوشه قرار میگیرند. این روش در تحلیل موضوعی، استخراج الگوها و سازماندهی دادههای متنی بزرگ کاربرد دارد.

رتبهبندی (Reranking)

در سیستمهای بازیابی اطلاعات، ابتدا یک رتبهبندی اولیه با روشهای سریع انجام شده و سپس Sentence Transformer برای رتبهبندی دقیقتر نتایج برتر استفاده میشود.

انواع مشابهیابی (Paraphrase Mining)

شناسایی جملاتی با معنی مشابه، حتی اگر از نظر واژگانی متفاوت باشند. این قابلیت در تولید محتوای مشابه، تحلیل شبکههای اجتماعی و کاهش دادههای تکراری کاربرد دارد.

تطبیق دو متن (Sentence Textual Similarity – STS)

محاسبه میزان شباهت معنایی بین دو جمله یا متن که در وظایفی مانند ارزیابی پاسخ، تشخیص مشابهت متون و تحلیل احساسات به کار میرود.

نمونههای واقعی و کاربرد در زبان فارسی

- ایجاد موتور جستجوی داخلی برای مقالات فارسی

- طبقهبندی پرسشها و پاسخها در سیستمهای پشتیبانی مشتری

- تحلیل شباهت بین متون خبری یا اسناد حقوقی به زبان فارسی

چالشها و محدودیتهای استفاده از Sentence Transformer

استفاده از Sentence Transformer با وجود مزایای متعدد، با مجموعهای از چالشها و محدودیتها همراه است که پیش از پیادهسازی باید به آنها توجه داشت:

۱. نیاز به منابع پردازشی (GPU)

پردازش امبدینگها بهخصوص برای مدلهای بزرگ و دادههای حجیم، نیازمند GPU یا محیطهای محاسباتی موازی است. استفاده از CPU تنها برای حجم داده کم مناسب است و در غیر این صورت زمان اجرا بهطور قابل توجهی افزایش پیدا میکند.

۲. کیفیت دادههای آموزش

دقت مدل وابسته به کیفیت دادههای استفاده شده در فاینتیونینگ یا انتخاب مدل پایه است. دادههای نویزی یا نامتوازن میتوانند عملکرد مدل را کاهش دهند.

۳. مسائل زبان فارسی

- کمبود دادههای با کیفیت برای آموزش یا فاینتیونینگ

- نیاز به انتخاب مدل بهینه برای پردازش متون فارسی

۴. طول متن و نیاز به تقسیمبندی (Chunking)

جملات یا اسناد طولانی باید به بخشهای کوتاهتر تقسیم شوند تا مدل بتواند آنها را به صورت موثر پردازش کند و بردارهای دقیق تولید کند.

۵. تعادل بین دقت و سرعت

مدلهای بزرگتر دقت بالاتری ارائه میدهند اما زمان پردازش بیشتری میطلبند. انتخاب مدل مناسب باید براساس نیاز پروژه، منابع موجود و اهمیت دقت انجام شود.

نتیجهگیری

Sentence Transformer یکی از ابزارهای قدرتمند در حوزه پردازش زبان طبیعی است که با تبدیل جملات به بردارهای متراکم و معنایی، امکان تحلیل، بازیابی و طبقهبندی متون را به صورت موثر فراهم میکند. استفاده از مدلهای آماده و پیشآموزشدیده، همراه با قابلیت فاینتیونینگ، این امکان را به توسعهدهندگان میدهد که پروژههای خود را در حوزههای تخصصی و چندزبانه با دقت بالا پیادهسازی کنند.

با این حال، انتخاب مدل مناسب، توجه به کیفیت دادهها، و مدیریت منابع پردازشی از نکات کلیدی برای دستیابی به عملکرد بهینه است. در نهایت، Sentence Transformer ابزاری انعطافپذیر است که میتواند پایهای برای ایجاد سیستمهای پیشرفته جستجوی معنایی، تحلیل شباهت جملات و کاربردهای متنوع NLP باشد.

منابع

geeksforgeeks.org | aws.amazon.com | sbert.net | huggingface.co

سوالات متداول

بله، مدلهایی مانند maux-gte-persian برای پردازش متون فارسی بهینه شدهاند و میتوانند در سیستمهای جستجو، دستهبندی و تحلیل متون فارسی مورد استفاده قرار گیرند.

فاینتیونینگ زمانی لازم است که نیاز به دقت بالا در یک حوزه خاص باشد، مانند پزشکی، حقوق یا تجارت. با فاینتیونینگ میتوان مدل را با دادههای اختصاصی آموزش داد تا عملکرد آن در وظایف خاص افزایش یابد.

انتخاب مدل بستگی به کاربرد، حجم داده، نیاز به سرعت پردازش و دقت مورد انتظار دارد. مدلهای سبکتر برای پردازش سریع و حجم داده زیاد مناسباند، در حالی که مدلهای بزرگتر دقت بالاتری ارائه میدهند.

دیدگاهتان را بنویسید