با گسترش سریع هوش مصنوعی، دادههای شخصی ما بیش از هر زمان دیگری در معرض جمعآوری، تحلیل و پردازش قرار گرفتهاند؛ از سیستمهای تشخیص چهره و تبلیغات هدفمند گرفته تا چتباتها، اپلیکیشنهای هوشمند و مدلهای یادگیری ماشینی. این تغییر عظیم، هم فرصتساز است و هم پرسشهایی جدی درباره امنیت دادهها مطرح میکند: چه اطلاعاتی از ما جمع میشود؟ چگونه پردازش میشود؟ چه کسانی به آن دسترسی دارند؟ در میانه این تحولات، مفهوم حریم خصوصی وارد مرحلهای تازه شده است؛ مرحلهای که در آن فناوری از قانون پیش افتاده و کاربران بیش از همیشه نیازمند آگاهی و محافظت هستند.

در این مقاله، بهجای پرداختن به مفاهیم کلی، بهصورت عملی و کاربردی مهمترین خطرات، تهدیدات و ریسکهای هوش مصنوعی برای حریم خصوصی را بررسی میکنیم. سپس توضیح میدهیم قوانین مهم دنیا مانند GDPR، CCPA، NIST و سایر چارچوبها چه رویکردی دارند. در نهایت، مجموعهای از راهکارهای واقعی و قابل اجرا ارائه میشود تا هم کاربران و هم سازمانها بتوانند از دادههای خود بهتر محافظت کنند.

چرا هوش مصنوعی تهدیدی برای حریم خصوصی است؟

هوش مصنوعی بهطور طبیعی برای عملکرد بهتر به دادههای بزرگ و متنوع نیاز دارد. هرچه داده بیشتر باشد، مدل میتواند رفتار کاربران را دقیقتر تحلیل کند و تصمیمات دقیقتری بگیرد. اما همین وابستگی شدید به دادهها، خطراتی ایجاد میکند: حجم بالای دادههایی که جمعآوری میشود، نوع اطلاعاتی که پردازش میگردد و میزان عمقی که مدلها قادر به تحلیل آن هستند، باعث میشود مرزهای کلاسیک حریم خصوصی دیگر پاسخگو نباشند.

علاوهبر این، کاربران معمولا در جریان نیستند که دادههایشان چگونه استفاده یا ذخیره میشود و چه افرادی به آن دسترسی دارند. نتیجه این وضعیت، ظهور ریسکهایی مانند سوءاستفاده از داده، تحلیلهای ناخواسته، نشت اطلاعات و تصمیمگیریهای غیرشفاف است.

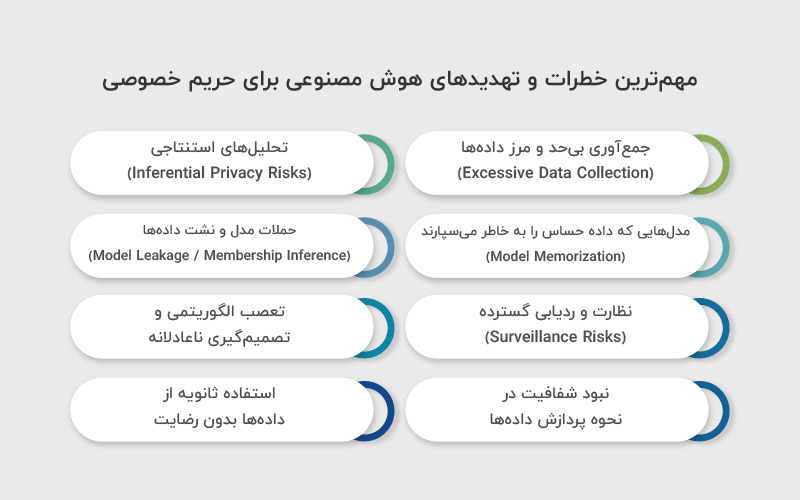

مهمترین خطرات و تهدیدهای هوش مصنوعی برای حریم خصوصی

هوش مصنوعی میتواند به شکل مستقیم و غیرمستقیم باعث آسیب به حریم خصوصی کاربران شود. برخی خطرات از خود مدلها ناشی میشود (مثل استنتاج اطلاعات مخفی)، برخی از شیوه جمعآوری داده و برخی از نحوه استفاده سازمانها از خروجی مدلها. این ریسکها معمولا بهصورت ترکیبی عمل میکنند و اگر کنترل نشوند، میتوانند باعث نشت داده، نظارت گسترده یا تصمیمگیریهای ناعادلانه شوند.

۱. جمعآوری بیحد و مرز دادهها (Excessive Data Collection)

- اپلیکیشنها و سرویسهای هوش مصنوعی اغلب حجم زیادی داده میگیرند

- حتی اطلاعات حساس (Biometrics، صدا، چهره، احساسات)

این رفتار در بسیاری از کشورها خلاف اصل «حداقلگرایی داده» در مقررات حفظ حریم خصوصی است.

۲. تحلیلهای استنتاجی (Inferential Privacy Risks)

AI میتواند اطلاعات جدیدی را از روی دادههای ظاهرا بیخطر استخراج کند:

- احتمال بیماری

- ویژگیهای شخصیتی

- ارزش درآمدی

- وضعیت رابطه

- باورهای خصوصی

این خطر در گزارشهای IBM و NIST بهعنوان یکی از «مهمترین چالشهای سال ۲۰۲۵» معرفی شده است.

۳. مدلهایی که داده حساس را به خاطر میسپارند (Model Memorization)

مدلهای زبانی و مولد (مثل GPTها یا مدلهای تصویرساز) گاهی بخشی از دادههای آموزشی را حفظ میکنند و ممکن است بطور ناخواسته آنها را افشا کنند.

مثالها:

- لو رفتن شماره تلفن

- آدرس

- ایمیل

- اطلاعات پزشکی

- فایلهای خصوصی

این یکی از داغترین نگرانیهای حال حاضر در مباحث جهانی AI safety است.

۴. حملات مدل و نشت دادهها (Model Leakage / Membership Inference)

مهاجم میتواند با پرسوجوهای خاص متوجه شود:

- چه دادههایی در آموزش بوده

- یک داده مشخص متعلق به چه فردی است

- یا مدل را مجبور به بازتولید داده محرمانه کند

این حملات حتی در مدلهای متن بسته نیز قابل انجام است.

۵. نظارت و ردیابی گسترده (Surveillance Risks)

سیستمهای:

- تشخیص چهره

- LLMهای پایش مکالمات

- دوربینهای هوشمند

- ابزارهای پایش رفتار کارکنان

میتوانند سطح جدیدی از نظارت را ایجاد کنند. مشکل اینجاست که بسیاری از این کاربردها بدون رضایت واقعی کاربران انجام میشود.

۶. تعصب الگوریتمی و تصمیمگیری ناعادلانه

وقتی مدلها از دادههای اشتباه یا ناقص تغذیه شوند:

- ممکن است افراد را به اشتباه در طبقهبندیهای حساس قرار دهند

- تصمیمهای اشتباه در حوزههای مالی، شغلی، امنیتی و حتی قانونی بگیرند

این موضوع در گزارش OVIC و Stanford HAI از مهمترین چالشهای اخلاقی شناخته شده است.

۷. نبود شفافیت در نحوه پردازش دادهها

کاربر معمولا نمیداند:

- چه دادهای جمع میشود

- چطور پردازش میشود

- مدل روی چه دیتاستی ساخته شده

- چه کسی به اطلاعات دسترسی دارد

- آیا دادهها حذف میشوند یا نه

در گزارش Dataguard این موضوع «ریشه اصلی بیاعتمادی کاربران» معرفی شده است.

۸. استفاده ثانویه از دادهها بدون رضایت

دادههای کاربران معمولا برای اهداف جدید استفاده میشوند:

- آموزش مدل جدید

- بهبود محصول

- فروش به شرکتهای دیگر

- ایجاد پروفایل رفتاری

این مورد در GDPR صراحتا ممنوع است.

چه دادههایی بیشتر از همه در معرض خطر هستند؟

هوش مصنوعی برای عملکرد بهتر به دادههای دقیق و متنوع نیاز دارد، اما این دادهها میتوانند حریم خصوصی ما را به خطر بیندازند. برخی دادهها حساسیت بیشتری دارند و اگر افشا شوند یا مورد سوءاستفاده قرار بگیرند، پیامدهای جدی خواهند داشت.

دادههای مکانی (لوکیشن) میتوانند مسیرهای روزمره و محل زندگی شما را مشخص کنند، دادههای بیومتریک مانند چهره و اثر انگشت قابل تقلید نیستند و افشای آنها خطرناک است، پیامها و تاریخچه تعامل اطلاعات شخصی و خصوصی شما را آشکار میکنند و دادههای رفتاری میتوانند پروفایل دقیقی از عادات و علاقهمندیهای شما بسازند. شناخت این نوع دادهها به شما کمک میکند هنگام استفاده از سرویسهای هوش مصنوعی، تصمیمات آگاهانهتری بگیرید.

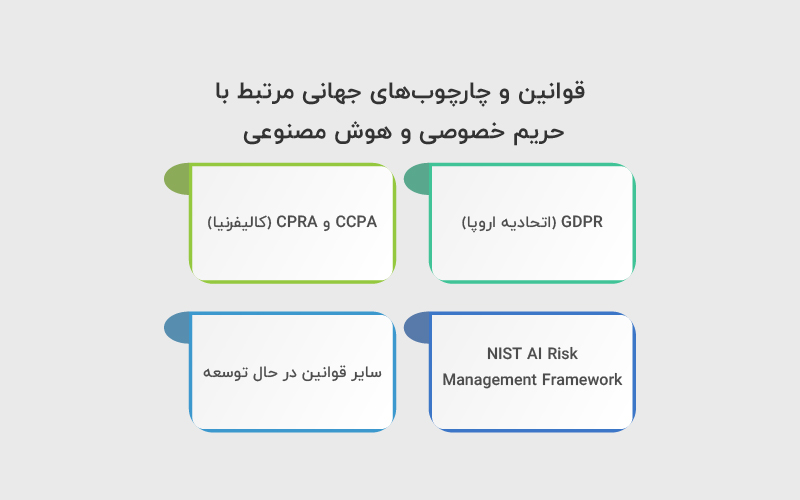

قوانین و چارچوبهای جهانی مرتبط با حریم خصوصی و هوش مصنوعی

قوانین و استانداردهای بینالمللی تلاش کردهاند شکاف میان سرعت رشد هوش مصنوعی و محافظت از دادههای شخصی را کم کنند. مقرراتی مانند GDPR در اروپا، CCPA/CPRA در آمریکا و چارچوبهایی مانند NIST AI RMF بر شفافیت، حداقلگرایی داده، رضایت آگاهانه و مدیریت ریسک تاکید دارند. این قوانین به سازمانها الزام میکنند که قبل از توسعه یا استقرار هر سیستم هوش مصنوعی، تاثیر آن بر حریم خصوصی را ارزیابی کنند و مکانیزمهایی برای محافظت از دادهها داشته باشند.

همچنین روندهای جدید قانونگذاری مثل قوانین AI Act در اروپا نشان میدهد که حریم خصوصی در مرکز توجه سیاستگذاران جهانی قرار گرفته است و در سالهای آینده سختگیرانهتر نیز خواهد شد.

۱. GDPR (اتحادیه اروپا)

مهمترین قانون دنیا در حوزه حریم خصوصی GDPR روی موارد زیر تاکید دارد:

- حداقلگرایی داده (Data Minimization)

- رضایت آگاهانه

- حق دسترسی و حذف داده

- ممنوعیت پردازش دادههای حساس بدون ضرورت

- الزام شفافیت در تصمیمگیری خودکار

۲. CCPA و CPRA (کالیفرنیا)

CCPA یکی از سختگیرانهترین قوانین برای شرکتهایی است که از داده کاربران آمریکایی استفاده میکنند و بر موارد زیر متمرکز است:

- شفافیت

- حق عدم فروش داده

- حق حذف

- اطلاعرسانی درباره جمعآوری و اشتراکگذاری دادهها

۳. NIST AI Risk Management Framework

در بسیاری از سازمانها به عنوان استاندارد ارزیابی AI استفاده میشود و یک چارچوب بسیار معتبر برای مدیریت ریسکهای زیر است:

- امنیت

- حریم خصوصی

- سوگیری

- شفافیت

- قابلیت حسابرسی

۴. سایر قوانین در حال توسعه

- EU AI Act

- OECD AI Principles

- APAC Privacy Acts

- قوانین استرالیا و کانادا

- سیاستهای جدید OpenAI و Google برای کنترل دادهها

راهکارهایی برای محافظت از حریم خصوصی در عصر هوش مصنوعی

حفاظت از حریم خصوصی در سیستمهای هوش مصنوعی فقط با ابزارهای امنیتی حل نمیشود؛ نیازمند ترکیبی از طراحی صحیح، شفافیت، کاهش داده، رمزگذاری، ممیزی و کنترلهای رفتاری است. چه سازمانها و چه کاربران، هر دو باید بدانند چگونه دادههایشان وارد سیستم میشود، چگونه پردازش میشود و چه مدت باقی میماند. در ادامه مهمترین راهکارها را بهصورت موردی و همراه با توضیح کوتاه میآورم:

- داده کمتر جمع کنید (Data Minimization): سازمانها باید فقط دادهای را جمعآوری کنند که واقعا ضروری است. هر داده اضافی یک ریسک اضافه ایجاد میکند. این اصل در GDPR بهعنوان یکی از پایههای حفظ حریم خصوصی معرفی شده است.

- استفاده از روشهای خصوصیسازی مدل (Privacy-Preserving ML): روشهایی مثل «یادگیری فدراتیو»، «Differential Privacy» و «رمزگذاری در حال استفاده» کمک میکنند مدلها بدون نیاز به ذخیرهسازی مستقیم داده خام، آموزش ببینند. این کار احتمال نشت اطلاعات یا افشای دادههای حساس را کاهش میدهد.

- شفافیت در چرخه عمر داده: کاربران باید بدانند چه اطلاعاتی جمعآوری میشود، چرا جمعآوری میشود، چه کسی به آن دسترسی دارد و چه زمانی حذف میشود. شفافیت باعث افزایش اعتماد و کاهش ریسک سوءاستفاده میشود.

- ارزیابی ریسک پیش از استقرار (AI Privacy Impact Assessment): قبل از راهاندازی هر سیستم AI باید ریسکهای احتمالی آن در زمینه حریم خصوصی شناسایی، تحلیل و کنترل شود. این ارزیابی کمک میکند نقاط ضعف مدلها و دادهها قبل از وقوع مشکل رفع شود.

- ایمنسازی مدل و پایش مستمر: باید مدلهای هوش مصنوعی مرتب تست شوند تا مشخص شود آیا دچار نشت داده، حفظ دادههای حساس یا آسیبپذیری در برابر حملات استنتاجی شدهاند یا خیر. نظارت منظم، امنیت و حریم خصوصی را در طول زمان تضمین میکند.

چگونه بفهمیم سرویسهای هوش مصنوعی دادههای ما را چگونه استفاده میکنند؟

کاربران اغلب نمیدانند دادههایشان چگونه جمعآوری و پردازش میشوند و چه کسانی به آن دسترسی دارند. برای شفافیت، اکثر سرویسها یک «اعلان حریم خصوصی» (Privacy Notice) ارائه میدهند که باید توضیح دهد چه دادههایی جمعآوری میشود، چرا استفاده میشود و چه کسی به آن دسترسی دارد.

همچنین کاربران باید به نشانههای هشداردهنده توجه کنند، مثل عدم وجود توضیح شفاف یا اشتراک داده بدون رضایت. شاخصهایی که میتوانند بررسی شوند شامل وجود تنظیمات حریم خصوصی، امکان محدود کردن دسترسیها، گزینه حذف دادهها و اطلاعرسانی درباره استفاده دادهها برای آموزش مدلهای هوش مصنوعی است. با توجه به این اطلاعات، کاربران میتوانند بهصورت فعال کنترل بیشتری روی دادههای شخصی خود داشته باشند.

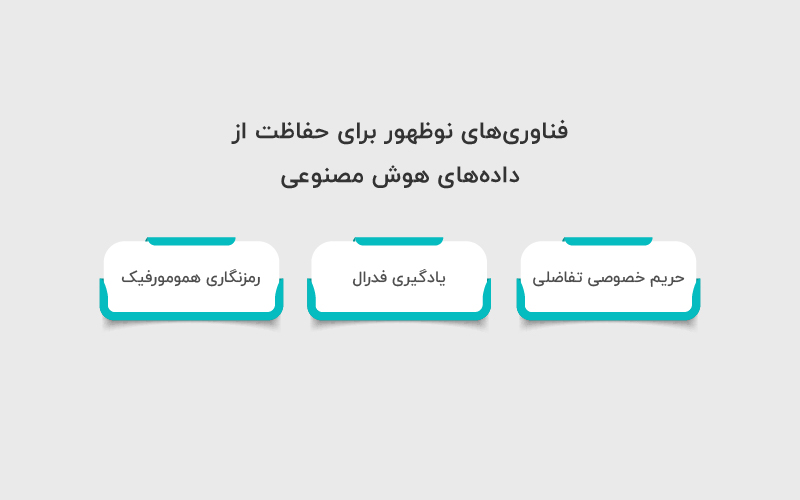

فناوریهای نوظهور برای حفاظت از دادههای هوش مصنوعی

فناوریهای ارتقای حریم خصوصی (Privacy Enhancing Technologies یا PETs)، از جمله حریم خصوصی تفاضلی، رمزنگاری همومورفیک و یادگیری فدرال یا مشارکتی، راهکارهای نویدبخشی برای رفع نگرانیهای مربوط به حریم خصوصی دادهها در عصر رشد سریع هوش مصنوعی ارائه میکنند.

حریم خصوصی تفاضلی روشی است که به کمک آن میتوان اطلاعات یک مجموعهداده را طوری منتشر کرد که الگوهای کلی و گروهی قابل مشاهده باشد اما جزئیات مرتبط با هر فرد پنهان بماند. در حوزه هوش مصنوعی، این کار معمولا با افزودن «نویز آماری» به دادههای خام برای محافظت از هویت افراد انجام میشود.

یادگیری فدرال به این معناست که بهجای جمعآوری همه دادههای آموزشی در یک مکان، مدل هوش مصنوعی روی چندین دستگاه یا سرور غیرمتمرکز آموزش داده میشود؛ بدون اینکه نمونههای داده بین آنها رد و بدل شود. این روش حفظ حریم خصوصی را تضمین میکند و در عین حال امکان بهبود مدل بهصورت کلی را فراهم میسازد.

رمزنگاری همومورفیک این امکان را فراهم میکند که پردازشها روی دادههای رمزنگاریشده انجام شود و خروجی نیز همچنان بهصورت رمزنگاریشده باقی بماند؛ بهگونهای که پس از رمزگشایی، نتیجه دقیقا معادل پردازش روی دادههای اصلی باشد. این فناوری به مدلهای هوش مصنوعی اجازه میدهد بدون نیاز به رمزگشایی دادهها، با آنها کار کنند.

این روشها و فناوریها ظرفیت بالایی برای تقویت حریم خصوصی در سیستمهای هوش مصنوعی دارند و میتوانند به افزایش اعتماد عمومی نسبت به این فناوری روبهرشد کمک کنند.

جمعبندی

هوش مصنوعی فرصتهای بزرگی برای توسعه خدمات دیجیتال ایجاد کرده؛ اما همین فناوری میتواند به یکی از جدیترین تهدیدهای حریم خصوصی تبدیل شود. از جمعآوری گسترده دادهها گرفته تا استنتاجهای پنهان، نشت اطلاعات و استفادههای ثانویه، کاربران در برابر طیف وسیعی از ریسکها قرار دارند.

قوانین جهانی مانند GDPR، CCPA و چارچوبهای معتبری مثل NIST تلاش کردهاند این ریسکها را مدیریت کنند اما بخشی از مسئولیت همچنان بر دوش سازمانها و کاربران باقی میماند.

آگاهی، شفافیت، استفاده از فناوریهای حفظ حریم خصوصی و انجام ارزیابیهای دورهای، مهمترین ابزارهایی هستند که میتوانند در عصر هوش مصنوعی از دادههای شخصی ما محافظت کنند.

منابع

transcend.io | nist.gov | ibm.com | hai.stanford.edu

سوالات متداول

AI میتواند دادههای شخصی شما را جمعآوری، تحلیل و حتی پیشبینی کند، بنابراین بدون کنترل، اطلاعات حساس شما ممکن است افشا شود یا مورد سوءاستفاده قرار بگیرد.

دادههای حساس شامل اطلاعات مکانی (لوکیشن)، چهره و دادههای بیومتریک، پیامها و تاریخچه تعامل، و دادههای رفتاری هستند.

از جمله نشت داده، تحلیلهای استنتاجی که اطلاعات مخفی شما را افشا میکنند، ردیابی گسترده، تصمیمگیری ناعادلانه و سوءاستفادههای ثانویه از دادهها.

بررسی تنظیمات حریم خصوصی، محدود کردن دسترسیها، مراقبت از دادههای حساس و رعایت نکات هنگام استفاده از ابزارهای GenAI، روشهای اصلی محافظت هستند.

دیدگاهتان را بنویسید