در سالهای اخیر، مدلهای زبانی بزرگ مثل GPT چهره اصلی پیشرفت در هوش مصنوعی بودهاند و بسیاری تصور میکردند رقابت با آنها ممکن نیست. اما در میانه این فضا، پروژهای از امارات با نام Falcon AI نگاهها را به خود جلب کرد. مدلی که نشان داد میتوان بدون وابستگی به شرکتهای بزرگ، به فناوری در سطح جهانی دست یافت. Falcon با هدف ایجاد یک مدل زبانی متنباز، کارآمد و قابلدسترسی برای پژوهشگران و سازمانها توسعه یافت و بهسرعت در میان جامعه هوش مصنوعی جایگاه ویژهای پیدا کرد.

در این مقاله، بررسی میکنیم که Falcon AI دقیقا چیست، چه ویژگیهایی آن را از سایر مدلها متمایز میکند و چرا به یکی از جدیترین رقبای GPT در حوزه مدلهای متنباز تبدیل شده است. همچنین به ساختار فنی، نسخههای مختلف، کاربردهای صنعتی و مسیر آینده این مدل خواهیم پرداخت تا تصویری روشن از جایگاه آن در اکوسیستم مدلهای زبانی امروز ارائه دهیم.

Falcon AI چیست؟

Falcon AI یک مدل زبانی بزرگ ( LLM) متنباز است که توسط موسسه Technology Innovation Institute (TII) در امارات متحده عربی توسعه یافته است. هدف از طراحی این مدل، ایجاد جایگزینی قدرتمند و در دسترس برای مدلهای تجاری مانند GPT بود تا پژوهشگران، دانشگاهها و شرکتها بتوانند بدون محدودیتهای مالکیتی، از ظرفیت مدلهای زبانی در مقیاس وسیع استفاده کنند. Falcon بر پایه معماری ترنسفورمر (Transformer) ساخته شده و برای درک و تولید زبان طبیعی در مقیاس چندزبانه طراحی شده است.

در زمان انتشار اولیه، دو نسخه اصلی از این مدل عرضه شد: Falcon 7B و Falcon 40B که عدد نشاندهنده تعداد پارامترهای آنهاست. بعدها نسخه پیشرفتهتر یعنی Falcon 180B نیز معرفی شد که از نظر اندازه و عملکرد، بهطور مستقیم با مدلهایی مانند GPT-3.5 و LLaMA-2 رقابت میکند. Falcon با تکیه بر RefinedWeb Dataset، مجموعهای شامل بیش از ۳.۵ تریلیون توکن از دادههای اینترنتی پالایششده، آموزش دیده و از روشهای بهینهسازی خاصی برای کاهش هزینه آموزش و افزایش دقت درک زبانی استفاده میکند.

معماری و نسخههای Falcon

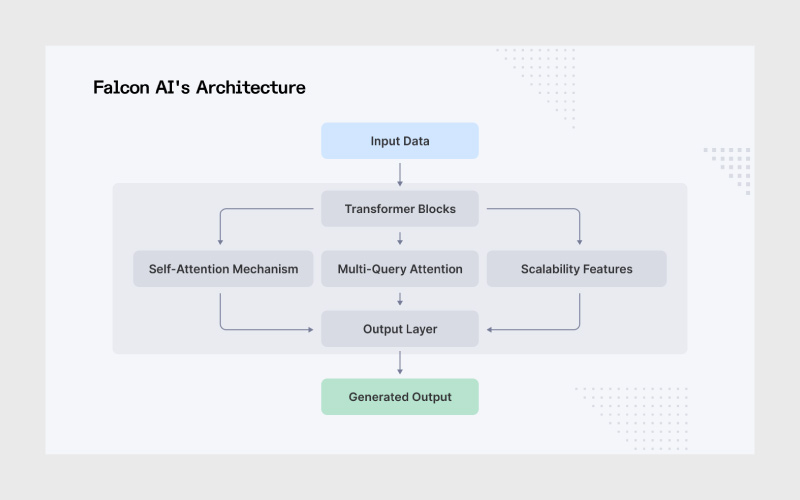

مدل Falcon بر پایهی معماری decoder-only Transformer ساخته شده است؛ همان ساختاری که در مدلهایی مانند GPT نیز استفاده میشود. این معماری بر تولید متن تمرکز دارد و از مکانیزم Self-Attention برای درک وابستگی میان کلمات استفاده میکند. با این حال، تیم TII تغییراتی در ساختار پایه اعمال کرده تا Falcon از نظر سرعت و بهرهوری حافظه نسبت به مدلهای مشابه عملکرد بهتری داشته باشد. یکی از این تغییرات استفاده از تکنیک multiquery attention است که باعث میشود مدل در هنگام استنتاج (inference) سریعتر عمل کند و حافظه GPU کمتری مصرف کند، قابلیتی که برای استقرار مدل در مقیاسهای واقعی اهمیت زیادی دارد.

از منظر نسخهها، Falcon در سه نسل اصلی توسعه یافته است:

- Falcon 7B: نسخهای سبکتر و مناسب برای پژوهشها و پروژههای کوچک که با حدود ۷ میلیارد پارامتر آموزش دیده است.

- Falcon 40B: نسخهای میانی با توانایی بالاتر در درک و تولید متن که برای کاربردهای سازمانی پیشنهاد میشود.

- Falcon 180B: بزرگترین و پیشرفتهترین نسخه تا امروز با بیش از ۱۸۰ میلیارد پارامتر که در ردهی مدلهای پیشرفته جهان مانند GPT-3.5 و LLaMA-2-70B قرار میگیرد.

نکته قابلتوجه در طراحی Falcon این است که برخلاف بسیاری از مدلهای تجاری، نسخههای آن متنباز و قابلدسترسی هستند. همین ویژگی باعث شده Falcon در پروژههای دانشگاهی، استارتاپها و حتی در برخی شرکتهای بزرگ بهعنوان پایه مدلهای اختصاصی استفاده میشود.

ویژگیها و مزایای کلیدی Falcon AI

Falcon AI بهدلیل ترکیب قدرت، کارایی و متنباز بودنش به یکی از برجستهترین مدلهای زبانی متنباز تبدیل شده است. برخی از ویژگیهای شاخص آن عبارتاند از:

- متنباز بودن کامل: دسترسی به کد منبع، دادههای آموزشی و وزن مدل باعث شده Falcon به گزینهای محبوب میان پژوهشگران و شرکتهایی تبدیل شود که بهدنبال استقلال از پلتفرمهای تجاری هستند.

- کارایی بالا در برابر اندازه: Falcon با وجود اندازه کوچکتر نسبت به مدلهایی مانند GPT-3 یا LLaMA-2، در بسیاری از بنچمارکها عملکردی همتراز یا حتی بهتر از آنها دارد.

- بهینهسازی منابع: طراحی سبک و کارآمد این مدل باعث شده در مقایسه با مدلهای مشابه، مصرف GPU و حافظه کمتری داشته باشد.

- دادههای آموزشی متنوع: آموزش با مجموعه دادههای چندزبانه و متون باکیفیت از منابع علمی و وب موجب شده درک زبانی عمیق و چندفرهنگیتری داشته باشد.

- سازگاری گسترده: Falcon با چارچوبهایی مثل PyTorch و Hugging Face Transformers کاملا سازگار است و در محیطهای ابری یا on-premise قابل استقرار است.

- امنیت و کنترل بیشتر: سازمانها میتوانند مدل را بدون وابستگی به ارائهدهندگان خارجی، در زیرساختهای خود میزبانی کنند؛ نکتهای مهم برای پروژههای با الزامات امنیتی بالا.

Falcon چه کاربردهایی دارد؟

Falcon AI به دلیل متنباز بودن و توان محاسباتی بالا، در حوزههای متنوعی کاربرد دارد:

۱. چتباتها و تولید محتوا

Falcon AI بهطور گسترده در ساخت دستیارهای هوشمند، چتباتهای سازمانی و تولید محتوا برای وبسایتها و شبکههای اجتماعی استفاده میشود. توانایی مدل در تولید متن طبیعی و پاسخ به پرسشهای پیچیده باعث شده کیفیت چتباتها و محتوای تولیدی بهمراتب بالاتر از مدلهای کوچکتر یا سنتی باشد.

۲. ترجمه و پردازش چندزبانه

با توجه به آموزش روی دادههای چندزبانه، Falcon قادر است متون پیچیده را بین زبانها ترجمه کند و تحلیلهای معنایی انجام دهد. این ویژگی به ویژه برای شرکتها و پروژههای بینالمللی که نیاز به پردازش اطلاعات چندزبانه دارند، ارزشمند است.

۳. پژوهش و آموزش

از آنجا که Falcon متنباز است، پژوهشگران و دانشجویان میتوانند به وزنها و دادههای آموزشی مدل دسترسی داشته باشند. این امکان باعث شده Falcon به یک ابزار اصلی برای fine-tuning، آزمایش الگوریتمهای جدید و توسعه مدلهای سفارشی تبدیل شود.

۴. کاربردهای صنعتی و سازمانی

Falcon در سیستمهای اطلاعاتی داخلی شرکتها، اتوماسیون فرایندهای متنی و تحلیل دادههای بزرگ کاربرد دارد. به عنوان مثال، میتواند برای پردازش گزارشها، ایمیلها و اسناد سازمانی استفاده شود تا تصمیمگیری سریعتر و بهینهتر انجام شود.

۵. تحلیل زبان طبیعی (NLP)

Falcon توانایی انجام خلاصهسازی متون طولانی، پاسخ به پرسشهای پیچیده، استخراج اطلاعات کلیدی و تحلیل احساسات را دارد. این قابلیت به شرکتها و پژوهشگران امکان میدهد دادههای متنی را به شکل ساختاریافته و قابل استفاده برای تصمیمگیری تبدیل کنند.

۶. توسعه مدلهای اختصاصی

Falcon به عنوان مدل پایه متنباز میتواند برای ساخت مدلهای تخصصی با حوزه کاربرد محدود مورد استفاده قرار گیرد. برای مثال، ایجاد یک مدل Falcon اختصاصی برای متون پزشکی، حقوقی یا مالی که نیاز به دقت و اصطلاحات تخصصی دارند.

۷. ادغام با API و ابزارها

Falcon به راحتی با ابزارهای موجود مانند Hugging Face، PyTorch و سرورهای ابری قابل ادغام است. این قابلیت باعث میشود سازمانها بتوانند فرایند استقرار و توسعه برنامههای هوش مصنوعی خود را سریع و منعطف انجام دهند.

نمونه کد: استفاده از Falcon AI برای تولید متن

در زیر یک نمونه کد سادهی Python نشان داده شده است که نحوه استفاده از Falcon AI برای تولید متن را توضیح میدهد:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 |

# نمونه کد Python برای شبیهسازی استفاده از مدل Falcon AI جهت تولید متن class FalconModel: def __init__(self): # مقداردهی اولیه مدل (این بخش فقط جایگزین است) pass def generate(self, prompt): # شبیهسازی پاسخ تولید شده بر اساس دستور داده شده responses = { “Explain the benefits of using Falcon AI in enterprise applications.”: ( “Falcon AI مزایای کلیدی متعددی برای برنامههای سازمانی ارائه میدهد. “ “اولاً، پردازش زبان طبیعی مقیاسپذیر و کارآمد فراهم میکند که میتوان از آن برای خودکارسازی خدمات مشتری، تولید محتوا و تحلیل احساسات استفاده کرد. “ “ثانیاً، Falcon AI با انعطافپذیری طراحی شده است و کسبوکارها میتوانند آن را در محیطهای مختلف مانند on-premises، ابری یا هیبریدی مستقر کنند. “ “در نهایت، توانایی مدل در درک زمینه و ارائه خروجیهای دقیق، آن را به ابزاری ایدهآل برای بهبود فرآیندهای تصمیمگیری و افزایش کارایی عملیاتی تبدیل میکند.” ), # میتوان پرسشها و پاسخهای بیشتری اضافه کرد } return responses.get(prompt, “این پاسخ تولید شده برای دستور داده شده است.”) # مقداردهی اولیه مدل def generate_text(prompt): model = FalconModel() response = model.generate(prompt) return response # نمونه استفاده prompt = ‘Explain the benefits of using Falcon AI in enterprise applications.’ print(generate_text(prompt)) |

ملاحظات امنیت و حریم خصوصی

هنگام استقرار Falcon AI، به ویژه در محیطهای حساس، امنیت و حریم خصوصی اهمیت بالایی دارند. Falcon AI امکاناتی برای محافظت از دادهها و رعایت قوانین مانند GDPR و CCPA ارائه میدهد.

ویژگیهای کلیدی امنیت:

- رمزگذاری دادهها (Data Encryption): برای حفاظت از دادهها در حین پردازش و ذخیرهسازی، Falcon AI رمزگذاری end-to-end ارائه میدهد.

- کنترل دسترسی (Access Controls): دسترسی به مدل و خروجیهای آن تنها برای افراد مجاز امکانپذیر است.

- بازرسیهای مداوم (Frequent Audits): نظارت و بازرسی مداوم به شناسایی و رفع نقاط ضعف احتمالی در استقرار Falcon AI کمک میکند.

نحوه استقرار و استفاده از Falcon AI

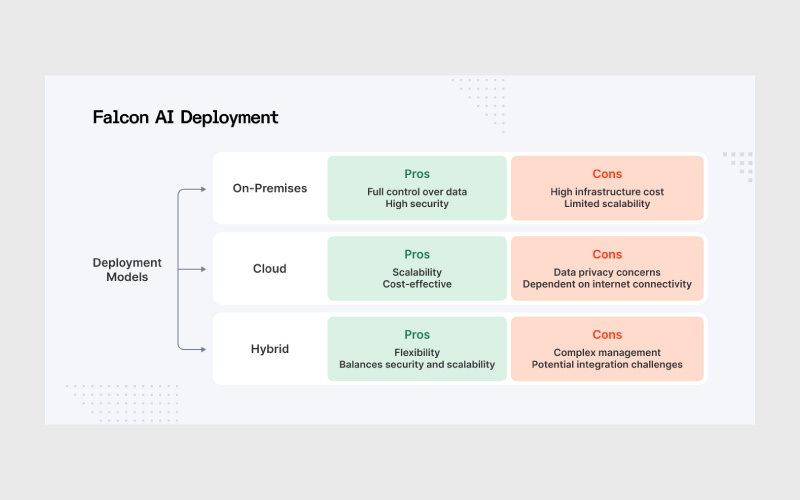

Falcon AI به دلیل متنباز بودن و سازگاری با ابزارهای متداول، انعطافپذیری زیادی در استقرار و استفاده دارد. برخی نکات کلیدی عبارتاند از:

روشهای دسترسی و استقرار

این بخش شامل راههایی است که کاربران و سازمانها میتوانند Falcon AI را دریافت و اجرا کنند، چه از طریق APIهای آماده، دانلود مستقیم مدل یا استقرار در محیطهای ابری و محلی.

- دسترسی به مدل از طریق Hugging Face و دانلود وزنهای مدل یا استفاده از APIهای آماده.

- امکان استقرار مدل در محیطهای ابری (Cloud) برای مقیاسپذیری بالا و پردازش حجم بزرگ دادهها.

- قابلیت اجرای مدل روی سرورهای محلی (On-Premise) برای پروژههای حساس به امنیت یا با محدودیت اتصال به اینترنت.

نیازمندیهای سختافزاری و GPU

اجرای Falcon AI بسته به نسخهی مدل نیازمند منابع سختافزاری متفاوتی است. در این بخش به حداقل و حداکثر نیاز GPU، حافظه و پردازش اشاره میکنیم تا کاربران بتوانند بهترین پیکربندی را برای پروژه خود انتخاب کنند.

- نسخههای کوچکتر مانند Falcon 7B برای اجرا روی GPUهای تک کارت با حافظه متوسط مناسب هستند.

- نسخههای بزرگتر مانند Falcon 40B و 180B نیازمند چند GPU با حافظه بالا یا سیستمهای ابری با قابلیت توزیع پردازش هستند.

- بهینهسازیهایی مثل multiquery attention و روشهای کاهش مصرف حافظه، اجرای مدل را حتی روی سختافزار محدود امکانپذیر میکنند، اگرچه با محدودیت در سرعت inference همراه است.

ابزارهای کمکی و اکوسیستم نرمافزاری

برای استفاده موثر از Falcon، ابزارها و کتابخانههای مکملی وجود دارند که فرایند بارگذاری، fine-tuning، استقرار و توسعه برنامهها را ساده میکنند. این بخش آن ابزارها و چارچوبها را معرفی میکند.

- Transformers Library (Hugging Face) برای بارگذاری مدل و اجرای inference.

- Inference Server برای استقرار مدل در سرویسهای وب و APIهای داخلی.

- پشتیبانی از PyTorch و ابزارهای مرتبط برای fine-tuning، تست و توسعه مدلهای سفارشی.

- ادغام آسان با pipelineهای موجود در سازمانها یا پروژههای تحقیقاتی.

- این ساختار به توسعهدهندگان و سازمانها اجازه میدهد تا بسته به نیاز خود، Falcon AI را بهینه، امن و مقیاسپذیر اجرا کنند و از قابلیتهای متنباز آن حداکثر بهره را ببرند.

چالشها و محدودیتها

هرچند Falcon AI یک مدل قدرتمند و متنباز است اما محدودیتهایی دارد که باید در نظر گرفته شوند. نسخههای بزرگتر مانند Falcon 40B و 180B نیازمند GPUهای متعدد و حافظه بالا هستند و اجرای مستقل آنها در محیطهای کوچک یا با بودجه محدود میتواند دشوار باشد.

همچنین، برای دستیابی به عملکرد بهینه در پروژههای خاص، نیاز به fine-tuning و تنظیم دقیق هایپرپارامترها وجود دارد که برای کاربران تازهکار ممکن است چالشبرانگیز باشد. علاوهبر این، همانند دیگر مدلهای LLM، Falcon ممکن است در برخی زبانها یا حوزههای تخصصی پاسخهای نادرست یا دارای سوگیری ارائه دهد، بنابراین نظارت انسانی و پالایش دادهها همواره ضروری است.

آینده Falcon و جایگاه آن در اکوسیستم LLMها

مسیر توسعه Falcon شامل چند جهت کلیدی است. نخست، نسخههای سبکتر و چندوجهی با قابلیت ادغام آسان در اپلیکیشنها و ابزارهای مختلف در دست برنامهریزی است. دوم، حضور Falcon نشان داد که توسعه مدلهای قدرتمند LLM محدود به غرب نیست و کشورها و موسسات دیگر نیز میتوانند سهم مهمی در اکوسیستم جهانی داشته باشند. در نهایت، موسسه TII بر همکاری باز و متنباز با دیگر پژوهشگران و موسسات بینالمللی تاکید دارد تا رشد و بهبود مدلها به شکل گستردهتری ادامه یابد.

جمعبندی

Falcon AI با متنباز بودن، نسخههای متنوع، عملکرد قوی و انعطافپذیری در استقرار، توانسته جایگاه ویژهای در میان مدلهای زبانی بزرگ پیدا کند. اهمیت مدلهای متنباز در آینده هوش مصنوعی، ایجاد رقابت سالم، نوآوری سریعتر و دسترسی گستردهتر به فناوریهای پیشرفته، به وضوح در مسیر Falcon قابل مشاهده است. این مدل نمونهای موفق از توانایی موسسات غیرغربی در ارائه فناوریهای پیشرفته و رقابت با غولهای حوزه هوش مصنوعی است.

منابع

analyticsvidhya.com | index.dev | beam.ai

سوالات متداول

Falcon AI یک مدل زبانی بزرگ متنباز است که توسط موسسه TII توسعه یافته و بهعنوان رقیبی برای مدلهای تجاری مانند GPT شناخته میشود. تفاوت اصلی آن در متنباز بودن، انعطافپذیری برای پژوهش و توسعه، و بهینهسازی مصرف منابع است که اجرای مدل را در پروژههای متنوع آسانتر میکند.

این مدل در نسخههای 7B، 40B و 180B ارائه شده است. نسخههای سبکتر برای پژوهش و پروژههای کوچک مناسب هستند و نسخههای بزرگتر برای کاربردهای سازمانی، تحلیل دادههای پیچیده، چتباتها و تولید محتوای متنی مورد استفاده قرار میگیرند.

بله، Falcon بهصورت کامل متنباز است و پژوهشگران و توسعهدهندگان میتوانند مدل را روی دادههای خود fine-tune کرده و برای نیازهای خاص سازمانی یا صنعتی خود سفارشیسازی کنند.

نیازمندیها بسته به نسخه مدل متفاوت است. نسخههای کوچکتر میتوانند روی یک GPU با حافظه متوسط اجرا شوند، اما نسخههای بزرگتر مانند 40B و 180B نیازمند چند GPU با حافظه بالا هستند. با این حال، تکنیکهایی مانند multiquery attention به کاهش مصرف منابع کمک میکنند.

دیدگاهتان را بنویسید