در چند سال اخیر اجرای مدلهای هوش مصنوعی روی اپلیکیشنها به یک نیاز عمومی تبدیل شده؛ اما ادغام مدلها در پروژههای واقعی هنوز برای بسیاری از توسعهدهندهها چالشبرانگیز است. از مدیریت زیرساخت گرفته تا نسخهبندی مدلها و نگهداری endpointها، هر مرحله میتواند زمان و انرژی زیادی بگیرد—بهخصوص اگر بخواهید در مقیاس کار کنید. Hugging Face Inference SDK این روند را ساده میکند.

مجموعهای از ابزارهای رسمی برای Python و JavaScript که به شما اجازه میدهد مدلهای متنی، تصویری، صوتی و چندوجهی را تنها با چند خط کد اجرا کنید—بدون نیاز به مدیریت سرور یا تنظیم پیچیده API. در این مقاله یاد میگیرید چطور SDK را نصب کنید، با API جدید آن کار کنید، قابلیتها و محدودیتهایش را بشناسید و نمونهکدهای عملی را در پروژههای واقعی ببینید.

Hugging Face Inference SDK چیست و چه مسئلهای را حل میکند؟

Hugging Face Inference SDK مجموعهای از ابزارهای رسمی برای Python و JavaScript است که امکان اجرای مدلهای هوش مصنوعی را به سادهترین شکل فراهم میکند. این SDK بهجای اینکه شما را درگیر مدیریت سرور، تنظیم زیرساخت یا ساخت endpointهای جداگانه کند، یک لایهی آماده و بهینه روی APIهای Hugging Face قرار میدهد تا بتوانید مستقیما مدلهای متن، تصویر، صوت، ترجمه، طبقهبندی و مدلهای چندرسانهای را تنها با چند خط کد اجرا کنید.

برای توسعهدهندهها، این یعنی حذف دردسرهای معمول مثل تنظیم inference pipeline، هماهنگسازی نسخهی مدلها، نگهداری GPU، مدیریت latency یا ساخت معماری پردازش. کافی است مدل را انتخاب کنید، کلید API را وارد کنید و خروجی را بلافاصله دریافت کنید. Inference SDK همچنین بهطور کامل با سرویسهای رسمی مانند Hugging Face Inference Endpoints، Text Generation Inference (TGI) و Serverless Inference سازگار است و تجربهای یکپارچه برای استقرار و استفاده از مدل ارائه میدهد.

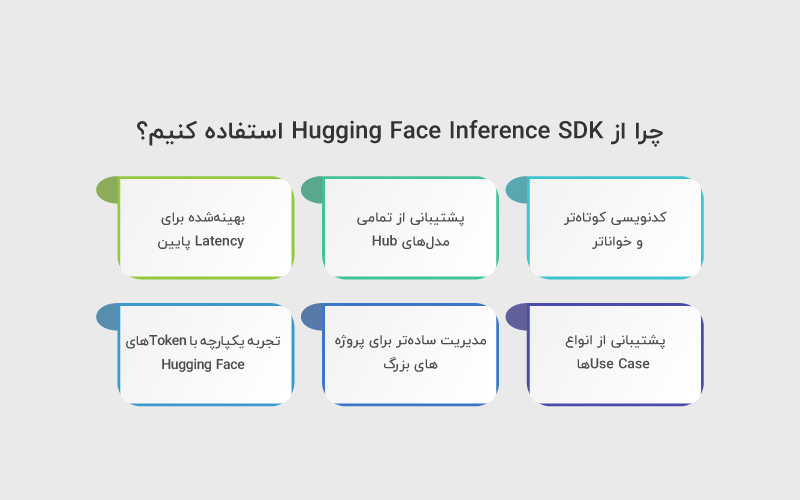

چرا از Hugging Face Inference SDK استفاده کنیم؟

استفاده از REST APIهای Hugging Face برای فراخوانی مدلها همیشه امکانپذیر است، اما Inference SDK تجربهای سادهتر، سریعتر و توسعهدهندهپسندتر ارائه میدهد. مهمترین مزایای استفاده از Inference SDK عبارتاند از:

۱) کدنویسی کوتاهتر و خواناتر

درحالیکه در REST API باید درخواست HTTP، هدرها و بدنه درخواست را مدیریت کنید، Inference SDK تنها با یک تابع و یک ورودی کار را انجام میدهد.

این موضوع باعث میشود توسعه، تست و نگهداری کد بسیار سریعتر شود.

۲) پشتیبانی از تمامی مدلهای Hub

SDK مستقیما با Model Hub یکپارچه است. هر مدلی که در Hub وجود داشته باشد—چه متن، چه تصویر، چه صوت—میتواند با همان API فراخوانی شود.

نیازی به مدیریت فرمت داده یا ساخت endpoint جداگانه نیست.

۳) بهینهشده برای Latency پایین

چه از Serverless Inference استفاده کنید، چه از Inference Endpoints یا TGI،

SDK بهترین مسیر را برای اجرای درخواست انتخاب میکند و سربار اضافه ندارد.

در نتیجه سرعت پاسخگویی بهتر از فراخوانی خام REST خواهد بود.

۴) پشتیبانی از انواع Use Caseها

- تولید متن

- خلاصهسازی

- ترجمه

- طبقهبندی متن و تصویر

- تشخیص اشیا

- تبدیل صوت به متن

- مدلهای چندمرحلهای

تمام اینها بدون نیاز به تنظیمات اضافه.

۵) مدیریت سادهتر برای پروژههای بزرگ

در پروژههایی که شامل چندین سرویس یا میکروسرویس هستند، SDK کمک میکند:

- لاگبرداری،

- مدیریت خطا،

- شناسایی مدل،

- تغییر سریع مدلها،

همه بهصورت استاندارد و متمرکز انجام شود.

۶) تجربه یکپارچه با Tokenهای Hugging Face

در SDK نیازی نیست هر بار توکن را در هدرها قرار دهید. یکبار تعریف میکنید و تمام درخواستها بهصورت امن از آن استفاده میکنند.

Inference SDK چگونه کار میکند؟

Hugging Face Inference SDK در ظاهر بسیار ساده است، اما در پشتصحنه یک معماری انعطافپذیر دارد که باعث میشود توسعهدهنده بدون درگیری با زیرساخت، مدل را بهصورت مستقیم مصرف کند. پایه کار بر همین اصل است: شما فقط درخواست میدهید، SDK بقیه مسیر را مدیریت میکند.

معماری کلی در سه مرحله ساده

وقتی کدی با Inference SDK اجرا میکنید، پشتصحنه اتفاقات زیر رخ میدهد:

۱) انتخاب Provider مناسب

SDK ابتدا تصمیم میگیرد که درخواست باید از طریق کدام Provider اجرا شود.

امکان استفاده از این Providerها وجود دارد:

- Hugging Face Serverless Inference ← سرعت بالا، بدون نیاز به مدیریت سرور

- Inference Endpoints ← مدل مخصوص شما روی سختافزار اختصاصی

- Transformers.js یا Transformers پایتون ← اگر مدل را محلی اجرا کنید

- TGI / Text Generation Inference ← مناسب مدلهای بزرگ مثل Llama یا Mixtral

این انتخاب به چند عامل بستگی دارد:

- نوع مدل

- حجم ورودی

- نوع وظیفه (Task)

- اینکه کلاینت Node.js باشد، Python باشد یا درخواست سمت مرورگر ایجاد شود

۲) آمادهسازی ورودی و فرمتدهی استاندارد

SDK ورودی شما را (متن، تصویر، فایل صوتی و …) به فرمتی تبدیل میکند که Provider انتخابشده بتواند آن را پردازش کند.

بنابراین شما نیازی به هیچکدام از کارهای زیر ندارید:

- ساخت payload

- تنظیم هدرها

- انتخاب Content-Type

- مدیریت Token در هر درخواست

- تعیین Task به صورت دستی

تمام این مراحل بهطور خودکار انجام میشود.

۳) اجرای inference و بازگرداندن خروجی استاندارد

در پایان، Provider مدل را اجرا میکند و SDK نتیجه را در قالبی یکپارچه برمیگرداند. حتی اگر Provider عوض شود (مثلا از Serverless به Endpoint اختصاصی)، ساختار خروجی ثابت میماند و نیازی به تغییر کد شما نیست.

نقش Providerها در سرعت و مقیاسپذیری

🔹 Serverless Inference

- برای پروژههای کوچک و متوسط

- بدون نیاز به تنظیم سرور

- هزینه بهازای مصرف

- Latency بسیار پایین

🔹 Inference Endpoints

- مخصوص سازمانهایی که نیاز به پایداری بالا دارند

- اجرای مدل روی GPU اختصاصی

- امکان تنظیم Autoscaling

- مناسب مدلهای سنگین مثل LLMها

🔹 اجرای محلی (Local Inference)

- بدون هزینه

- مناسب توسعه و تست

- اجرای سریع برای مدلهای سبک

🔹 استفاده از TGI

- برای کارهای سنگینتر مثل:

- Chat

- Text Generation

- مدلهای ۱۰ میلیارد پارامتر به بالا

- Latency بسیار پایین و سازگار با رانتایمهای تولیدی (Production)

نصب و راهاندازی Inference SDK

یکی از بهترین ویژگیهای Hugging Face Inference SDK سادگی نصب و راهاندازی آن است. در این بخش با چند خط کد، SDK را روی محیط خود آماده و آماده استفاده میکنیم.

نصب SDK در Python

برای نصب آخرین نسخه SDK کافی است:

|

1 |

pip install huggingface–hub |

توجه: SDK پایتون بخشی از huggingface_hub است و شامل کلاس InferenceClient میشود.

مثال ساده Python

|

1 2 3 4 5 6 7 8 |

from huggingface_hub import InferenceClient # مقداردهی توکن Hugging Face client = InferenceClient(token=“YOUR_HUGGINGFACE_TOKEN”) # استفاده از یک مدل متنی output = client.text_generation(model=“gpt2”, inputs=“سلام! امروز چه کار کنیم؟”) print(output) |

✅ با همین چند خط میتوانید مدلهای متن، تصویر، صوت و embedding را اجرا کنید.

نصب SDK در JavaScript

برای نصب در پروژه Node.js:

|

1 |

npm install @huggingface/inference |

مثال ساده JavaScript

|

1 2 3 4 5 6 7 8 9 10 |

import { InferenceClient } from “@huggingface/inference”; const client = new InferenceClient({ apiKey: “YOUR_HUGGINGFACE_TOKEN” }); const output = await client.textGeneration({ model: “gpt2”, inputs: “سلام! امروز چه کار کنیم؟” }); console.log(output); |

✅ تمام عملیات مشابه پایتون است و خروجی یکپارچه و استاندارد دریافت میکنید.

برای شروع سریع و اجرای مدلها با Inference SDK، فرایند نصب واقعا همینقدر ساده است، مخصوصا اگر هدف شما تست یا توسعه محلی باشد.

اما چند نکته عملی وجود دارد که توسعهدهندهها معمولا با آن روبهرو میشوند:

۱) توکن و احراز هویت

شما نیاز دارید یک Hugging Face API Token داشته باشید.

بدون توکن نمیتوانید به مدلها دسترسی پیدا کنید یا از Providerهای رسمی استفاده کنید.

توکن را باید در محیط امن (environment variable) یا مدیریت config قرار دهید، نه مستقیم در کد کلاینت سمت مرورگر.

۲) انتخاب محیط اجرای SDK

SDK پایتون و JS روی اکثر محیطها کار میکند، اما برخی مدلهای سنگین نیاز به اتصال سریع به اینترنت و Providerهای GPU دارند.

اگر بخواهید مدلهای بزرگ مثل Llama-2 یا Mixtral را اجرا کنید، باید از Inference Endpoints یا TGI استفاده کنید، که نیاز به زیرساخت یا حساب کاربری مناسب دارد.

۳) نصب پیشنیازها

برای بیشتر مدلها، فقط huggingface-hub در پایتون یا @huggingface/inference در JS کافی است.

اما اگر میخواهید فایلهای صوتی، تصویر یا ویدئو پردازش کنید، ممکن است نیاز به کتابخانههای جانبی مثل torch, Pillow, torchaudio یا ffmpeg باشد.

۴) مدیریت نسخهها

همیشه آخرین نسخه SDK و dependencyها را نصب کنید، تا با آخرین Providerها و مدلهای Hub سازگار باشد.

گاهی نسخه قدیمی باعث میشود Providerهای جدید یا APIهای نوین کار نکنند.

نحوه انتخاب Provider و مدیریت سرعت، هزینه و در دسترس بودن

یکی از مهمترین نکات هنگام استفاده از Hugging Face Inference SDK، انتخاب درست Provider است. انتخاب صحیح میتواند روی سرعت پاسخدهی، هزینه و پایداری سیستم تاثیر مستقیم بگذارد.

۱) انواع Providerها

Hugging Face چند نوع Provider برای اجرای مدلها ارائه میدهد:

| Provider | مناسب برای | ویژگیها |

| Serverless Inference | پروژههای کوچک تا متوسط | بدون نیاز به سرور، هزینه بر اساس مصرف، Latency پایین |

| Inference Endpoints | سازمانها و پروژههای بزرگ | اجرای مدل روی GPU اختصاصی، امکان Autoscaling، مناسب مدلهای سنگین |

| Local Execution (Python/JS) | توسعه و تست | بدون هزینه، سریع برای مدلهای سبک، نیاز به منابع محلی |

| Text Generation Inference (TGI) | مدلهای بزرگ و پیچیده | Latency پایین، مناسب LLMهای سنگین، آماده استفاده برای Production |

۲) فاکتورهای مهم در انتخاب Provider

- نوع مدل: مدلهای بزرگ مثل Llama یا Mixtral بهتر است روی Endpoint اختصاصی یا TGI اجرا شوند.

- حجم ورودی و تعداد درخواستها: برای حجم پایین و تست سریع Serverless مناسب است.

- هزینه و مصرف: Serverless و Local ارزانتر هستند، Endpoints و TGI هزینه بیشتری دارند.

- پایداری و دسترسی: برای پروژههای سازمانی Endpoints مطمئنتر است.

- محیط اجرای SDK: انتخاب Python، Node.js یا سمت مرورگر روی انتخاب Provider تاثیر میگذارد.

۳) نحوه تعیین Provider در کد

Python

|

1 2 3 4 5 6 7 8 |

from huggingface_hub import InferenceClient client = InferenceClient( token=“YOUR_HUGGINGFACE_TOKEN”, provider=“inference-endpoint” # یا “serverless” یا “tgi” ) output = client.text_generation(model=“gpt2”, inputs=“سلام! امروز چه کار کنیم؟”) print(output) |

JavaScript

|

1 2 3 4 5 6 7 8 9 10 11 12 13 |

import { InferenceClient } from “@huggingface/inference”; const client = new InferenceClient({ apiKey: “YOUR_HUGGINGFACE_TOKEN”, provider: “tgi” // یا “serverless” یا “inference-endpoint” }); const output = await client.textGeneration({ model: “gpt2”, inputs: “سلام! امروز چه کار کنیم؟” }); console.log(output); |

۴) نکات عملی برای مدیریت سرعت و هزینه

- برای تست و توسعه سریع ← از Serverless یا Local استفاده کنید.

- برای مدلهای سنگین یا پروژههای سازمانی ← Inference Endpoints یا TGI مناسب است.

- همیشه provider را متناسب با تعداد درخواست و حجم دادهها انتخاب کنید تا هزینه غیرضروری کاهش یابد.

- SDK به شما اجازه میدهد که بین providerها جابهجا شوید بدون تغییرات ساختاری در کد.

مثالهای عملی دنیای واقعی با Inference SDK

در این بخش، چند سناریوی عملی و واقعی نشان میدهیم که توسعهدهندهها میتوانند از Hugging Face Inference SDK استفاده کنند. همه مثالها هم برای Python و JavaScript قابل اجرا هستند.

۱. ساخت یک چتبات ساده با Text Generation

Python

|

1 2 3 4 5 6 7 8 9 10 |

from huggingface_hub import InferenceClient client = InferenceClient(token=“YOUR_HUGGINGFACE_TOKEN”) while True: user_input = input(“شما: “) if user_input.lower() == “خروج”: break response = client.text_generation(model=“gpt2”, inputs=user_input) print(“چتبات:”, response) |

JavaScript

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 |

import { InferenceClient } from “@huggingface/inference”; const client = new InferenceClient({ apiKey: “YOUR_HUGGINGFACE_TOKEN” }); const readline = require(“readline”).createInterface({ input: process.stdin, output: process.stdout }); const chat = async () => { readline.question(“شما: “, async (input) => { if(input.toLowerCase() === “خروج”) return readline.close(); const response = await client.textGeneration({ model: “gpt2”, inputs: input }); console.log(“چتبات:”, response); chat(); }); }; chat(); |

✅ با همین کد ساده میتوانید یک چتبات متنی بسازید و مدلها را بدون مدیریت سرور اجرا کنید.

۲. تولید Embedding برای جستجوی هوشمند (RAG)

Python

|

1 2 |

embedding = client.embeddings(model=“sentence-transformers/all-MiniLM-L6-v2”, inputs=“متن نمونه”) print(embedding) |

JavaScript

|

1 2 3 4 5 |

const embedding = await client.embeddings({ model: “sentence-transformers/all-MiniLM-L6-v2”, inputs: “متن نمونه” }); console.log(embedding); |

✅ این Embeddingها میتوانند برای جستجوی هوشمند، بازیابی اطلاعات و RAG استفاده شوند.

۳. پردازش تصویر (Image Classification)

Python

|

1 2 3 4 |

from PIL import Image image = Image.open(“cat.jpg”) result = client.image_classification(model=“google/vit-base-patch16-224”, inputs=image) print(result) |

JavaScript

|

1 2 3 4 5 6 7 |

import fs from “fs”; const image = fs.readFileSync(“cat.jpg”); const result = await client.imageClassification({ model: “google/vit-base-patch16-224”, inputs: image }); console.log(result); |

✅ اجرای سریع مدلهای تصویر بدون نیاز به تنظیمات پیچیده و زیرساخت GPU.

نکات کاربردی و رفع مشکلات رایج در استفاده از Inference SDK

هنگام کار با Hugging Face Inference SDK، رعایت برخی نکات و آشنایی با مشکلات رایج باعث میشود تجربه توسعهدهنده روانتر و بدون خطا باشد. این بخش شامل بهترین روشها، پیشگیری از خطا و راهحل مشکلات متداول است.

۱. مدیریت توکن API

توکن Hugging Face را هرگز مستقیم در کد سمت مرورگر قرار ندهید.

از environment variable یا فایل تنظیمات امن استفاده کنید.

۲. انتخاب مدل متناسب با پروژه

برای تست و نمونهسازی ← مدلهای سبک مثل GPT2 یا MiniLM.

برای پروژههای واقعی و تولید ← مدلهای سنگینتر مثل Llama-2 یا Mixtral با TGI یا Endpoints.

۳. یکپارچگی خروجی بین Python و JavaScript

خروجیها در SDK استاندارد هستند اما بهتر است برای پردازش بیشتر، قالب خروجی را بررسی کنید.

۴. پیشپردازش و پسپردازش دادهها

متنها را trim یا clean کنید.

تصاویر و صوت را در فرمت استاندارد قرار دهید تا مدل بهتر پاسخ دهد.

۵. استفاده بهینه از Providerها

برای تعداد درخواست کم ← Serverless.

برای مدلهای سنگین و تعداد درخواست زیاد ← TGI یا Endpoints.

مشکلات رایج و راهحلها (Troubleshooting)

| مشکل | دلیل رایج | راهحل |

| خطای احراز هویت (401) | توکن نادرست یا منقضی | توکن را بررسی و از توکن معتبر استفاده کنید |

| خطای Timeout یا Latency بالا | انتخاب Provider نامناسب یا مدل سنگین | از TGI یا Inference Endpoints استفاده کنید، یا حجم ورودی را کاهش دهید |

| خطای بارگذاری مدل | مدل در Hub حذف شده یا نام نادرست | نام مدل را دوباره بررسی کنید و مطمئن شوید در Hub موجود است |

| خطای نوع داده (TypeError) | ورودی با فرمت اشتباه | متن، تصویر یا صوت را مطابق داکیومنت SDK آماده کنید |

| خطای نسخه SDK | استفاده از نسخه قدیمی SDK | SDK و وابستگیها را به آخرین نسخه بهروزرسانی کنید |

نتیجهگیری

Hugging Face Inference SDK یک ابزار قدرتمند و ساده برای توسعهدهندههاست که امکان اجرای مدلهای هوش مصنوعی را بدون دردسر مدیریت سرور یا تنظیمات پیچیده فراهم میکند. با این SDK میتوانید مدلهای متن، تصویر، صوت و حتی مدلهای چندرسانهای را تنها با چند خط کد در Python و JavaScript اجرا کنید.

با استفاده از Providerهای متنوع مانند Serverless Inference، Inference Endpoints و TGI، توسعهدهندهها میتوانند تجربهای بهینه از لحاظ سرعت، هزینه و پایداری داشته باشند. همچنین با رعایت Best Practices و آشنایی با مشکلات رایج، پروژههای AI بدون خطا و با کیفیت بالا اجرا خواهند شد.

در مجموع، Hugging Face Inference SDK فرایند ادغام مدلهای AI در پروژههای واقعی را بسیار ساده و قابل اعتماد میکند و برای هر توسعهدهندهای که میخواهد به سرعت از مدلهای Hub استفاده کند، یک گزینه ایدئال است.

منابع

npmjs.com | huggingface.co | pypi.org

سوالات متداول

تقریبا تمام مدلهای موجود در Hugging Face Hub، شامل مدلهای متن، تصویر، صوت، ترجمه، طبقهبندی و چندرسانهای.

Serverless: مناسب تست و پروژههای کوچک، هزینه بر اساس مصرف، Latency پایین.

Endpoints: مناسب پروژههای بزرگ و سازمانی، اجرا روی GPU اختصاصی، Autoscaling.

TGI: مدلهای بزرگ و پیچیده با Latency پایین، مناسب Production.

خیر، SDK نسخه JavaScript هم دارد و با Node.js یا مرورگر قابل استفاده است.

خیر، SDK میتواند از Serverless Inference استفاده کند که بدون نیاز به سرور است.

دیدگاهتان را بنویسید