در سالهای اخیر، رقابت میان شرکتهای بزرگ فناوری برای توسعه مدلهای زبانی (LLM) به نقطهای رسیده که مرز میان پژوهش و کاربرد روزبهروز باریکتر میشود. در این میان، شرکت Meta با عرضه مجموعه مدلهای Llama مسیر متفاوتی را در پیش گرفته است: تمرکز بر متنباز بودن، بهینهسازی منابع محاسباتی و دسترسی گسترده برای پژوهشگران و توسعهدهندگان. هدف Llama تنها رقابت با مدلهایی چون GPT یا Gemini نیست؛ بلکه ایجاد بستری آزادتر برای پیشرفت جمعی در حوزه هوش مصنوعی مولد است.

در این مقاله، با تکیه بر مستند رسمی Llama و مقاله پژوهشی منتشرشده در arXiv، ابتدا به معرفی فلسفه و معماری مدلهای Llama میپردازیم، سپس نسخههای مختلف آن (از Llama 1 تا Llama 3) را بررسی میکنیم و در ادامه به سراغ کاربردها، روش استقرار محلی و تفاوت آن با مدلهای تجاری مانند GPT خواهیم رفت. در پایان نیز نگاهی خواهیم داشت به آینده مدلهای متنباز در مسیر توسعه هوش مصنوعی و نقش Llama در این تحول.

Llama چیست و چرا با سایر LLMها متفاوت است؟

Llama (Large Language Model Meta AI) خانوادهای از مدلهای زبانی بزرگ است که توسط شرکت Meta AI توسعه یافتهاند. هدف از طراحی Llama ایجاد مدلی قدرتمند، سبکتر و قابلدسترس برای پژوهشگران و توسعهدهندگان مستقل بوده است. درحالیکه بسیاری از مدلهای زبانی تجاری مانند GPT یا Claude بهصورت بسته و مبتنی بر API ارائه میشوند، Llama از ابتدا با رویکرد متنباز (Open Source) عرضه شد تا جامعهی علمی بتواند بهصورت مستقیم به وزنها، ساختار مدل و دادههای آموزشی آن دسترسی داشته باشد.

نکته مهم این است که Llama تنها یک مدل نیست، بلکه یک اکوسیستم از مدلها و ابزارهای مرتبط است که در کنار هم به کار گرفته میشوند. در حال حاضر، Llama در چهار اندازه اصلی ارائه میشود؛ از مدلهای سبک مخصوص دستگاههای لبه (Edge Devices) تا نسخههای بزرگ مخصوص استقرار در سرورهای ابری. این تنوع باعث شده Llama برای طیف وسیعی از پروژهها، از پژوهشهای دانشگاهی گرفته تا کاربردهای تجاری، گزینهای مناسب باشد.

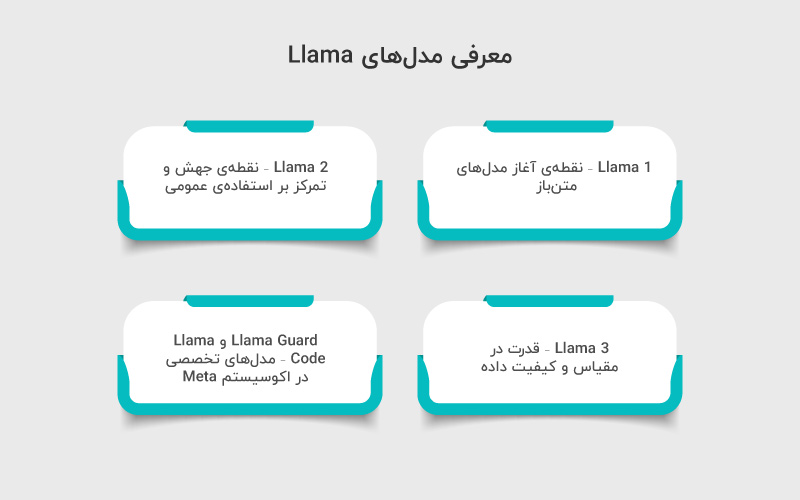

معرفی مدلهای Llama

از زمان انتشار اولیه تا امروز، خانوادهی Llama در چند نسل مختلف توسعه یافته که هرکدام بهبودهایی در دقت، کارایی و مقیاسپذیری ارائه دادهاند. در این بخش به معرفی مهمترین نسخهها میپردازیم:

Llama 1 – نقطهی آغاز مدلهای متنباز

نسخه اول در فوریه ۲۰۲۳ منتشر شد و با وجود اندازهی کوچکتر (۷ تا ۶۵ میلیارد پارامتر)، در چندین بنچمارک عملکردی مشابه GPT-3 داشت. هدف اصلی Meta در این نسخه، ایجاد مدلی سبک و باز برای پژوهشگران بود.

- تعداد پارامترها: 7B، 13B، 33B، 65B

- ویژگی شاخص: بهینهسازی مصرف منابع و توانایی اجرا روی سختافزارهای محدودتر

- کاربرد: پژوهشهای آکادمیک و پروژههای آزمایشی NLP

Llama 2 – نقطهی جهش و تمرکز بر استفادهی عمومی

در جولای ۲۰۲۳، Meta نسخه دوم را با مدلهای بهینهتر و دادههای آموزشی دو برابر بیشتر منتشر کرد. Llama 2 نهتنها دقت بالاتری در وظایف زبانی داشت، بلکه نسخهی Chat آن نیز برای گفتوگوهای چندمرحلهای بهینه شد.

- تعداد پارامترها: 7B، 13B، 70B

- ویژگی شاخص: نسخهی Chat با دادههای دیالوگی و بازخورد انسانی (RLHF)

- کاربرد: چتباتها، تولید متن، ترجمه و خلاصهسازی

Llama 3 – قدرت در مقیاس و کیفیت داده

نسخه سوم در سال ۲۰۲۴ معرفی شد و به گفته Meta، با بیش از ۱۵ تریلیون توکن داده آموزشی آموزش یافته است. این مدل از معماری بهینهتر، دادههای چندزبانه و توانایی درک زمینههای طولانیتر بهره میبرد.

- تعداد پارامترها: 8B، 70B و نسخههای بزرگتر در حال توسعه

- ویژگی شاخص: پشتیبانی بهتر از زبانهای غیرانگلیسی، درک چندمرحلهای (Reasoning) و حافظهی زمینهای گستردهتر

- کاربرد: تولید محتوای پیشرفته، پاسخدهی تحلیلی، برنامهنویسی و مدلهای هیبریدی AI

Llama Guard و Llama Code – مدلهای تخصصی در اکوسیستم Meta

بهموازات مدلهای اصلی، Meta دو مدل مکمل نیز معرفی کرده است:

- Llama Guard: برای شناسایی و فیلتر محتوای حساس و افزایش ایمنی خروجی مدلها.

- Llama Code: نسخهای آموزشدیده بر روی دادههای کدنویسی (مشابه Code Llama) که برای تکمیل خودکار کد، رفع خطا و مستندسازی استفاده میشود.

معماری و ساختار مدلهای Llama

مدلهای Llama بر پایهی معماری Transformer Decoder-only ساخته شدهاند؛ همان ساختاری که در مدلهایی مانند GPT-3 نیز استفاده میشود. اما تفاوت اصلی Llama در بهینهسازی معماری، شیوهی آموزش و نحوه استفاده از منابع محاسباتی است.

۱. معماری کلی

در هسته Llama، یک شبکه Transformer با سری از بلاکهای attention و feed-forward قرار دارد که متن ورودی را به توکنها شکسته و آنها را در فضای برداری معناشناسی (embedding space) پردازش میکند.

فرایند اصلی شامل مراحل زیر است:

| مرحله | توضیح |

| Tokenization | ورودی متنی به واحدهای کوچکتر (توکنها) تقسیم میشود. Llama از tokenizer خاصی استفاده میکند که مبتنی بر Byte Pair Encoding (BPE) است. |

| Embedding | هر توکن به یک بردار عددی در فضای ویژگیها تبدیل میشود. |

| Attention Layers | مدل ارتباط معنایی بین توکنها را از طریق مکانیزم attention یاد میگیرد. |

| Feed-forward Layers | اطلاعات پردازششده از attention در لایههای غیربازگشتی (MLP) گسترش مییابد تا ویژگیهای زبانی عمیقتر استخراج شود. |

| Output Projection | در نهایت، مدل توزیع احتمالاتی برای توکن بعدی را پیشبینی میکند. |

۲. بهینهسازیهای کلیدی در Llama

Meta برای افزایش کارایی و کاهش نیاز به منابع محاسباتی، چند تغییر مهم در معماری Transformer اعمال کرده است:

| ویژگی | توضیح |

| Rotary Position Embedding (RoPE) | بهجای موقعیتیابی مطلق توکنها، از موقعیتیابی چرخشی استفاده شده تا مدل بهتر بتواند توالیهای طولانی را درک کند. |

| Grouped-Query Attention (GQA) | نسخههای جدید Llama (مثل Llama 3) از GQA بهره میبرند که حافظه مورد نیاز در پردازش Attention را تا ۴۰٪ کاهش میدهد. |

| Pre-normalization LayerNorm | نرمالسازی پیش از هر بلاک باعث پایداری بهتر در آموزش مدلهای بزرگ میشود. |

| Simplified Feed-Forward Network (SwiGLU) | بهجای ReLU، از تابع فعالسازی SwiGLU استفاده شده تا جریان گرادیان در مدل نرمتر و دقیقتر باشد. |

| Context Window گستردهتر | در Llama 3، طول ورودی تا ۸k یا حتی ۱۲۸k توکن قابل پردازش است که در وظایف تحلیلی و متنی بلند بسیار مهم است. |

۳. دادهی آموزشی و روش آموزش

Llama با دادههای بسیار متنوع و با کیفیت آموزش دیده است؛ از وب، کتابها، ویکیپدیا و کد منبع. Meta تاکید دارد که تمرکز این دادهها بر دقت، تنوع زبانی و پاکیزگی دادهها بوده است.

| نسخه | حجم داده (تقریبی) | زبانها | توکنها |

| Llama 1 | 1.4 تریلیون | انگلیسیمحور | 1T |

| Llama 2 | 2 تریلیون | چندزبانه | 2T |

| Llama 3 | 15 تریلیون | چندزبانه گسترده | 15T+ |

همچنین، Llama 2 و 3 برای نسخههای گفتوگومحور خود از RLHF (یادگیری با بازخورد انسانی) استفاده کردهاند تا پاسخها طبیعیتر و ایمنتر باشند.

۴. ساختار باز و فلسفه متنباز

در حالی که بسیاری از مدلهای بزرگ مانند GPT و Gemini بهصورت بسته منتشر میشوند، Meta مدلهای Llama را با مجوز Community License منتشر کرده است. این مجوز به پژوهشگران و شرکتها اجازه میدهد تا:

- مدلها را بهصورت محلی اجرا کنند،

- نسخههای اختصاصی بسازند (مثلا برای کاربردهای فارسی یا صنعتی)،

- و مدلهای خود را در اکوسیستم Llama Hub منتشر کنند.

نحوه استفاده از مدلهای Llama

یکی از دلایل محبوبیت Llama در میان توسعهدهندگان، انعطاف بالا در نحوه استقرار و استفاده از مدلهاست. شما میتوانید Llama را به دو روش اصلی استفاده کنید:

- از طریق رابطهای آماده (API و سرویس ابری)

- یا به صورت محلی (Local Deployment) روی GPU خود یا سرورهای سازمانی

۱. استفاده از Llama API

Meta از طریق Llama API در وبسایت رسمی خود (llama.com) امکان دسترسی مستقیم به مدلهای مختلف را فراهم کرده است.

این API مشابه APIهای OpenAI عمل میکند، با این تفاوت که تمرکز بیشتری بر امنیت داده و قابلیتهای سفارشیسازی دارد.

مثال استفاده از Llama API در پایتون

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 |

import requests API_URL = “https://api.llama.com/v1/completions” headers = {“Authorization”: “Bearer YOUR_API_KEY”} data = { “model”: “llama-3-70b-chat”, “messages”: [ {“role”: “system”, “content”: “You are a helpful assistant.”}, {“role”: “user”, “content”: “Explain how transformers work in simple terms.”} ], “max_tokens”: 200, “temperature”: 0.7 } response = requests.post(API_URL, headers=headers, json=data) print(response.json()) |

🔹 این مثال نشان میدهد که چطور میتوان از مدل Llama برای تولید پاسخ متنی (completion) استفاده کرد.

🔹 پارامترهایی مانند temperature، max_tokens و نقش پیامها (system / user) دقیقا مشابه ساختار GPT هستند.

۲. اجرای مدل Llama بهصورت محلی

اگر میخواهید کنترل کامل بر دادهها و منابع خود داشته باشید، میتوانید مدلهای Llama را بهصورت آفلاین اجرا کنید.

این قابلیت از نسخه Llama 2 به بعد بهطور رسمی پشتیبانی میشود.

مراحل راهاندازی

| مرحله | توضیح |

| ۱. دانلود مدل از Hugging Face | نسخههای Llama (مثل meta-llama/Llama-3-8B) روی Hugging Face در دسترس هستند. |

| ۲. نصب کتابخانهها | از پکیجهایی مثل transformers، accelerate و torch استفاده کنید. |

| ۳. بارگذاری مدل و توکنایزر | با چند خط کد میتوانید مدل را برای پردازش متن آماده کنید. |

مثال کد

|

1 2 3 4 5 6 7 8 9 10 11 |

from transformers import AutoTokenizer, AutoModelForCausalLM model_id = “meta-llama/Llama-3-8B” tokenizer = AutoTokenizer.from_pretrained(model_id) model = AutoModelForCausalLM.from_pretrained(model_id, device_map=“auto”) prompt = “What are the main differences between Llama and GPT?” inputs = tokenizer(prompt, return_tensors=“pt”) outputs = model.generate(**inputs, max_new_tokens=100) print(tokenizer.decode(outputs[0], skip_special_tokens=True |

🔸 این کد مدل را مستقیما از Hugging Face بارگذاری میکند و روی GPU (در صورت وجود) اجرا میشود.

🔸 خروجی، پاسخ متنی مدل به پرسش شماست — بدون نیاز به اتصال اینترنت یا ارسال دادهها به سرور خارجی.

نکات بهینهسازی

- از کتابخانهی bitsandbytes برای اجرای مدل با حافظهی کمتر (۸bit/4bit quantization) استفاده کنید.

- برای پروژههای تیمی، Hugging Face Inference Endpoints گزینهی مناسبی برای میزبانی مدل بهصورت پایدار است.

- اگر از Llama برای زبانهای غیرانگلیسی استفاده میکنید (مثلا فارسی)، بهتر است مدل را با دادههای بومی فاینتیون (fine-tune) کنید.

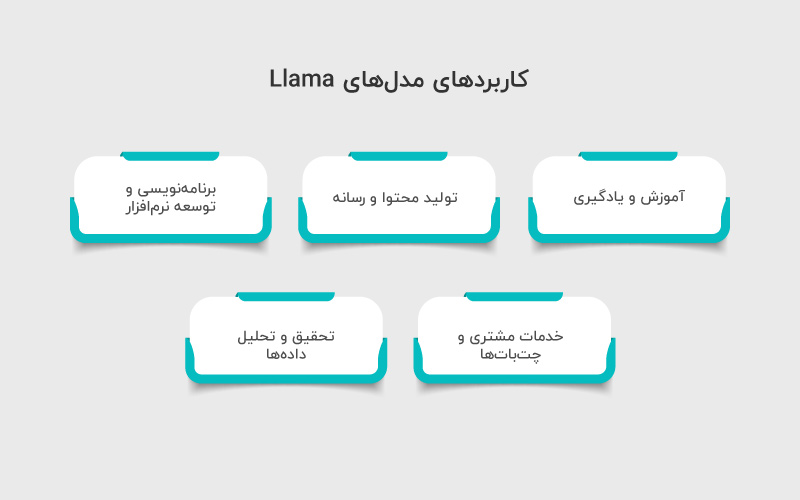

کاربردهای مدلهای Llama

مدلهای Llama به دلیل قابلیت تولید متن طبیعی، انعطافپذیری بالا و امکان استقرار محلی یا ابری، در حوزههای متنوعی کاربرد دارند:

۱. آموزش و یادگیری

- تولید محتوا و خلاصهسازی متون دروس و کتابهای آموزشی

- ساخت دستیارهای هوشمند برای حل تمرین و پاسخ به سوالات دانشآموزان

۲. تولید محتوا و رسانه

- نوشتن مقالات، خبرنامه و کپشنهای شبکههای اجتماعی

- ایجاد داستان و دیالوگ برای بازیها یا پروژههای سرگرمی

۳. برنامهنویسی و توسعه نرمافزار

- تولید کد نمونه یا توضیح خطوط کد برای توسعهدهندگان

- کمک به اتوماسیون مستندسازی API و تحلیل لاگهای برنامه

۴. خدمات مشتری و چتباتها

- پاسخ به سوالات متداول و تعامل هوشمند با مشتریان

- پردازش زبان طبیعی برای تحلیل بازخورد کاربران

۵. تحقیق و تحلیل دادهها

- تحلیل و خلاصهسازی دادههای متنی بزرگ

- استخراج اطلاعات کلیدی از مقالات علمی یا گزارشهای تحقیقاتی

مقایسه مدلهای Llama و مدلهای مشابه

برای درک بهتر جایگاه Llama نسبت به سایر مدلهای زبان بزرگ، مهم است بدانیم هر مدل با چه هدفی طراحی شده و در چه حوزهای عملکرد بهینه دارد.

| مدل | پارامترها | نوع دسترسی | کاربرد اصلی | نکات کلیدی |

| Llama | 7B – 70B | Open-access / Research | پردازش متن، تحقیق و توسعه | بهینه برای متن طولانی، قابل استقرار محلی، چندزبانه |

| GPT (OpenAI) | 175B+ | Proprietary | تولید محتوا، چتبات، تحلیل متن | مدل بزرگ و ابری، API گسترده، توانایی متنمحور قوی |

| BLOOM | 176B | Open-access | تحقیق چندزبانه، تولید متن | مدل چندزبانه با تمرکز تحقیقاتی، دسترسی عمومی |

| Falcon AI | 7B – 40B | Open-source | سازمانی، تولید متن، تحلیل داده | بهینه برای استقرار سریع، کارایی بالا، انعطافپذیر |

آینده مدلهای Llama: توسعه، کاربرد و نوآوری

مدلهای Llama با توجه به ساختار انعطافپذیر و دسترسی باز، پتانسیل بالایی برای توسعههای آینده دارند. انتظار میرود نسخههای بزرگتر و بهینهتر این مدلها، توانایی پردازش متنهای طولانیتر و چندزبانه را افزایش دهند و کاربردهای پیشرفتهتری در زمینه تحقیق، آموزش و تحلیل دادهها فراهم کنند. همچنین، یکپارچهسازی با ابزارهای MLOps و APIهای ابری میتواند استقرار سریعتر و مقیاسپذیری بهتر را برای توسعهدهندگان و سازمانها به ارمغان بیاورد.

جمعبندی

مدلهای Llama با ترکیب قابلیتهای قدرتمند و دسترسی باز، جایگاه ویژهای در میان مدلهای زبان بزرگ پیدا کردهاند. انعطافپذیری، مقیاسپذیری و توانایی عملکرد در پروژههای تحقیقاتی و عملی، این مدلها را به گزینهای جذاب برای توسعهدهندگان و پژوهشگران تبدیل میکند. مقایسه با سایر مدلهای شناختهشده، نشان میدهد که Llama میتواند نیازهای متنوعی را پوشش دهد و در آینده نیز با نسخههای بهبود یافته، کاربردهای گستردهتر و نوآورانهتری ارائه خواهد کرد.

منابع

سوالات متداول

Llama بهصورت open-access ارائه میشود و امکان استقرار محلی و پژوهشی را فراهم میکند، در حالی که GPT بیشتر تحت سرویس ابری و تجاری است و BLOOM تمرکز زیادی بر تحقیق و کاربرد چندزبانه دارد.

نسخههای مختلفی از Llama با اندازههای متفاوت وجود دارد، از مدلهای کوچکتر 7B گرفته تا مدلهای بزرگتر 70B که ظرفیت پردازشی بیشتری دارند.

بله. مدلهای Llama برای پروژههای تحقیقاتی، تحلیل دادهها، تولید متن و توسعه ابزارهای هوش مصنوعی قابل استفاده هستند.

میتوان با استفاده از کتابخانههایی مانند Hugging Face Transformers یا ابزارهای ارائهشده توسط Meta (LLama) مدلها را دانلود، آموزش دوباره و در پروژهها به کار برد.

دیدگاهتان را بنویسید