با رواج بیشتر هوش مصنوعی، گفتگو پیرامون مفاهیم اخلاقی این فناوری شتاب بیشتری گرفته است. گفتگوهای زیادی در مورد کاربرد اخلاق در هوش مصنوعی انجام شدهاند و بسیاری از کارشناسان با هدف ترسیم نقشهای جامع از ملاحظات اخلاقی، به دنبال ایجاد استراتژیهای موثر در چشمانداز هوش مصنوعی هستند. اخلاق هوش مصنوعی مجموعهای از اصول است که به انسان کمک میکند تا از مزایای این فناوری نهایت استفاده را ببرد و در عین حال، اثرات منفی AI را به حداقل برساند. در این مقاله از بلاگ آسا به طور کامل در مورد اخلاق هوش مصنوعی و کاربرد آن صحبت میکنیم.

اخلاق هوش مصنوعی چیست؟

اخلاق هوش مصنوعی (AI Ethics) اصولی است که به استفاده مسئولانه و اخلاقی از هوش مصنوعی اشاره دارد. این اصول بر پایه دقیقترین، بیطرفانهترین و اخلاقیترین روشها بنا شدهاند تا نقشه راه آینده هوش مصنوعی باشند. اخلاق در هوش مصنوعی تضمین میکند که حرکت پرشتاب فناوری باید با ارزشهای اساسی اجتماعی و کرامت انسانی همسو باشد. این موضوع حتی به عنوان وجدان هوش مصنوعی هم شناخته میشود؛ چرا که AI باید رویکردی انسان-محور داشته باشد و بر انصاف، صداقت و همدلی تاکید کند.

ممکن است بپرسید: «ماشینها از دادهها یاد میگیرند، پس چه کسی مسئولیت آموزشهای آنها را بر عهده دارد؟» پاسخ به این سؤال، چشمانداز اخلاقی هوش مصنوعی را شکل میدهد. برای مثال، توسعهدهندگان یک پلتفرم هوش مصنوعی میخواهند مطمئن شوند که پلتفرم آنها در زمان پاسخگویی به کاربران، منصفانه و اخلاقی رفتار میکند و محتوای نامربوط ارائه نمیدهد؛ بنابراین باید با ارائه دادههای منطقی و درست و همچنین ارائه بازخورد به AI، آن را منطبق بر اصول اخلاقی آموزش دهند.

چرا اخلاق هوش مصنوعی مهم است؟

شرکتهای بزرگ مانند مایکروسافت و آیبیام برای اعتمادسازی در بین مشتریان خود به اخلاق AI روی آوردهاند. شرکتهای کوچکتر هم در حال تدوین استانداردهایی در مورد نحوه استفاده مسئولانه از هوش مصنوعی هستند. شرکتها با پیروی از اصول اخلاقی هوش مصنوعی میتوانند محصولاتی ایجاد کنند که زندگی کاربران را بهبود بخشد و در عین حال از مشکلات احتمالی جلوگیری کند. برای مثال، یک چتبات مانند ChatGPT، ایدههای تبعیضآمیز یا تعصبی را بیان نمیکند و سوالات کاربر را به شکلی اخلاقی پاسخ میدهد.

یک هوش مصنوعی میتواند نحوه ساخت بمب را توضیح دهد، اما ارائه این اطلاعات احتمالا به نتایج خوبی منجر نمیشود. اخلاق در هوش مصنوعی از پاسخ به نحوه ساخت بمب اجتناب میکند؛ بنابراین توسعهدهندگان در پلتفرم AI خود دستورالعملهایی را تنظیم میکنند تا با پیروی از آنها بتوانند اخلاقی عمل کنند. یک دستور اخلاقی ممکن است این باشد که هیچ تبعیض نژادی نباید بیان شود. به این ترتیب، یک ربات از گفتن برخی چیزها، ارائه اطلاعات مرتبط یا استفاده از زبان خاصی که تبعیض نژادی را نشان میدهد، اجتناب میکند.

AI Ethics و کسب و کارها

اهمیت اخلاق در هوش مصنوعی به نوع کسب و کار و حساسیت اطلاعات آن هم ارتباط دارد. کسب و کارهای فعال در حوزههایی مانند مراقبتهای بهداشتی موظف هستند تا امنیت دادههای حساس بیماران خود را حفظ کنند و اطلاعات بسیار دقیق و درستی را در اختیارشان قرار دهند. پیروی از اصول اخلاقی هوش مصنوعی برای محافظت از اطلاعات ارزشمند و ارائه داده دقیق علمی به بیماران میتواند باعث شفافیت، اعتبار و ایجاد یک جامعه سالمتر شود. ساچین پاتل، مدیر عامل شرکت Apixio در مصاحبهای در مورد اهمیت اخلاق هوش مصنوعی در حوزه مراقبتهای درمانی میگوید:

«دقت AI در حوزه سلامت و بهداشت بسیار مهمتر از حوزههای دیگر است. شما ممکن است در یک پلتفرم هوش مصنوعی به دنبال بهترین رستوران کنتاکی شهر باشید. آن پلتفرم به شما پیشنهاد خود ارائه میدهد، اگر رفتید و مشاهده کردید که رستوران کیفیت پایینی دارد، فقط پول غذای خود را دور ریختهاید. اما وقتی که در یک پلتفرم هوش مصنوعی به دنبال بهترین میوه برای افراد مبتلا به دیابت باشید، اگر آن پلتفرم به شما میوه اشتباهی را توصیه کند، ممکن است قند خون شما به یکباره بالا رود و زندگیتان به خطر بیفتد. در چنین مواقعی باید هوش مصنوعی اطلاعات دقیقی به بیمار ارائه دهد.»

اصول اخلاقی هوش مصنوعی چیست؟

درک اصول اساسی هوش مصنوعی اخلاقی برای توسعه پلتفرمهای انسان محور ضروری است. در ادامه به پنج اصل اخلاقی اشاره میکنیم که باید مشکلات مربوط به هوش مصنوعی را کاهش دهد و توسعه منصفانه آن را هدایت کند:

۱. سوء استفاده نکردن

سوء استفاده نکردن سنگ بنای اخلاق هوش مصنوعی است. این اصل بر لزوم پرهیز از اقداماتی که میتواند به افراد یا کل جامعه آسیب برساند، تاکید میکند. هنگام توسعه سیستمهای هوش مصنوعی، بهتر است به نکات زیر توجه داشته باشید:

- اجتناب از برنامههای مضر: مهندسان نرمافزار باید مطمئن شوند که فناوریهای هوش مصنوعی برای اهدافی که میتواند منجر به آسیب شود، مانند تسلیحات یا فعالیتهای مخرب سایبری توسعه داده نشده است. این موضوع شامل حفظ استانداردهای اخلاقی در امنیت سایبری برای جلوگیری از سوء استفاده است.

- جلوگیری از تعصب: سیستمهای هوش مصنوعی میتوانند به طور ناخواسته باعث سوگیریهایی در دادههای خود شوند و به طور بالقوه نابرابریهای اجتماعی را تقویت کنند. مهندسان باید از تکنیکهای قوی برای شناسایی، کاهش و حذف سوگیریها در طول چرخه عمر توسعه پلتفرمهای هوش مصنوعی استفاده کنند.

- حفظ حریم خصوصی: با توجه به اتکای هوش مصنوعی به مجموعه دادههای بزرگ، حفظ حریم خصوصی بسیار مهم است. مهندسان AI باید اقدامات سختگیرانه حفاظت از دادهها را اجرا کنند تا از دسترسی غیرمجاز و سوء استفاده از اطلاعات شخصی جلوگیری شود.

۲. پاسخگویی و مسئولیت

تعیین مسئولیتپذیری در سیستمهای هوش مصنوعی یک چالش پیچیده است. از آنجایی که هوش مصنوعی در تصمیمگیری مستقل عمل میکند، تعیین اینکه چه کسی مسئول این تصمیمات است، اهمیت زیادی دارد. نکات مهم در این بخش عبارتند از:

- تعریف مسئولیت: آیا مسئولیت باید بر عهده توسعهدهندگان، تولیدکنندگان یا کاربران نهایی باشد؟ برای تعریف مسئولیت باید دستورالعملهای واضحی ایجاد کرد. یکسری از دستورالعملها مسئولیتهای توسعهدهندگان و برخی دیگر از دستورالعملها میتوانند مسئولیتهای کاربران را در استفاده از پلتفرم AI تعیین کنند.

- تعیین چارچوبهای قانونی: دولتها و سازمانها در تلاش برای ایجاد چارچوبهای قانونی هستند که مسئولیت را در حوادث مرتبط با هوش مصنوعی تعریف میکند. به عنوان مثال، قانون هوش مصنوعی اتحادیه اروپا نشان میدهد که توسعهدهندگان و کاربران در قبال اقدامات خود پاسخگو هستند.

- شفافیت در تصمیمگیری: اطمینان از شفاف بودن فرایندهای تصمیمگیری در پلتفرمهای هوش مصنوعی میتواند به شناسایی و اصلاح خطاها یا سوگیریها کمک کند و در نتیجه مسئولیتپذیری را افزایش دهد.

۳. داشتن شفافیت

شفافیت در هوش مصنوعی به معنای قابلیت درک و تفسیر کردن عملکرد درونی الگوریتمها است. این موضوع برای ایجاد اعتماد و اطمینان از استفاده اخلاقی از هوش مصنوعی حیاتی است. نکات مهم در این بخش عبارتند از:

- هوش مصنوعی قابل توصیف (XAI): توسعه سیستمهای هوش مصنوعی که توضیحات واضح و قابل فهمی را ارائه میکنند، به کاربران کمک خواهند کرد تا به پاسخ خود برسند. این موضوع برای اعتمادسازی، به ویژه در حوزههای پر ریسک مانند مراقبتهای بهداشتی و عدالت کیفری بسیار مهم است.

- الگوریتمها و منبع-باز: اشتراکگذاری کد الگوریتمی و جزئیات طراحی پلتفرم هوش مصنوعی، امکان بررسی و بررسی دقیق را فراهم کرده و به شناسایی و رفع مشکلات یا سوگیریهای احتمالی کمک میکند.

- تعامل با ذینفعان: تعامل با ذینفعان مختلف از جمله اخلاقشناسان، جامعهشناسان، کارشناسان صنعت و … تضمین میکند که توسعه هوش مصنوعی با ارزشها و انتظارات اجتماعی همسو است.

۴. رعایت حقوق بشر

اطمینان از اینکه سیستمهای هوش مصنوعی به حقوق بشر احترام میگذارند و باعث ارتقا آن میشوند، یک اصل مهم در اخلاق AI است. این موضوع شامل استراتژیهای زیر است:

- طراحی مبتنی بر حقوق: گنجاندن اصول حقوق بشر در طراحی و اجرای سیستمهای هوش مصنوعی تضمین میکند که حریم خصوصی، آزادی بیان یا سایر حقوق اساسی نقض نمیشوند.

- ارزیابی تأثیر: انجام منظم ارزیابیهای مربوط به تاثیر حقوق بشر در سیستمهای هوش مصنوعی میتوانند به شناسایی و کاهش خطرات بالقوه برای انسانها موثر باشند. این رویکرد پیشگیرانه از سوء استفادهها جلوگیری میکند.

- ترویج فراگیری: فناوریهای هوش مصنوعی باید برای ارتقای هر چه بهتر حقوق بشر طراحی شوند. این موضوع میتواند به استفاده از هوش مصنوعی برای بهبود دسترسی به آموزش، مراقبتهای بهداشتی و عدالت قانونی منتهی شود.

۵. رعایت انصاف

انصاف در هوش مصنوعی تضمین میکند که سیستمها با همه افراد به طور عادلانه و بدون تبعیض رفتار میکنند. این چالش مهم شاید به دلیل سوگیریهای ذاتی در دادهها و الگوریتمها رخ دهد. رویکردهای کلیدی برای دستیابی به عدالت عبارتند از:

- مجموعه دادههای متنوع: توسعدهندگان باید از مجموعه دادههای متنوع برای آموزش سیستمهای هوش مصنوعی استفاده کنند تا سیستم دچار سوگیری نشود. این موضوع شامل اطمینان از گنجاندن دادههای جمعیتی و پیشینههای اجتماعی-اقتصادی مختلف است.

- تشخیص و کاهش تعصب: پیادهسازی الگوریتمها و ابزارهایی برای شناسایی و کاهش سوگیریها در سیستمهای هوش مصنوعی به جلوگیری از تبعیض به هر شکلی (مذهبی، نژادی و غیره) کمک میکنند.

- نظارت مستمر: ارزیابی منظم سیستمهای هوش مصنوعی از نظر برابری دیدگاه ضروری است. این نظارت مستمر به حفظ انصاف کمک و هرگونه سوگیری یا اعمال تبعیضآمیز را برطرف میکند.

چگونه میتوان اخلاق هوش مصنوعی را اجرا کرد؟

اخلاق هوش مصنوعی مفهومی دوگانه دارد. مفهوم اول به مسئولیتپذیری توسعهدهنده مربوط میشود و مفهوم دوم مسئولیتپذیری ماشین را مشخص میکند. براساس این مفهوم دوگانه میتوان گفت که وقتی انسانها از نظر اخلاقی مسئول باشند، هوش مصنوعی و ماشینها نیز اخلاقی عمل میکنند؛ اما این سوال مطرح میشود که: «چگونه مرز بین اینکه چه کسی مسئولیت اخلاقی را بر عهده دارد، تعریف کنیم؟» برای مثال، اگر یک ماشین خودران تصادف کند، آیا میتوان ماشین را مقصر دانست یا اینکه مقصر اصلی راننده است؟ اگر توسعهدهنده اخلاق را رعایت کند، آیا تضمینی بر این است که هوش مصنوعی هم اخلاق را در نظر بگیرد.

در حقیقت، کشورهایی که تصمیم گرفتهاند از اخلاق AI دفاع کنند، ممکن است در اجرای آن چندان دقیق عمل نکنند. در مواردی که اخلاق هوش مصنوعی بیشتر به عنوان یک قانون نرم (بدون سختگیری زیاد) در نظر گرفته میشود، دلیل اصلی اغلب «ترس از سرکوب نوآوری» است. شرکتهای توسعهدهنده هوش مصنوعی معتقدند که نوآوری در آزادی بیقید و شرط ایجاد میشود و میترسند تا با تدوین اخلاق برای هوش مصنوعی نوآوری متوقف شود. پس آنها اخلاق را آنطور که میخواهند تعریف میکنند و نه آنطور که باید باشد و اینجا تناقض ایجاد میشود. برای اجرای اخلاق AI، ابتدا باید تعریف کنیم که این اخلاق چیست.

چه کسی باید تصمیم بگیرد که اخلاق هوش مصنوعی چیست؟

اخلاق AI مانند اخلاق انسانی موضوعی واحد نیست که همه آن را به یک شکل تعبیر کنند. بسیاری از سازمانها تلاش کردهاند دستورالعملهایی را برای اخلاق AI ایجاد کنند تا تعریف دقیقتری از اخلاق در هوش مصنوعی ارائه دهند. در ادامه به سه مورد از این دستورالعملها اشاره میکنیم:

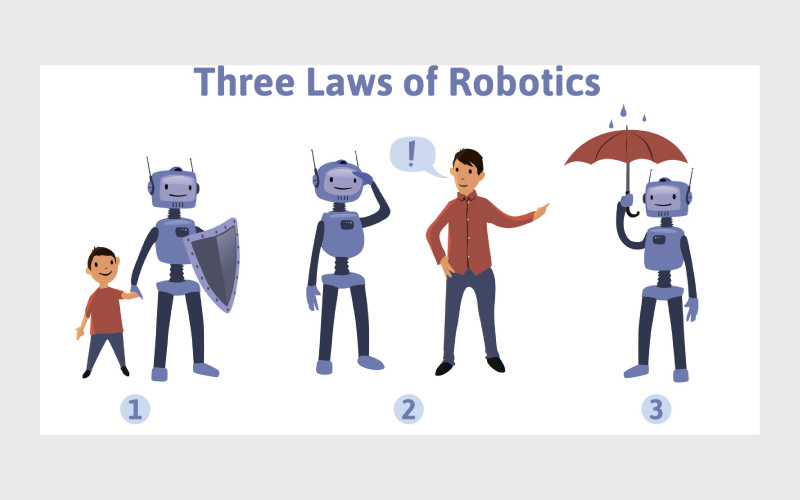

سه قانون رباتیک آسیموف

سه قانون رباتیک یکی از اولین اصول اخلاقی هوش مصنوعی است. در سال ۱۹۴۲ میلادی، آیزاک آسیموف سه قانون زیر را تصویب کرد:

- ربات نمیتواند به انسان صدمه بزند یا با انجام ندادن اقدامی به انسان آسیب برساند.

- یک ربات باید از دستورات داده شده توسط انسان اطاعت کند، مگر در مواردی که چنین دستوراتی با قانون اول در تضاد باشد.

- یک ربات باید از وجود خود محافظت کند تا زمانی که چنین حفاظتی با قوانین اول یا دوم در تضاد باشد.

گزارش بلمونت

در سال ۱۹۷۹ میلادی، کمیسیون ملی حفاظت از افراد در زمینههای زیست پزشکی و رفتاری، دستورالعملهای اخلاقی خود را برای تحقیق منتشر کرد. در حالی که این دستورالعملها در آن زمان متمرکز بر آزمایشگاه بود، اما بعدها وارد حوزه فناوری و هوش مصنوعی نیز شد. این دستورالعملها از سه اصل زیر پیروی میکنند:

- احترام به افراد

- خیرخواهی

- برقراری عدالت

رویکرد چند بعدی IBM

شرکت IBM سه اصل مهم در اخلاق هوش مصنوعی دارد که عبارتند از:

- هدف از هوش مصنوعی، افزایش هوش انسان و سودمندی بشریت است.

- دادههایتان متعلق به شماست و سیاستهای داده باید شفاف باشند.

- فناوری باید قابل توضیح باشد و کاربران باید به آنچه در الگوریتمها و آموزش هوش مصنوعی وجود دارند، دسترسی داشته باشند.

منشور OpenAI

منشور OpenAI مجموعهای از اخلاق AI است که باعث شده است تا توسعهدهندگان در این شرکت بتوانند چت ربات محبوب ChatGPT AI را توسعه دهند. این منشور از چهار اصل پیروی میکند:

- باورهای گسترده

- ایمنی بلند مدت

- رهبری فنی

- جهتگیری مشارکتی

ما میتوانیم در مورد اخلاق هوش مصنوعی به صورت تئوری صحبت کنیم، اما این مفهوم در واقعیت چگونه است؟ در حالی که رهبران تکنولوژی جهان روی مجموعهای از استانداردهای اخلاقی هوش مصنوعی برای گسترش جهانی هنوز به توافق نرسیدهاند، نمونههای موفقی از کشورهای خاص وجود دارند که این استانداردها را تنظیم و اجرا میکنند. این اصول اخلاقی زمانی با موفقیت اجرا میشوند که از طریق سیستمهای قانونی با جریمهها و عواقب همراه باشند.

مقررات عمومی حفاظت از دادهها (GDPR) که در سال ۲۰۱۶ میلادی توسط اتحادیه اروپا تصویب شد، پایه و اساس مدلی را برای نحوه اعمال اخلاقیات پیرامون ابزارهای فناوری ایجاد کرد. مقررات عمومی حفاظت از دادهها به افراد اجازه میدهند تا بر دادههای شخصی خود کنترل داشته باشند. قبل از این، افراد هیچ قدرتی بر فروش دادههایشان، ردیابی فعالیتهایشان با کوکیها یا دانشی درباره الگوریتمها نداشتند.

آیا همه افراد باید اخلاق هوش مصنوعی را رعایت کنند؟

اصول اخلاقی AI به ندرت از نظر قانونی حمایت میشوند. در حقیقت، مجموعه مشخصی از اخلاق هوش مصنوعی وجود ندارد که همه با آن موافق باشند. بنابراین، از بسیاری جهات، شما ملزم به رعایت اخلاق هوش مصنوعی نیستید. از طرفی، هدف یک چتبات مانند FreedomGPT ارائه یک نسخه بدون سانسور از سرویسی مانند ChatGPT است. برای برخی افراد، ChatGPT بسیار محدود کننده است، زیرا هر نوع اطلاعاتی را ارائه نمیدهد. پس در حال حاضر به دلیل نبود قوانین خاص، انسانها الزامی برای رعایت اخلاق در هوش مصنوعی ندارند.

کلام آخر

هوش مصنوعی بدون اقدامات ایمنی یا محدودیتهای مشخص میتواند آسیب زیادی به همراه داشته باشد. برای حل این مشکل، اخلاق هوش مصنوعی ایجاد شده است تا از حقوق انسانی محافظت کند و ماشینها را با رویکردی انسان محور آموزش دهد؛ اما هنوز زود است بخواهیم در این مورد تصمیم بگیریم که اخلاق AI چگونه خواهد بود.

مطمئنا هوش مصنوعی مانند هر نوع فناوری دیگری میتواند هم استفاده خوب و هم بد داشته باشد. تاریخ نشان داده است که انسان هزاران تعبیر از اخلاق داشته و از این طریق به همنوع خود ظلم کرده است. آینده مشخص خواهد کرد که تعبیر ما از اخلاق در هوش مصنوعی چه پیامدهایی خواهد داشت.

منابع:

www.builtin.com | www.linkedin.com

دیدگاهتان را بنویسید