با کمک هوش مصنوعی یک مدل یادگیری ماشینی طراحی شده است که میتواند یک اقدام مشخص را در یک کلیپ ویدیویی شناسایی کرده و بدون کمک انسان به آن برچسب بزند.

محققان MIT یک تکنیک یادگیری ماشینی را توسعه دادند که یاد میگیرد دادهها را به گونهای نشان دهد که مفاهیمی در محتواهای بصری و صوتی به اشتراک گذاشته شدهاند را درک کند. مدل آنها میتواند مشخص کند که در کجای یک ویدیو یک اقدام خاص انجام می شود و به آن برچسب بزند.

انسانها دنیا را با کمک ترکیبی از روشهای مختلف مثل بینایی، شنوایی و گفتاری درک میکنند. از سوی دیگر ماشینها از طریق دادههایی که الگوریتم ها میتوانند پردازش کنند، جهان را تفسیر میکنند.

بنابراین، هنگامی که یک ماشین یک عکس را “میبیند”، باید آن عکس را به دادههایی که میتواند برای انجام کاری مثل طبقهبندی تصویر استفاده کند، رمزگذاری کند. این فرآیند زمانی پیچیدهتر میشود که ورودیها در فرمتهای مختلف مانند فیلمها، کلیپهای صوتی و تصاویر ارائه شوند.

چالش اصلی در این جا این است که چگونه یک دستگاه میتواند روشهای مختلف را هم راستا کند؟ به عنوان انسان این کار برای ما آسان است. وقتی که یک ماشین میبینیم و بعد صدای آن را میشنویم متوجه میشویم که هر دو مورد مرتبط با ماشین است.

الکساندر لیو، دانشجوی تحصیلات تکمیلی در آزمایشگاه علوم کامپیوتر و هوش مصنوعی (CSAIL) میگوید: ” این موضوع برای یادگیری ماشین چندان ساده نیست.”

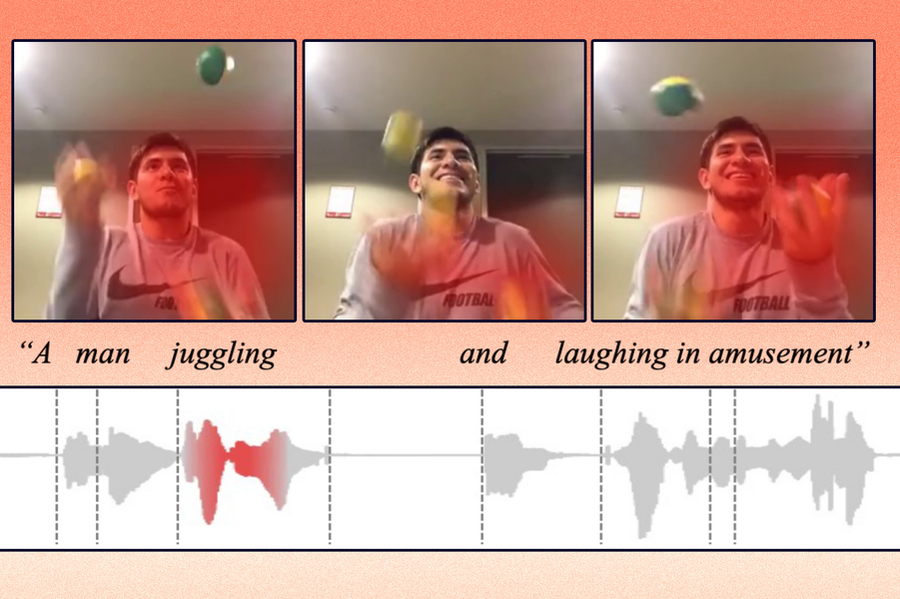

لیو و همکارانش یک تکنیک هوش مصنوعی را توسعه دادند که یاد میگیرد، دادهها را به شکلی نمایش دهد که مفاهیمی که بین روشهای بصری و صوتی به اشتراک گذاشته شدهاند را درک کند. برای مثال روش آنها میتواند یاد بگیرد که عمل گریه کردن نوزاد در یک ویدئو به کلمه “گریه کردن” در یک کلیپ صوتی مرتبط است.

با استفاده از این دانش مدل یادگیری ماشین آنها میتواند مشخص کند که در کدام قسمت ویدیو یک اقدام خاص انجام شده و برای استفادههای بعدی به آن برچسب بزند.

این روش از روشهای دیگر یادگیری ماشین در مواردی مثل بازیابی چندوجهی اطلاعات بهتر عمل میکند. این کار میتواند به درخواستهای کاربران برای مواردی مثل پیدا کردن یک داده مشخص در مکالمات یک ویدیوی مناسب باشد. همچنین این مدل طراحی شده به کاربران کمک می کند تا راحتتر درک کنند که چرا ماشین این دادهها را در پاسخ به درخواست آنها نشان داده است.

پیشبینی میشود که در آینده روباتها بتوانند از این تکنیک برای درک بهتر مفاهیم جهان مشابه با آن چه که انسانها انجام میدهند، استفاده کنند.

دانشمندان زیادی از نقاط مختلف دنیا به این پژوهش پیوستند و قرار است نتایج بدست آمده از این تحقیق را در نشست سالانه انجمن Computational Linguistics ارائه دهند.

یادگیری بازنمایی (Learning representations) چیست؟

محققان در این پژوهش بر یادگیری بازنمایی تمرکز میکنند. یادگیری بازنمایی مدلی از یادگیری ماشینی است که به دنبال آسانتر کردن تبدیل دادههای ورودی برای انجام کارهای مختلف مثل طبقهبندی یا پیشبینی است.

مدل یادگیری بازنمایی دادههای خام مثل ویدئوها و توضیحات متنی مربوطه آنها را گرفته و ویژگیها یا مشاهدات خود در مورد اشیا و اقدامات مشخصی را در ویدئو استخراج و رمزگذاری میکند.

به عنوان مثال یک کلیپ ویدیویی از فردی که در حال شعبدهبازی است ممکن است با برچسب ” شعبدهبازی” مشخص شود.

محققان در این مدل محدودیتی در نظر گرفتند به طوری که تنها میتوان از ۱۰۰۰ کلمه برای برچسب زدن vector ها استفاده کرد. این مدل میتواند تصمیم بگیرد که چه اعمال یا مفاهیمی را میخواهد در یک vector رمزگذاری کند، اما تنها میتوان از ۱۰۰۰ vector استفاده کرد. این مدل کلمههایی را انتخاب میکند که بتوانند به بهترین شکل دادهها را نشان دهند.

در این روش محققها به جای رمزگذاری دادهها از روشها و شبکههای مختلفی برای رمزگذاری دادهها استفاده میکنند. انجام این کار به مدل این امکان را میدهد که ارتباط بین محتواها را یاد بگیرد. برای مثال تفاوت ویدئویی که در آن شخصی در حال انجام شعبدهبازی است را از یک فایل صوتی که در آن کلمه شعبدهبازی میگوید، تشخیص دهد.

برای کمک به پردازش دادههای سیستم از روشهای چندگانه، آنها الگوریتمی را طراحی کردند که ماشین را برای رمزگذاری مفاهیم مشابه در همان vector هدایت میکند.

یکی از محققها توضیح میدهد که اگر یک ویدیو درباره خوکها باشد، مدل ممکن است یکی از ۱۰۰۰ vector خود را به کلمه «خوک» اختصاص دهد. اگر مدل از شخصی کلمه «خوک» را در یک کلیپ صوتی بشنود ، همچنان باید از همان vector برای رمزگذاری آن استفاده کند.

بازیابی چندوجهی محتوا با کمک هوش مصنوعی

آنها مدل وظایف بازیابی چند وجهی را با استفاده از سه مجموعه داده مورد آزمایش قرار دادند: یک مجموعه داده video-text شامل کلیپهای ویدیویی و عنوانهای متنی، یک مجموعه داده video-audio شامل ویدیوهایی با عنوانهای صوتی و یک مجموعه داده image-audio شامل تصاویر با عنوانهای صوتی بودند.

به عنوان مثال در مجموعه داده video-audio، این مدل ۱۰۰۰ کلمه را برای نشان دادن اقدامات در ویدئوها انتخاب کرد. سپس وقتی محققان به آن کوئریهای صوتی را تزریق کردند، مدل تلاش کرد تا کلیپی را پیدا کند که به بهترین شکل با آن کلمات بیان شده در فایل صوتی مطابقت داشته باشد.

به گفته Liu یکی از پژوهشگران : این کار درست مانند زمانی است که شما یک کلمه را در گوگل سرچ میکنید، شما یک عبارت را تایپ میکنید و ماشین تلاش میکند تا مرتبطترین چیزهایی که به دنبالش هستید را به شما بگوید. با این تفاوت که ما این کار را در فضای vector انجام میدهیم.

این مدل در مقایسه با سایر مدلها نتایج مورد انتظارتری نمایش میدهد و درک آن نیز راحتتر است.

از آنجا که این مدل تنها میتواند از ۱۰۰۰ کلمه کلی برای برچسب گذاری vector استفاده کند، کاربر میتواند به راحتی ببیند که ماشین از کدام کلمات استفاده کرده تا نتیجه بگیرد که ویدیو و کلمات گفتاری مشابه هم هستند.

Liu همچنین میگوید این موضوع میتواند استفاده از این مدل را در شرایط دنیای واقعی که در آن درک کاربران از چگونگی تصمیمگیری ضروری است، آسانتر کند.

این مدل هنوز محدودیتهایی دارد که پژوهشگران امیدوارند در آینده بتوانند به آنها بپردازند. Liu میگوید: برای مثال تحقیقات آنها در یک زمان بر روی دادههای حاصل از دو متغیر متمرکز است، اما در دنیای واقعی انسانها به طور همزمان با متغیرهای دادهای زیادی مواجه میشوند.

او اضافه میکند: ” ما میدانیم که ۱۰۰۰ کلمه روی این مجموعه داده کار میکنند، اما نمیدانیم که آیا میتوان آن را به یک مشکل در دنیای واقعی تعمیم داد یا خیر.”

علاوه بر این، تصاویر و ویدئوهایی که در پژوهش استفاده شده بودند، مجموعه دادههایی شامل اشیا یا اقدامات ساده بودند در حالی که دادهها در دنیای واقعی خیلی پیچیده هستند. آنها همچنین قصد دارند، بررسی کنند که روش آنها وقتی که تنوع وسیعتری از ورودیها وجود دارد، چقدر قابلیت مقیاسگذاری دارد؟

آزمایشگاه هوش مصنوعی MIT-IBM Watson و شرکتهای عضو آن Nexplore و Woodside و آزمایشگاه MIT Lincoln از انجام این تحقیق حمایت کردند.

این مقاله ترجمهای از پست Artificial intelligence system learns concepts shared across video, audio, and text از مجله خبری دانشگاه MIT است.

دیدگاهتان را بنویسید