آموزش مدل در یادگیری ماشین مرحلهای است که در آن الگوریتمها با استفاده از دادههای واقعی، الگوها را شناسایی کرده و توانایی پیشبینی پیدا میکنند. مدل زمانی «کار میکند» که روی دادههای درست و با تنظیمات درست آموزش ببیند. در عمل، این یعنی انتخاب الگوریتم مناسب، ساختن پایپلاین داده قابلاعتماد، تعریف معیارهای سنجش و تکرار این چرخه تا رسیدن به عملکرد قابلقبول.

در این مقاله، ضمن تفکیک مفاهیم «مدل» و «الگوریتم»، انواع پارادایمهای یادگیری و گامهای آموزش مدل را مرور میکنیم. با ما همراه باشید.

آموزش مدل (Model Training) چیست؟

آموزش مدل فرایندی است که طی آن، یک مدل، یادگیری ماشین یاد میگیرد عملکرد خود را در انجام وظایف خاص بهینه کند. این کار با استفاده از مجموعهای از دادههای آموزشی انجام میشود که شامل نمونههایی از مسائلی است که مدل در دنیای واقعی با آنها مواجه خواهد شد.

هرچه دادههای آموزشی شباهت بیشتری به شرایط واقعی داشته باشند، مدل بهتر میتواند الگوها و روابط بین دادهها را تشخیص دهد و در نتیجه، در مواجهه با دادههای جدید، پیشبینیهای دقیقتری ارائه دهد.

فرایند آموزش، مرحلهای کلیدی در چرخه عمر مدلهای هوش مصنوعی است؛ از مدلهای ساده پیشبینی بر پایه رگرسیون خطی گرفته تا شبکههای عصبی پیچیدهای که هسته اصلی هوش مصنوعی مولد (Generative AI) را تشکیل میدهند.

در واقع، آموزش مدل همان جایی است که «یادگیری» در یادگیری ماشین اتفاق میافتد.

فرایند آموزش مدل چگونه انجام میشود؟

در یادگیری ماشین، آموزش به معنای تنظیم پارامترهای مدل است؛ پارامترهایی مانند وزنها (weights) و بایاسها که در توابع ریاضی الگوریتم نقش دارند. هدف از این تنظیم، دستیابی به خروجیهای دقیقتر است. مقادیر نهایی این پارامترها در واقع تجسم عددی «دانش» مدل هستند.

از دید ریاضی، هدف آموزش کمینهسازی تابع زیان (Loss Function) است؛ تابعی که خطای مدل در پیشبینیهایش را اندازه میگیرد. زمانی که مقدار این تابع به حد قابلقبولی برسد، مدل «آموزشدیده» محسوب میشود. در یادگیری تقویتی (Reinforcement Learning) هدف برعکس است: پارامترها طوری تنظیم میشوند که تابع پاداش بیشینه شود.

در عمل، آموزش مدل یک فرایند تکرارشونده است که شامل مراحل زیر میشود:

جمعآوری و آمادهسازی دادهها، اجرای مدل روی دادههای آموزشی، اندازهگیری میزان خطا، بهینهسازی پارامترها و ارزیابی عملکرد روی دادههای اعتبارسنجی.

این چرخه تا زمانی ادامه مییابد که مدل به عملکرد مطلوب برسد. در برخی موارد نیز لازم است ساختار مدل و تنظیمات یادگیری آن بازبینی شوند؛ فرایندی که با عنوان تنظیم ابرپارامترها (Hyperparameter Tuning) شناخته میشود.

همچنین ممکن است یک مدل از پیش آموزشدیده برای وظایف خاصتر با دادههای جدید فاینتیون شود. آموزش اولیه مدل را در این حالت پیشآموزش (Pretraining) مینامند. فاینتیون در واقع یکی از روشهای یادگیری انتقالی (Transfer Learning) است؛ رویکردی که از مدلهای آماده برای کاربردهای جدید استفاده میکند.

تفاوت مدل و الگوریتم

در حوزه هوش مصنوعی، واژههای «مدل» و «الگوریتم» گاهی بهاشتباه بهجای هم به کار میروند، در حالی که معنای یکسانی ندارند. تفاوت اصلی این دو در نحوه ارتباطشان با فرایند آموزش مدل است.

الگوریتم در واقع مجموعهای از دستورالعملها یا مراحل محاسباتی است و معمولا بهصورت معادلات ریاضی یا شبهکد که برای انجام پیشبینی یا تصمیمگیری بر اساس ورودیهای دادهشده به کار میرود.

در مقابل، مدل نتیجه اجرای الگوریتم و بهینهسازی پارامترهای آن بر پایه یک مجموعهداده آموزشی است. هدف از این بهینهسازی، افزایش دقت و کارایی الگوریتم در پیشبینی یا تحلیل دادههای جدید است؛ دادههایی که به دادههای آموزشی شباهت دارند. در علم داده، به این فرایند «برازش الگوریتم با دادهها» گفته میشود.

به بیان سادهتر، مدل هوش مصنوعی برای پیشبینی یا تصمیمگیری استفاده میشود، در حالی که الگوریتم منطق ریاضی پشت آن مدل است.

ممکن است دو مدل از یک الگوریتم واحد استفاده کنند اما چون با دادههای متفاوتی آموزش دیدهاند، وزنها و بایاسهای درونی آنها (یعنی پارامترهای یادگرفتهشده) متفاوت خواهد بود.

در یادگیری عمیق (Deep Learning)، مدلها معمولا شبکههای عصبی چندلایه هستند، از همین رو واژهی «عمیق» به کار میرود؛ نه الگوریتمهای صریحی مثل رگرسیون لجستیک یا بیز ساده (Naïve Bayes).

دو مدل یادگیری عمیق ممکن است از یک ساختار کلی، مثلا یک اتوانکودر (Autoencoder) استفاده کنند اما در تعداد لایهها، تعداد نورونها در هر لایه، یا نوع تابع فعالسازی (Activation Function) تفاوت داشته باشند.

انواع روشهای آموزش مدل

در بیشتر موارد، آموزش مدل مترادف با «یادگیری» است؛ به این معنا که متخصص داده مدل را آموزش میدهد و مدل از دادهها یاد میگیرد. یادگیری در یادگیری ماشین یعنی تنظیم پارامترهای یک الگوریتم تا زمانی که خروجی مدل به سطحی از دقت یا کارایی مورد انتظار برسد.

آموزش نیز شامل مراحل آمادهسازی دادههای آموزشی و تنظیم ابرپارامترهاست، مثل انتخاب تابع زیان (Loss Function)، تعیین نرخ بهروزرسانی پارامترها (Learning Rate) یا تغییر ساختار شبکه عصبی؛ تا این فرایند یادگیری به بهترین شکل انجام شود.

مدلهای هوش مصنوعی معمولا در یکی از سه دسته اصلی یادگیری ماشین قرار میگیرند:

یادگیری نظارتشده، یادگیری بدوننظارت و یادگیری تقویتی.

هرکدام از این رویکردها هدف، کاربرد و روش آموزش خاص خود را دارند. در ادامه به هر کدام از این رویکردها میپردازیم.

۱- یادگیری نظارتشده (Supervised Learning)

در این روش، مدل با استفاده از دادههایی آموزش داده میشود که برای هر ورودی، خروجی «درست» مشخص است. هدف این است که مدل یاد بگیرد برای دادههای جدید، خروجی مشابه با مقدار واقعی (Ground Truth) تولید کند. این نوع یادگیری برای مسائلی مانند طبقهبندی (Classification) و رگرسیون (Regression) استفاده میشود، جایی که دقت پیشبینی اهمیت زیادی دارد.

۲- یادگیری بدوننظارت (Unsupervised Learning)

در یادگیری بدوننظارت، مدل تلاش میکند الگوها، ساختارها و ارتباطهای درونی موجود در دادهها را بدون داشتن پاسخ درست یا برچسب مشخص، کشف کند.

در این رویکرد، هیچ مقدار مرجع بیرونی برای مقایسه خروجیها وجود ندارد. کاربردهای رایج آن شامل خوشهبندی دادهها (Clustering)، کاهش ابعاد (Dimensionality Reduction) و تشخیص ناهنجاریها (Anomaly Detection) است.

۳- یادگیری تقویتی (Reinforcement Learning)

در یادگیری تقویتی، مدل در یک محیط پویا عمل میکند و یاد میگیرد که برای رسیدن به بیشترین پاداش، چه تصمیماتی بگیرد. در این روش، مدل از طریق تجربه و بازخورد (Reward/Feedback) بهتدریج عملکرد خود را بهینه میکند. این نوع یادگیری در حوزههایی مانند رباتیک، بازیها و سیستمهای تصمیمگیری خودکار بسیار پرکاربرد است.

۴- رویکردهای ترکیبی و پیشرفته

در عمل، مرز بین این دستهها همیشه کاملا مشخص نیست. برای مثال، یادگیری خودنظارتی (Self-Supervised Learning) را میتوان هم نوعی یادگیری نظارتشده دانست (چون دادههای برچسبدار مصنوعی تولید میکند) و هم نوعی یادگیری بدوننظارت (چون از دادههای خام بدون برچسب واقعی استفاده میکند). همچنین یادگیری نیمهنظارتی (Semi-Supervised Learning) ترکیبی از هر دو روش نظارتشده و بدوننظارت است.

در بسیاری از سیستمهای هوش مصنوعی مدرن، از چند نوع یادگیری در کنار هم استفاده میشود. برای مثال، مدلهای زبانی بزرگ (LLMs) که در برنامههای گفتگو محور مانند چتباتها بهکار میروند، معمولا با ترکیبی از روشهای زیر آموزش میبینند:

۱. پیشآموزش خودنظارتی (Self-Supervised Pretraining)

۲. فاینتیون نظارتشده (Supervised Fine-Tuning)

۳. یادگیری تقویتی از بازخورد انسانی (RLHF: Reinforcement Learning from Human Feedback)

این ترکیب باعث میشود مدل هم از دادههای گسترده یاد بگیرد، هم با بازخورد انسانی دقیقتر و طبیعیتر پاسخ دهد.

چگونه یک مدل یادگیری ماشین را آموزش دهیم

چرخه توسعه مدل شامل چندین مرحله است که برخی از آنها بهصورت تکرارشونده انجام میشوند تا زمانی که نتایج رضایتبخش بهدست آید.

اگرچه یادگیری تقویتی، نظارتشده و بدوننظارت هرکدام ویژگیهای خاص خود را در فرایند آموزش دارند، اما روند کلی آموزش مدل معمولا شامل مراحل زیر است:

۱- انتخاب مدل

انتخاب الگوریتم مناسب (یا معماری شبکه عصبی) تنها به نوع مسئله یا دادههایی که مدل با آنها کار میکند محدود نمیشود. مدل ایدئال به عواملی مانند اولویت بین سرعت و کارایی در برابر دقت و عملکرد، بودجه و منابع سختافزاری در دسترس نیز بستگی دارد. بهعنوان مثال، آموزش یا فاینتیون یک مدل زبانی بزرگ (LLM) معمولا به چندین واحد پردازش گرافیکی (GPU) نیاز دارد.

۲- جمعآوری داده

بهدستآوردن دادههای آموزشی باکیفیت برای مسئله مورد نظر، کار سادهای نیست؛ بهویژه در مدلهای یادگیری عمیق که برای آموزش موثر به هزاران یا حتی میلیونها نمونه نیاز دارند.

هرچند استفاده از یک خط داده اختصاصی (Proprietary Data Pipeline) میتواند امکان سفارشیسازی و مزیت رقابتی ایجاد کند اما برای بیشتر حوزهها و وظایف، مجموعهدادههای متنباز معتبر نیز در دسترس هستند. در برخی زمینهها، بهویژه پردازش زبان طبیعی (NLP)، تولید داده مصنوعی (Synthetic Data) نیز به گزینهای کاربردی و قابلاتکا تبدیل شده است.

۳- آمادهسازی داده

برای استفاده در آموزش، دادههای خام، بهخصوص زمانی که از چند منبع مختلف گردآوری شدهاند، معمولا نیاز به پیشپردازش دارند. این کار ممکن است شامل پاکسازی دادهها، نرمالسازی مقادیر و یکسانسازی قالبها باشد. امروزه سرویسها و ابزارهای متعددی وجود دارند که بخشی یا تمام این فرایند را خودکار انجام میدهند؛ برای مثال، Docling یک ابزار متنباز است که فایلهای PDF و دیگر فرمتها را به متنی قابلخواندن برای ماشین تبدیل میکند، در حالی که ساختارهای مهم آنها را حفظ میکند.

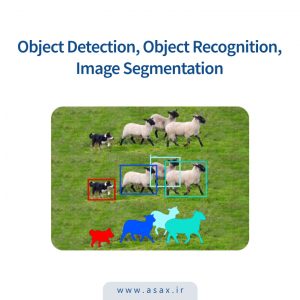

در یادگیری نظارتشده، دادهها باید برچسبگذاری (Labeling) و گاهی با جزئیات زیاد حاشیهنویسی (Annotation) شوند. برای نمونه، تصاویری که برای آموزش مدلهای بخشبندی تصویر (Image Segmentation) استفاده میشوند باید تا سطح پیکسل برچسبگذاری شوند. این کار میتواند زمانبر و پرهزینه باشد و باید در برنامهریزی زمانی و بودجه لحاظ شود.

۴- انتخاب ابرپارامترها

حتی پس از انتخاب الگوریتم یا معماری مدل، هنوز تصمیمات مهم دیگری باید گرفته شود. الگوریتمهای یادگیری ماشین بهندرت بهصورت «یک نسخه برای همه» قابل استفادهاند و شبکههای عصبی حتی از این هم کمتر استاندارد هستند.

انتخاب ابرپارامترهای مناسب، اجزای تنظیمپذیری که خارج از فرایند بهینهسازی پارامترها قرار دارند، برای انجام آموزش موثر و کارآمد ضروری است.

زمانی که فرایند آموزش نتیجه رضایتبخشی ندارد یا هنگام کار با الگوریتمهای یادگیری بدوننظارت و الگوریتمهای یادگیری نظارتشدهی غیرپارامتری مانند درختهای تصمیم، میتوان عملکرد مدل را از طریق تنظیم ابرپارامترها بهبود داد.

در بسیاری از موارد، دستیابی به بهترین مقادیر برای نرخ یادگیری، اندازه دسته، تابع زیان و جملههای منظمسازی یا الگوریتم بهینهسازی، نیازمند آزمون و خطا است.

یکی از این پارامترها مقداردهی اولیهی پارامترهای قابلآموزش است. بهطور معمول، این مقادیر بهصورت تصادفی مقداردهی میشوند اما حتی برای تصادفیسازی نیز روشهای مختلفی وجود دارد.

در برخی موارد، مقادیر اولیه بهینه را میتوان از طریق روشی به نام یادگیری فراگیر (Meta Learning) نیز آموخت.

۵- عملکرد روی دادههای آموزشی

پس از تعیین پارامترهای اولیه و ابرپارامترها، مدل یک دسته از نمونههای دادهی ورودی را از مجموعهداده آموزشی پردازش میکند. از آنجا که پارامترهای اولیه تصادفی هستند، خروجی مدل در ابتدا معمولا «خوب» نیست. هدف از اولین اجرای آموزش صرفا ایجاد یک خط پایه برای بهینهسازیهای بعدی است.

اندازهی دسته، یعنی تعداد نمونههایی که در هر نوبت پیش از محاسبه زیان و بهروزرسانی پارامترها پردازش میشوند، خود یکی از ابرپارامترهای مهم است.

امروزه فریمورکهای متنباز زیادی برای پیکربندی و اجرای مدلهای یادگیری ماشین وجود دارند، مانند PyTorch، Keras و TensorFlow. بیشتر این فریمورکها با Python یا JavaScript کار میکنند و بهدلیل متنباز بودن، شامل مجموعهای گسترده از آموزشها و مستندات آموزشی برای مبتدیان هستند.

۶- محاسبه زیان (یا پاداش)

در طول فرایند آموزش، تابع زیان انتخابشده، اختلاف میان خروجیهای مدل و پاسخهای «درست» مربوط به هر ورودی را اندازهگیری میکند. در یادگیری عمیق که در آن مدلها از شبکههای عصبی با معادلات تو در تو تشکیل شدهاند، پسانتشار (Backpropagation) برای محاسبه سهم هر گره در شبکه نسبت به زیان کلی مورد استفاده قرار میگیرد.

در یادگیری نظارتشده، هدف رسمی آموزش معمولا کمینهسازی تابع زیان است. برخی معماریهای مدل مانند خودرمزگذارهای واریاسیونی (VAEs)، بهجای آن، مسئله را بهصورت بیشینهسازی یک تابع جایگزین برای تابع زیان بازنویسی میکنند.

در الگوریتمهای یادگیری تقویتی، هدف معمولا بیشینهسازی تابع پاداش و گاهی همزمان کمینهسازی یک جمله منظمسازی (Regularization Term) است که رفتارهای نامطلوب را جریمه میکند.

۷- بهینهسازی پارامترها

بهینهسازی الگوریتمهای یادگیری ماشین معمولا توسط الگوریتمی جداگانه انجام میشود. در ریاضیات، الگوریتم بهینهسازی برای کمینه یا بیشینه کردن یک تابع دیگر طراحی میشود، در اینجا، تابع زیان یا تابع پاداش، از طریق تعیین مقادیر بهینه برای متغیرهای آن تابع.

در یادگیری ماشین، این متغیرها همان وزنها و بایاسها درون الگوریتم یا بین گرههای مختلف شبکه عصبی هستند.

الگوریتم بهینهسازی مناسب به نوع مدل در حال آموزش بستگی دارد.

بسیاری از الگوریتمهای یادگیری ماشین، بهویژه مدلهای مبتنی بر شبکه عصبی، از انواع مختلف گرادیان کاهشی استفاده میکنند.

برخی الگوریتمها با توابع درجهدو، مانند ماشینهای بردار پشتیبان (SVM)، بهتر است از برنامهریزی درجهدو (Quadratic Programming) استفاده کنند.

الگوریتمهای رگرسیون خطی (Linear Regression) معمولا با روش کمترین مربعات (Least Squares) بهینه میشوند.

در یادگیری تقویتی نیز الگوریتمهای بهینهسازی خاص خود وجود دارند، مانند PPO (Proximal Policy Optimization)، DPO (Direct Policy Optimization) و A2C (Advantage Actor Critic).

این چرخه آموزشی شامل تنظیم ابرپارامترها، اجرای مدل روی دستهای از دادههای آموزشی، محاسبه زیان و بهینهسازی پارامترها، بهصورت تکراری انجام میشود تا زمانی که مقدار زیان به اندازه کافی کاهش یابد.

۸- ارزیابی مدل

عملکرد عالی روی دادههای آموزشی بهتنهایی نشاندهنده موفقیت کامل مدل یا آمادگی آن برای استفاده در دنیای واقعی نیست. باید مراقب بیشبرازش (Overfitting) بود؛ وضعیتی که در آن مدل دادههای آموزشی را بهصورت کامل حفظ کرده اما نمیتواند الگوهای خود را به دادههای جدید تعمیم دهد، در نتیجه هدف اصلی آموزش از بین میرود. میتوان گفت بیشبرازش در یادگیری ماشین معادل «آموزش برای امتحان» در آموزش انسانی است.

برای جلوگیری از بیشبرازش، روش رایج این است که بخشی از دادههای آموزشی را در فرایندی به نام اعتبارسنجی متقابل (Cross-Validation) کنار گذاشته شود. این روش به مدل اجازه میدهد روی دادههای جدیدی که تاکنون ندیده آزمایش شود تا اطمینان حاصل شود که آموزش بهدرستی انجام شده است.

نتیجهگیری

آموزش مدل یک مسیر خطی نیست؛ چرخهای تکرارشونده است که با داده مناسب، ابرپارامترهای معقول و ارزیابی منظم به نتیجه میرسد. با پایبندی به اصول انتخاب مدل، تمیزکاری داده، تنظیم و اعتبارسنجی، میتوان مدلی ساخت که علاوه بر دقت، قابلیت تعمیمپذیری واقعی داشته باشد.

منابع

سوالات متداول

در واقع این دو اصطلاح به یک فرایند اشاره دارند. آموزش، مرحلهای است که در آن یادگیری اتفاق میافتد؛ یعنی مدل با تنظیم وزنها و بایاسها، از دادهها الگو میگیرد و عملکرد خود را بهبود میدهد.

میزان دادهی موردنیاز بستگی به نوع مسئله، پیچیدگی مدل و تنوع دادهها دارد. مدلهای ساده ممکن است با چند هزار نمونه به نتیجه برسند اما مدلهای یادگیری عمیق (بهویژه LLMها یا مدلهای بینایی) معمولا به میلیونها داده برچسبدار نیاز دارند.

پارامترها درون مدل قرار دارند و طی آموزش یاد گرفته میشوند (مثل وزنها و بایاسها). ابرپارامترها بیرون از مدل تعریف میشوند و یادگرفتنی نیستند، مثل نرخ یادگیری، اندازهی دسته یا تعداد لایهها و باید قبل یا حین آموزش تنظیم شوند.

اگر مدل روی دادههای آموزشی عملکرد بسیار خوبی دارد اما روی دادههای جدید یا اعتبارسنجی ضعیف عمل میکند، یعنی بیشبرازش کرده. در این حالت، مدل بهجای یادگیری الگوهای عمومی، دادههای آموزشی را حفظ کرده است.

در حال حاضر PyTorch، TensorFlow و Keras محبوبترین فریمورکهای متنباز برای آموزش مدلهای یادگیری ماشین و یادگیری عمیق هستند. برای کارهای سبکتر یا آموزشی نیز scikit-learn گزینهای ساده و قدرتمند است.

دیدگاهتان را بنویسید