رخدادهای مرتبط با امنیت در هوش مصنوعی با سرعتی چشمگیر در حال افزایشاند. طبق گزارش Forbes، از سال ۲۰۱۷ تا ۲۰۲۳، این رخدادها بیش از ۶۹۰درصد رشد داشتهاند و انتظار میرود این روند همچنان شتاب بگیرد. این موج تنها به شرکتهای بزرگ محدود نیست و همه را تحت تاثیر قرار میدهد؛ از استارتاپها گرفته تا غولهای Fortune 500.

دامنه ریسکهای مرتبط با هوش مصنوعی بسیار گستردهتر از مواردی است که بهطور عمومی گزارش میشود. دادههای موجود بیشتر شامل نقضهای امنیتی در سازمانهای بزرگی مثل Facebook، Tesla و OpenAI است. با این حال، تعداد زیادی از تهدیدات ناشناخته در پروژههای کوچکتر و پیادهسازیهای خصوصی هوش مصنوعی وجود دارد که بهطور رسمی ثبت یا رسانهای نمیشوند.

پایگاه داده AI Incident Database منبع ارزشمندی برای آشنایی با رخدادهای شناختهشده و رایج امنیتی در هوش مصنوعی است. با این حال، باید توجه داشت که در اکوسیستم امنیت هوش مصنوعی، همچنان لایههای گستردهای از تهدیدات ناشناخته و پیشبینیناپذیر وجود دارند که در گزارشهای رسمی دیده نمیشوند.

نگاهی سریع به چالشهای هوش مصنوعی

پیچیدگی امنیت در هوش مصنوعی از ماهیت پویا و بهشدت بههمپیوسته این فناوری ناشی میشود. تحقیقات NIST نشان میدهد بسیاری از سیستمهای هوش مصنوعی شامل میلیاردها یا حتی تریلیونها نقطه تصمیمگیری هستند. برخلاف نرمافزارهای سنتی، این سیستمها بر پایه الگوریتمهای در حال تکامل، مجموعهدادههای عظیم و کاربردهای واقعی ساخته میشوند که رفتارشان در طول زمان تغییر میکند.

برخی از مهمترین عوامل پیچیدگی عبارتند از:

- چالشهای فنی: مدیریت الگوریتمهای پیشرفته و پردازش دادههای عظیم

- چشمانداز تهدیدات: حرکت در قلمروی تقریبا ناشناخته امنیتی

- تنوع ریسکها: نقض داده، حملات خصمانه (adversarial attacks)، پیامدهای اخلاقی و مدیریت آسیبپذیریها

علاوهبر این، استفاده کارمندان هم سطح ریسک را بالاتر میبرد. حتی اقداماتی که با هدف افزایش بهرهوری انجام میشوند میتوانند منجر به نشت داده شوند. بهعنوان نمونه، کارمندی که از ChatGPT استفاده میکند اما تنظیمات پیشفرض حریم خصوصی را تغییر نداده است، ممکن است ناخواسته اطلاعات محرمانه سازمان را در اختیار سیستم قرار دهد.

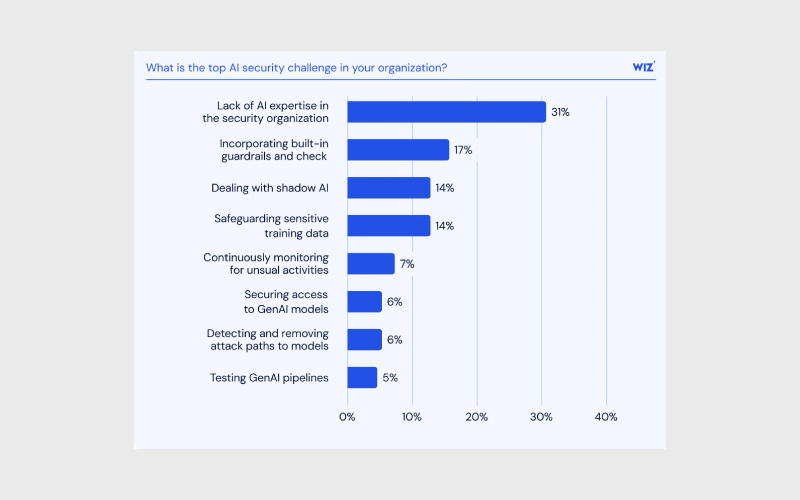

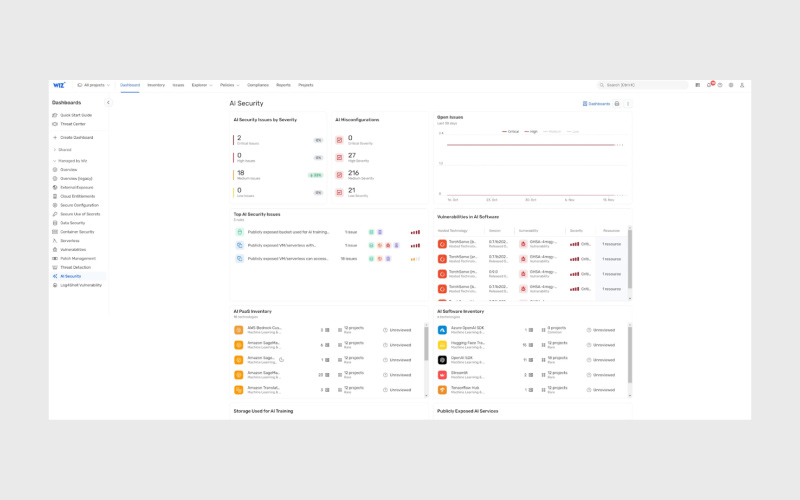

مهمترین چالشهای هوش مصنوعی بر اساس نتایج نظرسنجی گزارش «آمادگی برای هوش مصنوعی» را در تصویر زیر میتوانید مشاهده کنید:

برای مدیریت این ریسکها و بسیاری از تهدیدات دیگر مرتبط با هوش مصنوعی، سازمانها نیازمند رویکردی امنیتی راهبردی و هماهنگ هستند؛ رویکردی که فراتر از اقدامات سنتی امنیت سایبری عمل کرده و متناسب با نیازهای خاص هوش مصنوعی طراحی شده باشد.

۸ روش برای امنیت هوش مصنوعی

امنیت موثر در حوزه هوش مصنوعی نیازمند همکاری نزدیک و بینتیمی است؛ بهویژه میان SecOps، DevOps و تیمهای GRC. این رویکرد یکپارچه باعث ایجاد زیرساخت امنیتی قدرتمند میشود، در حالی که همچنان ظرفیت تحولآفرین هوش مصنوعی برای کسبوکار حفظ میشود.

اهداف هر تیم:

- SecOps: طراحی چارچوبهای امنیتی و پایش تهدیدات

- DevOps: تضمین استقرار سریع و چابک برای تیمهای علوم داده

- GRC: اطمینان از رعایت انطباقها و الزامات حاکمیتی در تمامی پیادهسازیهای هوش مصنوعی

هدف نهایی، ایجاد توازن میان کنترلهای امنیتی و بهرهوری است؛ بهگونهای که هم دسترسی ایمن به فناوریهای بیرونی هوش مصنوعی فراهم شود و هم فرایندهای توسعه کارامد باقی بمانند.

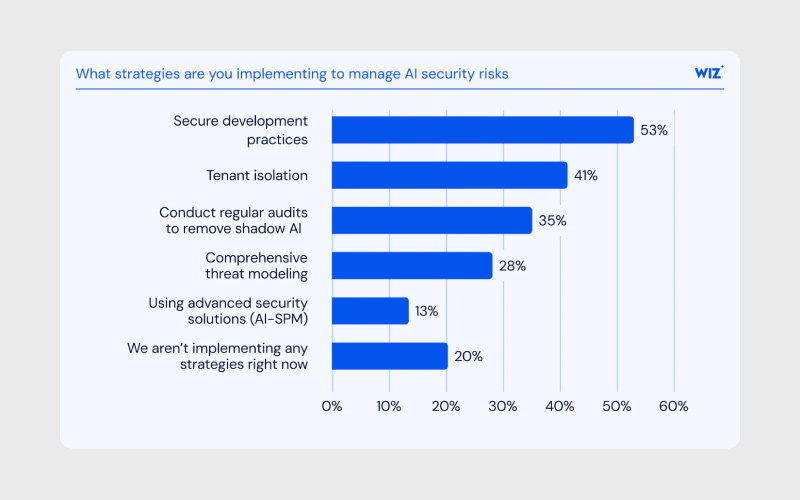

مهمترین راهبردهای امنیت در هوش مصنوعی بر اساس نتایج نظرسنجی گزارش «آمادگی برای هوش مصنوعی» را در زیر میبینید:

بیایید هشت روش متداول برای دستیابی به این اهداف را مرور کنیم:

۱- رویکرد چابک و بینتیمی را بپذیرید

چارچوبهای امنیتی چابک میتوانند خود را با سرعت بالای تحول در حوزه هوش مصنوعی تطبیق دهند و در عین حال، برای پیادهسازیهای فعلی نیز پوشش امنیتی فوری فراهم کنند. بسیاری از سازمانها همین حالا هم کارمندانی دارند که از ابزارهای هوش مصنوعی استفاده میکنند و موارد کاربردی مشخصی را توسعه دادهاند که نیاز به امنیت فوری دارند.

رویکرد اجرایی:

- استقرار سریع اولیه: یک چارچوب امنیتی پایه برای هوش مصنوعی بهسرعت ایجاد کنید تا فرایندهای موجود را پوشش دهد.

- بهبود تدریجی: با چرخههای کوتاه بهروزرسانی، کنترلها را متناسب با نیازهای خاص هوش مصنوعی سازمان تنظیم کنید.

- تکامل بر اساس اولویت: سازوکاری تعریف کنید تا ابتدا مهمترین ریسکها شناسایی و مدیریت شوند.

این رویکرد تضمین میکند که از همان ابتدا پوشش امنیتی وجود داشته باشد و در عین حال انعطافپذیری لازم برای پذیرش فناوریهای آیندهی هوش مصنوعی حفظ شود.

همچنین، در کنار تعریف این چارچوب در حال تکامل، باید از همان ابتدا فرهنگ گفتوگوی باز درباره امنیت هوش مصنوعی در سازمان نهادینه شود. تشویق به همکاری و تبادل نظر کمک میکند تا ریسکهای بالقوه سریعتر شناسایی و برطرف شوند و تیمهای امنیتی بتوانند الزامات امنیتی را شفافتر بیان و اجرا کنند.

| 💡 نکته حرفهای

پژوهشهای ما نشان میدهد که هوش مصنوعی بهسرعت در محیطهای ابری در حال گسترش است؛ بهطوریکه بیش از ۷۰٪ از سازمانها هماکنون از سرویسهای مدیریتشدهی هوش مصنوعی استفاده میکنند. این میزان پذیرش تقریبا همتراز با محبوبیت سرویسهای مدیریتشده Kubernetes است که در بیش از ۸۰٪ از سازمانها به کار گرفته میشوند! |

۲- درک چشمانداز تهدیدات هوش مصنوعی

هوش مصنوعی حوزهای پیچیده است که به دانش تخصصی عمیق نیاز دارد. بهترین حالت، همکاری تیمهای امنیتی با تیمهای علوم داده یا متخصصان AI است؛ با این حال، تیمهای امنیتی باید حداقل درک پایهای از چشمانداز تهدیدات مرتبط با هوش مصنوعی داشته باشند.

یکی از بهترین نقاط شروع، چارچوب MITRE ATLAS (مخفف Adversarial Threat Landscape for Artificial-Intelligence Systems) است. این چارچوب تاکتیکها و تکنیکهایی را تعریف میکند که مهاجمان برای نفوذ به سیستمهای هوش مصنوعی از آنها استفاده میکنند. همچنین، هنگام بررسی تهدیدات عمومی، میتوان از سه دسته اصلی آسیبپذیری تعریفشده توسط وزارت امنیت داخلی ایالات متحده بهره گرفت:

- حملاتی که از هوش مصنوعی استفاده میکنند

- حملاتی که مستقیما خود هوش مصنوعی را هدف قرار میدهند

- نقصهای طراحی در سیستمهای هوش مصنوعی

با بررسی دقیق چارچوب MITRE ATLAS، تیمهای امنیتی میتوانند از رخدادهای امنیتی گذشته درس بگیرند؛ چه رخدادهایی که برنامههای هوش مصنوعی مورد استفاده سازمان خودشان را تحتتاثیر قرار دادهاند و چه مواردی که در شرکتهای دارای گردشکار مشابه رخ داده است. اهمیت موضوع بسیار بالاست؛ همانطور که در دو نمونه واقعی دیده شد:

- نشت امنیتی ناشی از خطای محققان هوش مصنوعی مایکروسافت که منجر به افشای ۳۸ ترابایت داده شد.

- افشای توکنهای API در Hugging Face که خطرات جدی ایجاد کرد.

برای بهروز ماندن نیز ضروری است که آسیبپذیریهای شناختهشده مدلهای محبوب هوش مصنوعی و فناوریهای مورد استفاده را پیگیری کنید. این کار از طریق جستجوهای هدفمند و تنظیم هشدارهای آنلاین امکانپذیر است. بهعنوان مثال، گزارش Cloud Attack Retrospective شرکت Wiz نشان داد که اطلاعات محرمانه سرویس Bedrock تنها در عرض ۷ ساعت پس از افشا، برای استفاده غیرمجاز از مدلهای زبانی (LLM) مورد سوءاستفاده قرار گرفت.

۳- الزامات امنیتی هوش مصنوعی در سازمان خود را تعریف کنید

هر سازمان نیازهای امنیتی خاص خودش را دارد و در زمینه امنیت هوش مصنوعی هیچ چارچوب واحدی که برای همه مناسب باشد وجود ندارد.

سیاستهای حاکمیت سازمانمحور در حوزه هوش مصنوعی میتوانند خطمشیهای امنیتی پایه را در زمینههایی مثل حریم خصوصی دادهها، مدیریت داراییها، دستورالعملهای اخلاقی و استانداردهای انطباق تعریف کنند. این سیاستهای جامع بهطور ویژه برای پوشش دادن ریسکهای خاص هوش مصنوعی و وابستگیهای متنباز طراحی میشوند.

محورهای کلیدی حاکمیت:

- حریم خصوصی دادهها: حفاظت از دادههای حساس در فرایند آموزش و استنتاج مدلها

- مدیریت داراییها: ثبت و کنترل دقیق مدلها و مجموعهدادههای مورد استفاده

- مدیریت ریسک شخص ثالث: تضمین امنیت در استفاده از اجزای متنباز و راهکارهای ارائهشده توسط فروشندگان خارجی

- استانداردهای انطباق: هماهنگی با الزامات قانونی و چارچوبهای مرجع صنعت

مدیریت فعال ریسک مستلزم ارزیابی مداوم است. کنترلهای امنیتی ضروری در این مسیر شامل پایش مداوم رفتار سیستمها، تست نفوذ دورهای و برنامههای واکنش به رخداد مقاوم میشود.

با بازبینی و بهروزرسانی مستمر سیاستهای حاکمیت هوش مصنوعی، تیمهای امنیتی نهتنها انطباق با قوانین را تضمین میکنند، بلکه سازمان را برای مواجهه با تهدیدات نوظهور و پیچیده آینده آماده نگه میدارند.

۴- اطمینان از شفافیت و دید کامل

امنیت تنها زمانی قابل تحقق است که فرایندها شناسایی و قابل مشاهده باشند.

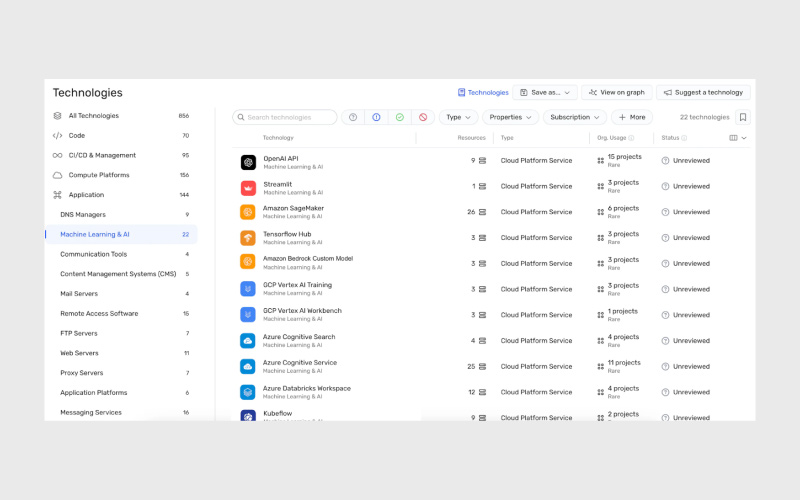

یکی از ابزارهای کلیدی در این زمینه، لیست اجزا و وابستگیهای هوش مصنوعی (AI-BOM) است؛ فهرستی جامع از همه اجزا و وابستگیهای هوش مصنوعی در سیستمهای سازمان. این فهرست شامل مولفههای داخلی، سرویسهای شخص ثالث و همچنین کتابخانهها و ابزارهای متنباز میشود که زیربنای برنامههای هوش مصنوعی سازمان را تشکیل میدهند.

فرایند پیادهسازی AI-BOM

- مستندسازی اجزا: ثبت همه مدلها، مجموعهدادهها، فریمورکها و کتابخانههای هوش مصنوعی

- نقشهبرداری وابستگیها: ردیابی ارتباطات میان اجزای مختلف سیستمهای هوش مصنوعی

- کارتهای مدل هوش مصنوعی: تهیهی مستندات استاندارد برای هر اپلیکیشن هوش مصنوعی پیش از افزودن آن به AI-BOM

کارتهای مدل هوش مصنوعی در واقع نقش «نقشه امنیتی» را ایفا میکنند؛ آنها جزئیات مدل، میزان انطباق با الزامات امنیتی و مسئولیتهای ذینفعان هر سیستم را بهطور شفاف مستند میسازند.

همچنین توجه داشته باشید که پایپلاینهای هوش مصنوعی که درونسازمانی (in-house) میزبانی میشوند، باید تنها از طریق فرایندهای مشخص CI/CD به محیط عملیاتی (Production) منتقل شوند. این الگو باعث میشود تدابیر امنیتی به صورت خودکار در جریان توسعه ادغام شوند، خطاهای انسانی کاهش یابد و فرایند استقرار مدلها سرعت بیشتری پیدا کند.

و در نهایت، فرایندهای حاکمیتی که با هدف شفافیت طراحی میشوند باید به ریسکهای مرتبط با Shadow AI (استفادهی کارمندان از ابزارهای هوش مصنوعی بدون اطلاع تیم امنیت) نیز بپردازند. ترویج شفافیت و پاسخگویی در سراسر سازمان و ایجاد مسیری ساده و رسمی برای معرفی فناوریهای جدید هوش مصنوعی، تنها راهکار موثر برای مقابله با Shadow AI است.

۵- فقط مدلها و ارائهدهندگان امن را بپذیرید

همانطور که میدانیم، هوش مصنوعی تا حد زیادی مبتنی بر جامعه متنباز و همکاریهای گسترده است. با توجه به نیاز به دادههای بزرگ و تخصصی، بسیاری از سازمانها تصمیم میگیرند برای بهرهبرداری از ظرفیتهای تجاری هوش مصنوعی، از راهکارهای متنباز و محصولات ارائهدهندگان شخص ثالث استفاده کنند. با این حال، استفاده از این مدلهای بیرونی در محیط عملیاتی نیازمند ایجاد توازن دقیقی میان کارایی و ایمنی است، زیرا کنترلهای امنیتی موجود برای این فناوریها محدود است.

به همین دلیل، تیمهای امنیتی باید بهعنوان بخشی از چارچوب هوش مصنوعی سازمان، یک فرایند ارزیابی سختگیرانه تعریف کنند تا تمامی مدلها و راهکارهای بیرونی بر اساس الزامات امنیتی از پیش تعیینشده بررسی شوند. این ارزیابی باید شامل مولفههایی مانند فریمورکها، کتابخانهها، وزنهای مدلها و مجموعهدادهها باشد. در حداقل سطح، الزامات امنیتی باید موارد زیر را پوشش دهند:

- رمزنگاری و مدیریت دادهها

- کنترل دسترسی

- انطباق با استانداردهای صنعتی و گواهینامههای معتبر

هر راهکار بیرونی که با موفقیت این فرایند را پشت سر بگذارد، میتواند بهعنوان راهکاری قابلاعتماد و امن شناخته شود.

با اعمال همین استانداردهای سختگیرانه بر تمامی اجزا، تیمهای امنیتی میتوانند اطمینان حاصل کنند که کل اکوسیستم هوش مصنوعی سازمان با بالاترین پروتکلهای امنیتی همسو است؛ در نتیجه ریسکهای احتمالی کاهش یافته و دفاع سازمان در برابر تهدیدات نوظهور تقویت میشود.

۶- تست امنیتی خودکار را پیادهسازی کنید

رفتار غیرمنتظره مدلهای هوش مصنوعی در محیط عملیاتی میتواند پیامدهای نامطلوبی داشته باشد؛ از کاهش کیفیت تجربه کاربر گرفته تا آسیب به اعتبار برند و حتی مشکلات حقوقی. هرچند مدلهای هوش مصنوعی ذاتا غیرقطعی (non-deterministic) هستند و امکان کنترل کامل آنها وجود ندارد اما با انجام تستهای جامع و خودکار میتوان ریسکهای ناشی از رفتارهای نادرست یا پیشبینینشده آنها را به شکل قابلتوجهی کاهش داد.

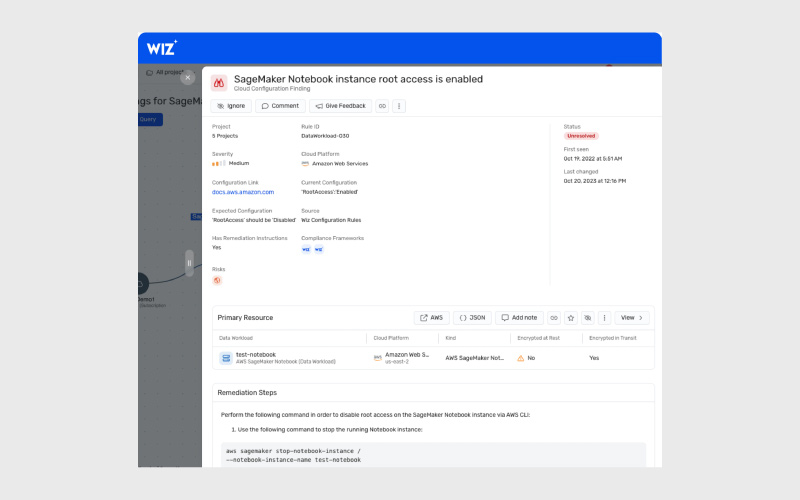

اسکن منظم مدلها و اپلیکیشنهای هوش مصنوعی به تیمهای امنیتی این امکان را میدهد که آسیبپذیریها را بهصورت پیشدستانه شناسایی کنند. این بررسیها میتواند شامل تستهای کلاسیک مثل اسکن امنیتی کانتینرها و وابستگیها یا فازینگ (Fuzz Testing) باشد و همچنین تستهای ویژهی AI با ابزارهایی مانند Alibi Detect یا Adversarial Robustness Toolbox. همچنین ضروری است اپلیکیشنهای هوش مصنوعی از نظر پیکربندی اشتباه یا ناسازگار بررسی شوند، چرا که همین نقاط ضعف ساده میتوانند راه نفوذ مهاجمان باشند. هدف نهایی این است که مسیرهای حمله در کل پایپلاین هوش مصنوعی، از دادههای حساس آموزشی و کلیدهای فاششده گرفته تا هویتها و دسترسیهای شبکه، پیش از آنکه به تهدیدی در محیط عملیاتی تبدیل شوند، شناسایی شوند.

در کنار این موارد، تستهای کارکردی (Functional Testing) نیز یک ضرورت است. برای اطمینان از ایمنی عملکردهای اصلی، این تستها باید شامل بررسیهای خاص هوش مصنوعی باشند؛ مثل تحلیل سوگیری و انصاف که میتواند به مدیریت سه دسته اصلی سوگیریهای AI از نظر NIST کمک کند:

- سیستمی (Systemic Bias)

- محاسباتی و آماری (Computational/Statistical Bias)

- شناختی انسانی (Human-Cognitive Bias)

ادغام تستهای امنیتی هوش مصنوعی در پایپلاین CI/CD کلید اصلی برای شناسایی و رفع زودهنگام آسیبپذیریها در چرخه توسعه نرمافزار است. همچنین، تست مداوم و منظم تنها راه حفظ یک وضعیت امنیتی پایدار و پیشگیرانه خواهد بود.

۷- بر پایش مداوم تمرکز کنید

تست کردن بهتنهایی کافی نیست. با توجه به ماهیت پویا و ذاتا غیرقطعی سیستمهای هوش مصنوعی، نظارت مداوم یک ضرورت است. تمرکز بر پایش مستمر به شما کمک میکند تا اکوسیستم هوش مصنوعی را ایمن و قابلاعتماد نگه دارید و بتوانید در برابر رفتارهای غیرمنتظره یا سوءاستفادههای احتمالی واکنش سریع و موثر نشان دهید.

یک سیستم قدرتمند برای پایش اپلیکیشنهای هوش مصنوعی و زیرساختهای مرتبط ایجاد کنید تا بتوانید ناهنجاریها و مشکلات احتمالی را در لحظه شناسایی کنید. فرایند پایش بلادرنگ باید شاخصهای کلیدی عملکرد، خروجی مدلها، تغییرات توزیع داده، نوسانات عملکرد مدل و سایر رفتارهای سیستمی را دنبال کند.

با ادغام هشدارها و مکانیزمهای واکنش خودکار که بر اساس همین سیستمهای تشخیص تهدید بلادرنگ فعال میشوند، میتوانید رخدادهای امنیتی را بهموقع شناسایی و مدیریت کنید. این کار باعث کاهش ریسکها و به حداقل رساندن تاثیر فعالیتهای خصمانه خواهد شد.

۸- افزایش آگاهی کارکنان نسبت به تهدیدها و ریسکها

با بلوغ چارچوب هوش مصنوعی در سازمان و همگام شدن آن با پیشرفتهای حوزهی SecOps برای AI، تیمهای امنیتی باید بخشی از زمان خود را صرف آموزش کارکنان درباره تهدیدات و ریسکها کنند تا هر کاربر هوش مصنوعی حداقل اصول امنیتی پایه را رعایت کند.

در گام نخست، بهترین روش این است که تیمهای امنیتی با تیمهای علوم داده همکاری کنند تا راهنماهای امنیتی روشن و مختصر تدوین شود. این راهنماها باید بهگونهای طراحی شوند که ضمن تامین الزامات امنیتی، فضای کافی برای آزمایش و نوآوری در اختیار تیمهای علوم داده قرار دهند. به این ترتیب، احتمال بیتوجهی یا دور زدن کنترلهای امنیتی توسط این تیمها برای بهرهبرداری از ظرفیتهای هوش مصنوعی به حداقل میرسد.

پس از تدوین نخستین راهنماهای امنیتی، لازم است دورههای آموزشی جامع برای همهی کارکنان برگزار شود تا کل نیروی کار دانش کافی برای استفاده ایمن از هوش مصنوعی را به دست آورد. چنین آگاهیبخشی مشترکی نهتنها خطر رخدادهای ناخواسته امنیتی را کاهش میدهد، بلکه این امکان را فراهم میکند که کارکنان بهطور مستقیم در تقویت وضعیت امنیتی سازمان مشارکت کنند.

انطباق و چارچوبهای مقرراتی در هوش مصنوعی

رشد سریع استفاده از هوش مصنوعی، موجی از قوانین و چارچوبهای انطباقی جدید را به دنبال داشته است. سازمانها برای جلوگیری از جریمههای قانونی و ایجاد اعتماد نزد مشتریان باید این مسیر پیچیده مقرراتی را با دقت طی کنند. اتخاذ رویکردی پیشگیرانه در زمینه انطباق، لازمه استقرار مسئولانه هوش مصنوعی است.

مقررات و چارچوبهای کلیدی

امروزه چندین چارچوب مهم در حال شکلدهی به حاکمیت هوش مصنوعی در سطح جهانی هستند:

- قانون هوش مصنوعی اتحادیه اروپا (EU AI Act): این قانون سیستمهای هوش مصنوعی را بر اساس سطح ریسک دستهبندی میکند و برای کاربردهای پرریسک الزامات سختگیرانهای در نظر گرفته است. علاوه بر این، برای مدلهای عمومی هوش مصنوعی نیز مقرراتی وضع شده که قرار است ۱۲ ماه پس از انتشار رسمی قانون اجرایی شوند.

- چارچوب مدیریت ریسک هوش مصنوعی NIST (AI RMF) در ایالات متحده: این چارچوب بهصورت داوطلبانه راهنماییهایی برای مدیریت ریسکهای مرتبط با هوش مصنوعی ارائه میدهد و هدف آن کمک به سازمانها برای توسعه و استفاده مسئولانه و قابلاعتماد از سیستمهای هوش مصنوعی است.

- مقررات صنایع خاص: برای مثال، در حوزه سلامت، قانون HIPAA الزامات ویژهای برای نحوه استفاده از هوش مصنوعی در کنار دادههای حساس بیماران دارد.

اصول کلیدی انطباق

بیشتر مقررات مربوط به هوش مصنوعی بر مجموعهای از اصول کلیدی استوار هستند؛ از جمله شفافیت، انصاف، مسئولیتپذیری و حفظ حریم خصوصی. سازمان شما باید بتواند نشان دهد که سیستمهای هوش مصنوعیاش در عمل مطابق با این اصول کار میکنند. این موضوع شامل اقداماتی مانند:

- مستندسازی شفاف (برای مثال از طریق کارتهای مدل)

- ممیزی برای شناسایی سوگیریها

- اطمینان از انطباق شیوههای مدیریت داده با قوانین مربوط به حریم خصوصی

دستیابی به انطباق و اثبات آن

برای سادهسازی فرایند انطباق، میتوانید از ابزارهای امنیتی استفاده کنید که کنترلهای امنیتی شما را به الزامات مقرراتی مشخص نگاشت میکنند. این کار ارائه مستندات به ممیزها و ذینفعان را بسیار آسانتر میکند.

برای نمونه، پلتفرم Wiz به سازمانها کمک میکند تا وضعیت امنیتی هوش مصنوعی خود را با چارچوبهای اصلی مثل NIST تطبیق دهند. این ابزار با گردآوری خودکار شواهد و ارائه بررسیهای آماده انطباق، روند اثبات ایمنی در طراحی و اجرای سیستمهای هوش مصنوعی را تسهیل کرده و سازمان را برای ممیزیها و الزامات قانونی آماده میکند.

نتیجهگیری

هشت روش برتری که در این مقاله مطرح شد، با هدف توانمندسازی تیمها برای امنیت در هوش مصنوعی و ایمنسازی سریع پایپلاینهای موجود، همچنین پذیرش سریع و ایمن راهکارهای جدید هوش مصنوعی طراحی شدهاند. تمرکز بر چابکی و سازگاری برای سازمانهایی که میخواهند در این چشمانداز متحول و پویا، هوش مصنوعی را بهصورت موفق و ایمن ادغام کنند، حیاتی است. برای ایجاد چنین چارچوب استاندارد و چابک در حوزه امنیت، باید به دنبال راهکارهایی باشید که بهبود فرایندها را در اولویت قرار میدهند، نه صرفاً نگهداری زیرساختها را.

منابع

دیدگاهتان را بنویسید